Raspe lo que le importa a su empresa en Internet con estas potentes herramientas de web scraping basadas en la nube.

Las soluciones de web scraping basadas en la nube han surgido como una herramienta vital para las empresas y los particulares que buscan extraer datos valiosos y reveladores de Internet.

Ahora, echemos un breve vistazo a las herramientas que presentaremos en esta lista. Esta lista se basa en horas de investigación y debería facilitarle enormemente su trabajo de web scraping.

Este post explora soluciones populares de raspado web basadas en la nube que ofrecen capacidades de raspado eficientes y fiables.

¡Impulse sus esfuerzos de extracción de datos hoy mismo!

Ahora, sumerjámonos en la lista y descubramos por qué el raspado web es más fácil que nunca, ¡gracias a estas increíbles herramientas!

Scrapestack

Raspe todo lo que quiera en Internet con Scrapestack.

Con más de 35 millones de IP, nunca tendrá que preocuparse de que se bloqueen las solicitudes al extraer páginas web. Cuando realiza una llamada REST-API, las solicitudes se envían a través de más de 100 ubicaciones globales (dependiendo del plan) a través de una infraestructura fiable y escalable.

Puede ponerlo en marcha GRATIS para ~10.000 peticiones con soporte limitado. Una vez que esté satisfecho, puede optar por un plan de pago. Scrapestack está preparado para empresas, y algunas de sus características son las siguientes.

- Renderizado JavaScript

- Cifrado HTTPS

- Proxies premium

- Peticiones concurrentes

- Sin CAPTCHA

Con la ayuda de su buena documentación de API, puede empezar en cinco minutos con ejemplos de código para PHP, Python, Nodejs, jQuery, Go, Ruby, etc.

Bright Data

Bright Data le ofrece la plataforma de datos web número 1 del mundo. Le permite recuperar los datos web públicos que le interesan. Proporciona dos soluciones de Web Scraping basadas en la nube:

Bright Data Web Unlocker

Bright Data Web Unlocker es una herramienta automatizada de desbloqueo de sitios web que llega a los sitios web objetivo con tasas de éxito impredecibles. Le proporciona los datos web más precisos disponibles con una potente tecnología de desbloqueo con una sola solicitud.

Web Unlocker gestiona las huellas dactilares del navegador, es compatible con los códigos existentes, ofrece una opción de selección automática de IP y permite la gestión de cookies y el IP Priming. También puede validar automáticamente la integridad del contenido basándose en los tipos de datos, el contenido de la respuesta, el momento de la solicitud, etc.

Su precio es de 300 $/mes. También puede optar por un plan de pago por uso a 5 $/CPM.

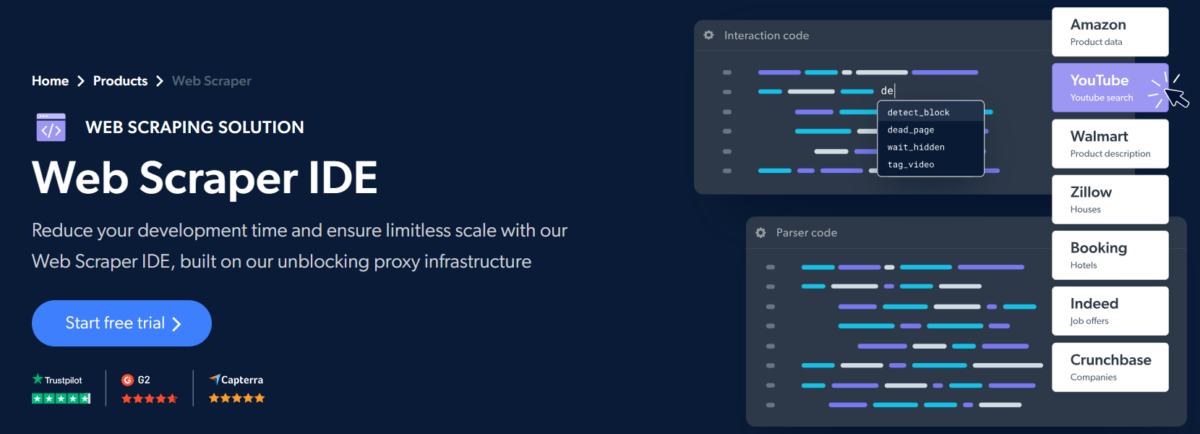

Bright Data Web Scraper IDE

Web Scraper IDE de Bright Data es una herramienta alojada en la nube para ayudar a los desarrolladores a codificar rápidamente los raspadores basados en JavaScript. Cuenta con funciones preconstruidas y plantillas de código para extraer datos de los principales sitios web sin esfuerzo, reduciendo un 75% el tiempo de desarrollo y ofreciendo una gran escalabilidad.

La consola indica una vista previa interactiva en tiempo real para depurar los errores al instante. Además, las herramientas de depuración nativas ayudan a analizar rastreos anteriores para optimizar los siguientes.

Web Scraper IDE proporciona un control de primera categoría sin la molestia de mantener una infraestructura de desbloqueo y proxies. Gracias a su tecnología de desbloqueo incorporada, podrá obtener datos web de cualquier ubicación, incluso de recursos protegidos por CAPTCHA.

Puede programar rastreos, conectar su API a los principales almacenamientos en la nube (Amazon S3, Microsoft Azure, etc.) o integrarse con webhooks para obtener los datos en el lugar que prefiera. La mayor ventaja es que Web Scraper IDE funciona respetando las políticas globales de protección de datos.

Dispone de una versión de prueba gratuita, paquetes mensuales y planes de pago por uso, lo que ofrece una excelente flexibilidad para la mayoría de los casos de uso.

Oxylabs

La API de raspado web de Oxylabs es una de las herramientas más sencillas para extraer datos de sitios web simples a complejos, incluido el comercio electrónico.

La recuperación de datos es rápida y precisa gracias a su exclusivo rotador de proxy incorporado y a la renderización de JavaScript, y usted sólo paga por los resultados que se entregan correctamente.

Independientemente de dónde se encuentre, la API de Web Scraper le permite acceder a datos de 195 países diferentes.

Ejecutar un scraper requiere mantener una infraestructura que requiere un mantenimiento periódico; Oxylabs ofrece una infraestructura sin mantenimiento, por lo que ya no tendrá que preocuparse por las prohibiciones de IP u otros problemas.

Sus esfuerzos de scrapping tendrán éxito más a menudo, ya que puede reintentar automáticamente los intentos de scraping fallidos.

Aquí tiene una lista de las características que Oxylabs proporciona a sus usuarios. Por supuesto, ¡éstas son sólo algunas de muchas!

- Enorme pool de proxies de 102M.

- Raspado masivo de hasta 1000 URL.

- Automatiza las actividades rutinarias de scraping.

- Puede recuperar los resultados del scraping a AWS S3 o GCS

Oxylabs scraping es gratis para probar durante una semana, y los planes de inicio comienzan en $99 mensuales.

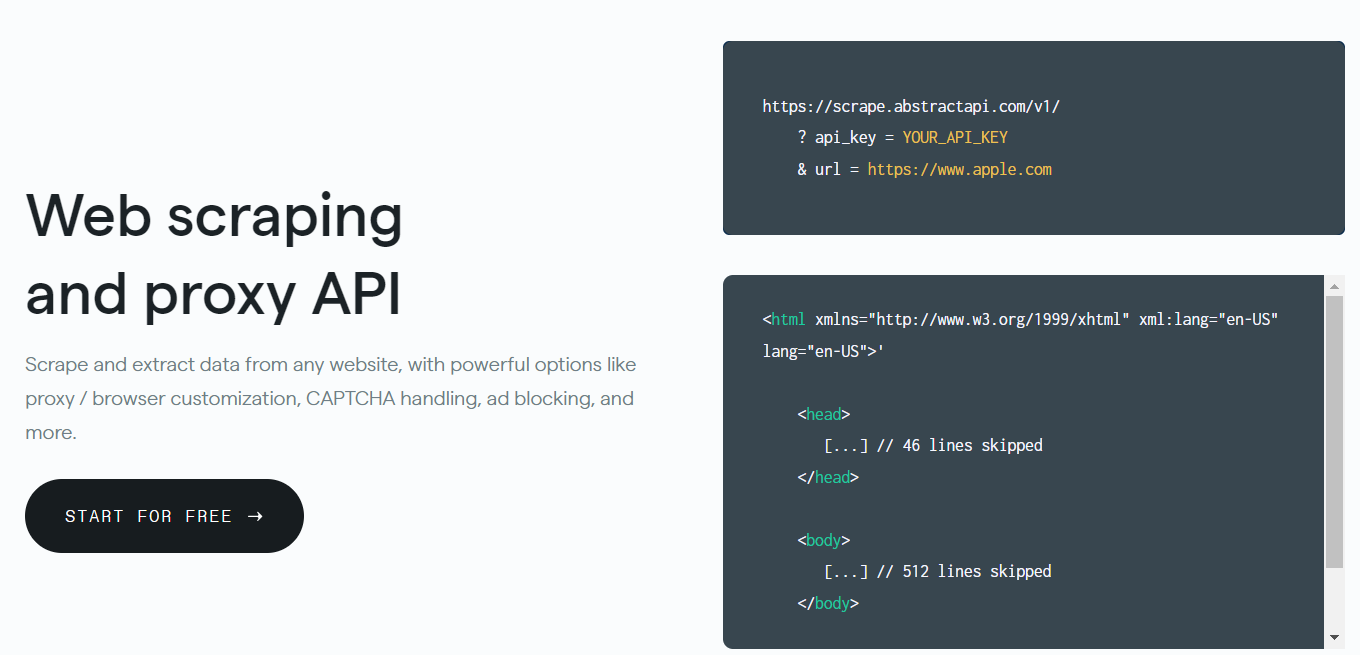

Abstract API

Abstract es una potente API, y no le dejará indiferente después de utilizar su API de Web Scraping. Este producto hecho para desarrolladores es rápido y altamente personalizable.

Puede elegir entre 100 servidores globales para realizar las solicitudes de la API de raspado sin preocuparse por el tiempo de inactividad.

Además, sus millones de IP y proxies en constante rotación garantizan una extracción de datos sin problemas a escala. Y puede estar seguro de que sus datos están a salvo con la encriptación SSL de 256 bits.

Por último, puede probar Abstract Web Scraping API de forma gratuita con un plan de 1000 solicitudes API y pasar a suscripciones de pago según sus necesidades.

ParseHub

ParseHub le ayuda a desarrollar raspadores web para rastrear sitios web individuales y varios con la asistencia para JavaScript, AJAX, cookies, sesiones e interruptores utilizando su aplicación de escritorio e implementarlos en su servicio en la nube. Parsehub ofrece una versión gratuita en la que dispondrá de 200 páginas de estadísticas en 40 minutos, cinco proyectos comunitarios y un soporte limitado.

Octoparse

Le encantarán los servicios de Octoparse. Este servicio proporciona una plataforma basada en la nube para que los usuarios impulsen sus tareas de extracción construidas con la aplicación de escritorio Octoparse.

Echemos un vistazo a algunas de las características de Octoparse.

- La herramienta «apuntar y hacer clic» es transparente de configurar y utilizar

- Admite sitios web con mucho Javascript

- Puede ejecutar hasta 10 raspadores en el ordenador local si no necesita mucha escalabilidad

- Incluye rotación automática de IP en todos los planes

Para probar Octoparse, puede iniciar su prueba gratuita y, si le gustan sus características, el plan estándar comienza en 75 dólares al mes.

Zyte

Zyte cuenta con una herramienta de extracción automatizada impulsada por IA que le permite obtener los datos en un formato estructurado en cuestión de segundos. Es compatible con 40 idiomas y extrae datos de todo el mundo. Cuenta con un mecanismo automático de rotación de IP incorporado para que su dirección IP no sea baneada.

Zyte dispone de una API HTTP con la opción de acceder a múltiples tipos de datos. También le permite entregar directamente los datos en su cuenta de Amazon S3.

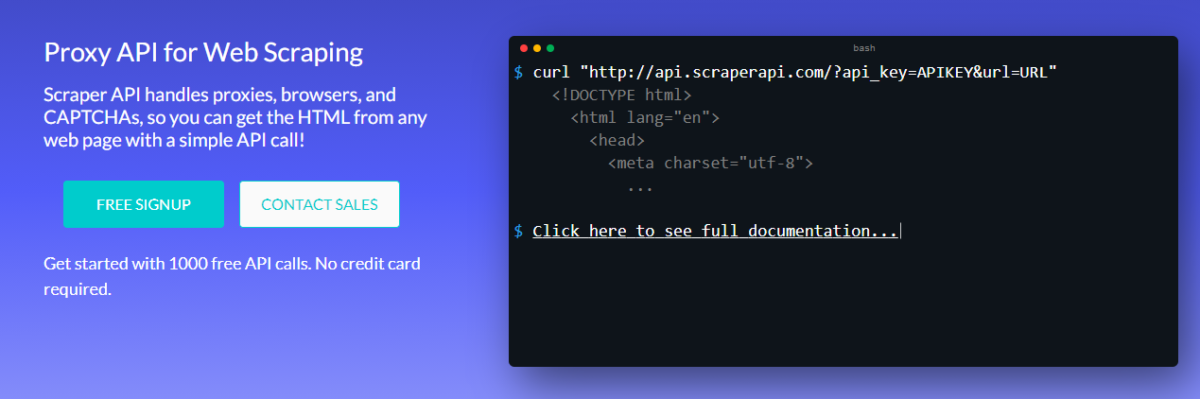

ScraperAPI

Obtendrá 1000 llamadas API gratuitas con ScraperAPI, que puede manejar proxies, navegadores y CAPTCHAs como un profesional. Gestiona más de 5.000 millones de solicitudes de API cada mes para más de 1.500 empresas, y creo que una de las muchas razones para ello es porque su scraper nunca se bloquea mientras cosecha la web. Utiliza millones de proxies para rotar las direcciones IP e incluso recupera las solicitudes fallidas.

Lea también: Los mejores servicios/API de resolución de captchas para el raspado web y la automatización

Es fácil de poner en marcha, es rápido y, curiosamente, también muy personalizable. Puede renderizar Javascript para personalizar las cabeceras de las solicitudes, el tipo de solicitud, la geolocalización IP y mucho más. También hay una garantía de tiempo de actividad del 99,9%, y usted obtiene ancho de banda ilimitado.

Obtenga un 10% de descuento con el código promocional – GF10

ScrapingBee

ScrapingBee es otro servicio asombroso que rota proxies para usted y puede manejar navegadores sin cabeza mientras que tampoco se bloquea. Es muy personalizable utilizando fragmentos de JavaScript y, en general, se puede utilizar para fines de SEO, growth hacking, o simplemente raspado general.

Lea también: Introducción al Web Scraping en JavaScript

Lo utilizan algunas de las empresas más destacadas, como WooCommerce, Zapier y Kayak. Puede empezar de forma gratuita antes de actualizar a un plan de pago, a partir de sólo 29 $/mes.

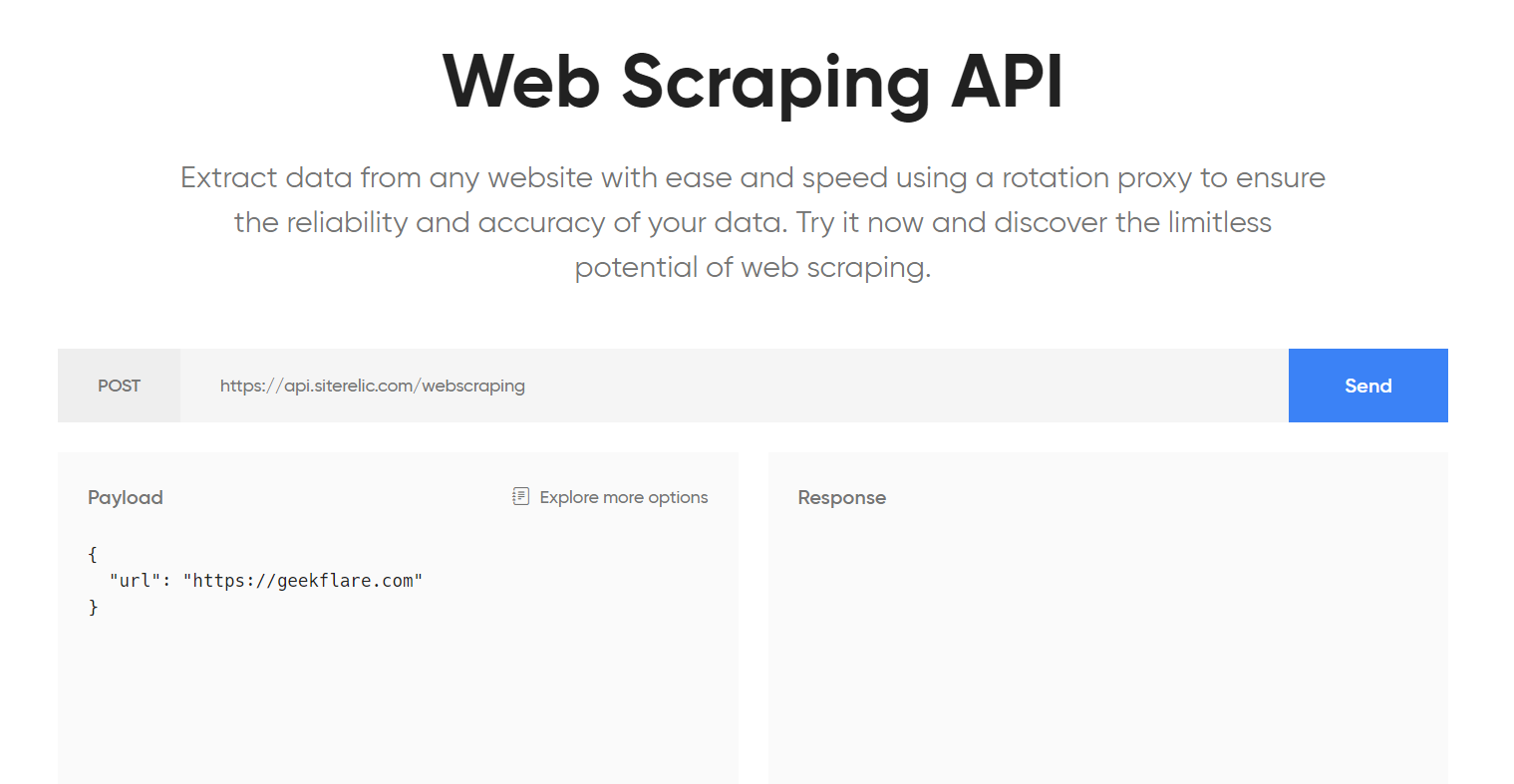

Siterelic

Apuntalada por AWS, la API de Web Scraping de Siterelic es de lo más fiable. Le ayuda a extraer datos utilizando un ordenador de sobremesa, un móvil o una tableta y es compatible con la renderización de JavaScript.

Esta API presume de un elevado tiempo de actividad y de proxies rotatorios para evitar que se bloquee.

Además, es extremadamente rápido empezar con la documentación de la API disponible, que incluye ilustraciones para cURL, Node.js, Python, Ruby y PHP.

Puede empezar con el plan gratuito con 500 peticiones al mes. La suscripción premium comienza en 10 dólares al mes por 10.000 peticiones y añade ventajas como un límite mayor de peticiones por segundo y proxies rotatorios.

Apify

Apify tiene un montón de módulos llamados actores para hacer procesamiento de datos, convertir páginas web en API, transformación de datos, rastrear sitios, ejecutar Headless Chrome, etc. Es la mayor fuente de información jamás creada por la humanidad.

Algunos de los actores ya preparados pueden ayudarle a ponerlo en marcha rápidamente para hacer lo siguiente.

- Convertir una página HTML en PDF

- Rastrear y extraer datos de páginas web

- Scraping de búsqueda de Google, Google Places, Amazon, Booking, hashtag de Twitter, Airbnb, Hacker News, etc

- Comprobación del contenido de las páginas web (control de la desfiguración)

- Analizar el SEO de la página

- Comprobar enlaces rotos

y mucho más para construir el producto y los servicios para su negocio.

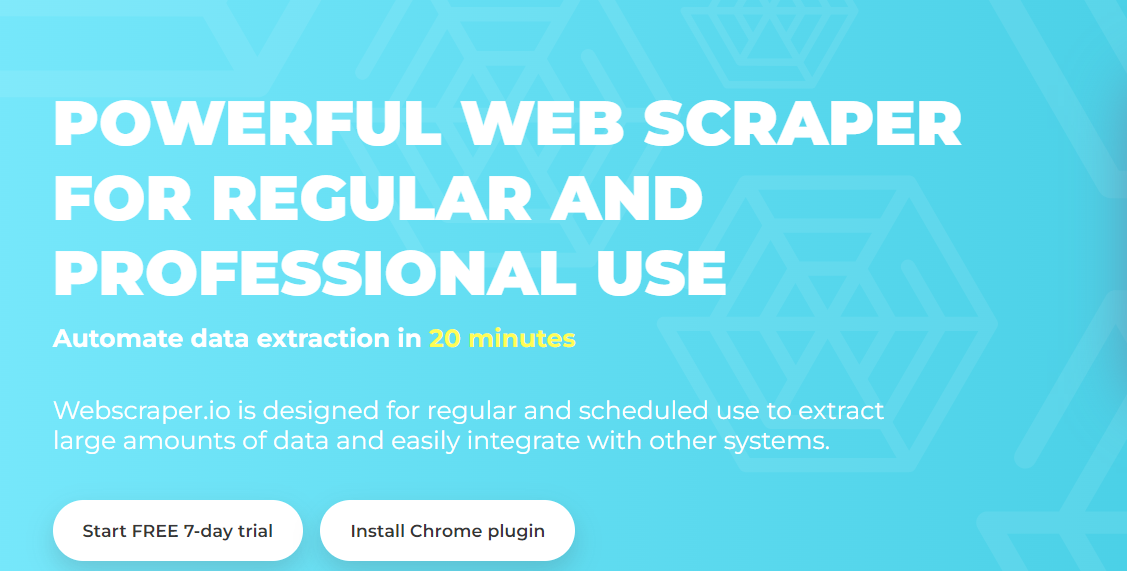

Web Scraper

Web Scraper, una herramienta imprescindible, es una plataforma en línea en la que puede desplegar raspadores construidos y analizados mediante la extensión gratuita para Chrome «apuntar y hacer clic». Utilizando la extensión, usted elabora «mapas del sitio» que determinan cómo se deben pasar y extraer los datos. Puede escribir los datos rápidamente en CouchDB o descargarlos como un archivo CSV.

He aquí un vistazo a algunas de las características que obtendrá con Web Scraper:

- Puede empezar de inmediato, ya que la herramienta es de lo más sencilla e incluye excelentes vídeos tutoriales.

- Soporta sitios web con javascript pesado

- Su extensión es de código abierto, por lo que no se quedará encerrado con el proveedor si la oficina cierra

- Admite proxies externos o rotación de IP

Garantiza la extracción automatizada de datos en 20 minutos, tanto si lo utiliza con fines habituales como profesionales.

Mozenda

Mozenda es especial para empresas que buscan una plataforma de raspado de páginas web de autoservicio basada en la nube que no necesitan buscar más. Le sorprenderá saber que con más de 7.000 millones de páginas raspadas, Mozenda tiene el sentido de servir a clientes empresariales de toda la provincia.

Mozenda tiene un montón de características, que no se limitan a:

- Creación de plantillas para agilizar el flujo de trabajo

- Crear secuencias de trabajo para automatizar el flujo

- Raspar datos específicos de la región

- Bloquear solicitudes de dominios no deseados

Puede probar Mozenda gratis durante los primeros 30 días. Para obtener los precios, sin embargo, tendrá que ponerse en contacto con sus representantes.

Diffbot

Diffbot le permite configurar rastreadores que pueden trabajar en sitios web e indexarlos y luego tratarlos utilizando sus API automáticas para la extracción de determinados datos de diferentes contenidos web. Además, puede crear un extractor personalizado si una API de extracción de datos específica no funciona para los sitios que necesita.

El gráfico de conocimiento de Diffbot le permite consultar la web en busca de datos enriquecidos.

Ahora que hemos hablado de las mejores herramientas de web scraping, analicemos qué es el web scraping y examinemos cómo funcionan las herramientas de web scraping y por qué son extremadamente útiles hoy en día.

¿Qué es el Web Scraping?

El término web scraping hace referencia a diferentes métodos de recopilación de información y datos esenciales de Internet. También se denomina extracción de datos web, screen scraping o web harvesting.

Hay muchas formas de hacerlo

- Manualmente – se accede a la página web y se comprueba lo que se necesita.

- Automática – utilice las herramientas necesarias para configurar lo que necesita y deje que las herramientas trabajen por usted.

Si elige la forma automática, puede instalar el software necesario usted mismo o aprovechar la solución basada en la nube.

Si está interesado en configurar el sistema por sí mismo, entonces eche un vistazo a estos mejores marcos de trabajo de raspado web.

¿Por qué Web Scraping basado en la nube?

Como desarrollador, es posible que sepa que el web scraping, el HTML scraping, el web crawling y cualquier otra extracción de datos web pueden ser muy complicados. Para obtener el origen correcto de la página, determinar la fuente con precisión, renderizar JavaScript y recopilar datos de forma utilizable, hay mucho trabajo por hacer.

Necesita conocer el software, dedicar horas a la configuración para obtener los datos deseados, alojarse usted mismo, preocuparse por si le bloquean (no le pasará nada si consulta nuestra lista de los mejores proxy de rotación de IP), etc. En su lugar, puede utilizar una solución basada en la nube para descargar todos los quebraderos de cabeza al proveedor, y usted podrá centrarse en extraer datos para su negocio.

Así pues, el raspado web basado en la nube le ahorra tiempo y protege su privacidad. Si necesita más razones para convencerse, veamos cómo puede ayudar a su negocio en crecimiento.

¿Cómo ayuda a las empresas?

- Puede obtener feeds de productos, imágenes, precios y otros detalles relacionados con el producto de varios sitios y hacer su almacén de datos o sitio de comparación de precios.

- Puede examinar el funcionamiento de cualquier producto en particular, el comportamiento de los usuarios y los comentarios que necesite.

- En esta era de la digitalización, a las empresas les preocupa mucho el gasto en gestión de la reputación en línea. Por ello, el web scraping es necesario también en este caso.

- Se ha convertido en una práctica habitual que las personas lean opiniones y artículos en línea para diversos fines. Por lo tanto, es crucial eliminar la impresión de spam.

- Mediante el scraping de los resultados de las búsquedas orgánicas, puede averiguar al instante quiénes son sus competidores en SEO para un término de búsqueda específico. Puede averiguar las etiquetas de los títulos y las palabras clave que otros están planificando.

Lea también: La mejor API SERP de Google para raspar resultados de búsqueda en tiempo real

Con ventajas tan asombrosas, es prudente utilizar estas herramientas de raspado web basadas en la nube para el análisis de la competencia, la gestión de la reputación de su empresa y la solución detallada de cualquier problema que pueda surgir.

Palabras finales

Es bastante notable saber que casi no hay datos que no pueda obtener mediante la extracción de datos web utilizando estos raspadores web.