Si vous vous intéressez à l’IA, cet article vous aidera certainement à plonger dans ses subtilités. Je suis ici pour vous guider dans votre voyage dans le royaume des plateformes LLMOps et vous fournir des éclaircissements sur les outils cruciaux offerts pour tester, améliorer et déployer les LLM.

Les plateformes présentées dans cet article jouent un rôle essentiel dans l’exploitation du plein potentiel des modèles de langage, en proposant des solutions innovantes pour le développement et la gestion.

Des organisations réputées telles que Google, OpenAI et Microsoft exploitent les plateformes LLMOps pour garantir des tests approfondis, un perfectionnement continu et un déploiement efficace de leurs modèles de langage, ce qui permet d’obtenir des résultats fiables et précis.

Sachant que les LLMOps sont peut-être nouveaux pour beaucoup, commençons par acquérir une compréhension de base des LLMOps : leur signification, leurs fonctions et leurs avantages.

Sur cette base, nous pourrons alors passer à notre objectif principal : identifier les outils optimaux pour nos lecteurs en fonction de leurs besoins spécifiques. L’article principal de cet article sert de guide pour atteindre cet objectif.

Qu’est-ce que LLMOps ?

LLMOps est l’acronyme de Language Model Operations. Il s’agit de la gestion, du déploiement et de l’amélioration de grands modèles de langage tels que ceux utilisés dans l’IA. Les LLMOps impliquent des outils et des processus pour former, tester et maintenir ces modèles, afin de s’assurer qu’ils fonctionnent bien et qu’ils restent précis au fil du temps.

Bien que les LLM soient faciles à prototyper, leur utilisation dans des produits commerciaux pose des problèmes. Le cycle de développement des LLM comprend des étapes complexes telles que la préparation des données, la mise au point du modèle et le déploiement, ce qui nécessite un travail d’équipe sans faille. LLMOps couvre ce cycle, assurant une expérimentation, un déploiement et une amélioration en douceur.

Enfin, j’aimerais que vous compreniez ce qu’est la plateforme LLMOps, car cela vous apportera une clarté précise, et vous engager dans cette voie vous donnera certainement un bon résultat après l’avoir lu.

La plateforme LLMOps favorise la collaboration entre les scientifiques et les ingénieurs des données, en aidant à l’exploration itérative des données. Elle permet le co-working en temps réel, le suivi des expériences, la gestion des modèles et le déploiement contrôlé des LLM. LLMOps automatise les opérations, la synchronisation et la surveillance tout au long du cycle de vie du ML.

Comment fonctionne LLMOps ?

Les plateformes LLMOps simplifient l’ensemble du cycle de vie des modèles de langage. Elles centralisent la préparation des données, permettent l’expérimentation et la mise au point pour des tâches spécifiques. Ces plateformes facilitent également le déploiement, la surveillance continue et le passage d’une version à l’autre.

La collaboration est encouragée, les erreurs sont minimisées grâce à l’automatisation et l’amélioration continue est prise en charge. Par essence, LLMOps optimise la gestion des modèles linguistiques pour diverses applications.

Avantages de LLMOps

Les principaux avantages que je trouve significatifs sont l’efficacité, la précision et l’évolutivité. Voici une version élaborée des avantages offerts par LLMOps :

- Efficacité : Les plateformes LLMOps optimisent le cycle complet de développement, de test et de déploiement des modèles de langue, ce qui permet de gagner du temps et de l’énergie.

- Collaboration : Ces plateformes favorisent une coopération transparente entre les scientifiques des données, les ingénieurs et les parties prenantes, promouvant ainsi un travail d’équipe efficace.

- Précision : Les LLMOps maintiennent et améliorent la précision des modèles au fil du temps en les contrôlant et en les affinant en permanence.

- Automatisation : LLMOps automatise plusieurs tâches, y compris le prétraitement et la surveillance des données, réduisant ainsi le besoin d’intervention manuelle.

- Évolutivité : En augmentant efficacement la taille des modèles, les plateformes LLMOps peuvent facilement s’adapter à des charges de travail ou à des demandes accrues.

- Facilité de déploiement : Les LLMOps garantissent que les modèles sont intégrés en douceur dans les applications ou les systèmes, minimisant ainsi les défis liés au déploiement.

Par essence, les LLMOps améliorent l’efficacité, la précision et l’évolutivité tout en favorisant la collaboration, l’automatisation et le déploiement en douceur.

Passons maintenant à notre liste de plateformes. Cette liste est un guide de Geekflare, mais la décision de choisir la meilleure pour vous, en fonction de vos exigences et de vos besoins, est entre vos mains.

Dify

Êtes-vous intrigué par les progrès rapides des technologies LLM telles que GPT-4 et enthousiasmé par leur potentiel pratique ? Dify est conçu pour vous satisfaire. Il permet aux développeurs, et même à ceux qui n’ont pas de connaissances techniques approfondies, de créer rapidement des applications utiles en utilisant des modèles linguistiques étendus. Ces applications ne sont pas seulement conviviales, elles sont destinées à être améliorées en permanence.

Caractéristiques principales :

- Plate-forme LLMOps conviviale: Développez sans effort des applications d’IA à l’aide de GPT-4 et gérez-les visuellement.

- IA contextuelle avec vos données: Utilisez des documents, du contenu web ou des notes de Notion comme contexte d’IA. Dify prend en charge le prétraitement et plus encore, ce qui vous permet de gagner du temps de développement.

- Libérez le potentiel de LLM: Dify assure un accès transparent au modèle, l’intégration du contexte, le contrôle des coûts et l’annotation des données pour une création fluide de l’IA.

- Modèles prêts à l’emploi: Choisissez parmi les modèles de dialogue et de génération de texte, prêts à être personnalisés pour vos applications spécifiques.

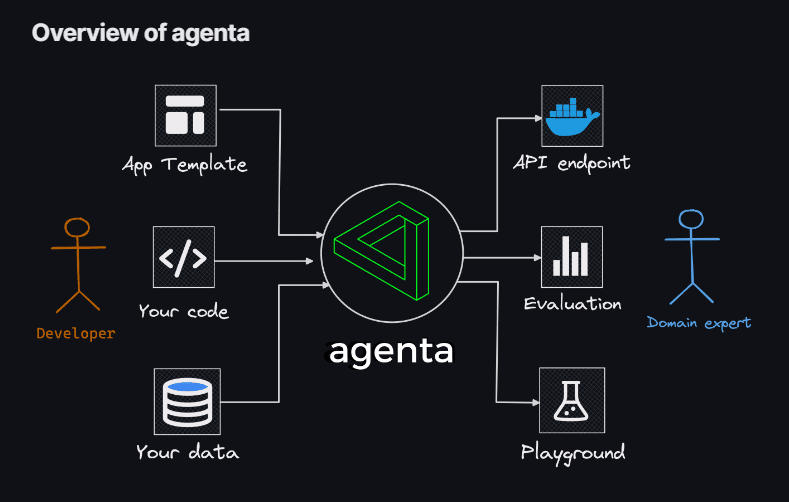

Agenta

Si vous recherchez la flexibilité d’utiliser le codage pour créer des applications LLM, sans les contraintes des modèles, des bibliothèques ou des frameworks, alors Agenta est votre solution. Agenta est une plateforme open-source de bout en bout conçue pour rationaliser le processus de mise en production d’applications LLM (Large Language Model) complexes.

Avec Agenta, vous pouvez rapidement expérimenter et modifier les messages-guides, les paramètres et les stratégies complexes. Cela englobe l’apprentissage in-context avec des embeddings, des agents et une logique commerciale personnalisée.

Caractéristiques principales :

- Exploration des paramètres: Spécifiez les paramètres de votre application directement dans votre code et expérimentez-les sans effort via une plateforme web intuitive.

- Évaluation des performances: Évaluez l’efficacité de votre application sur des ensembles de tests en utilisant une variété de méthodologies telles que la correspondance exacte, AI Critic, l’évaluation humaine, et plus encore.

- Cadre de test: Créez des ensembles de tests sans effort à l’aide de l’interface utilisateur, que ce soit en téléchargeant des fichiers CSV ou en vous connectant de manière transparente à vos données via notre API.

- Environnement collaboratif: Favorisez le travail d’équipe en partageant votre application avec des collaborateurs et en les invitant à vous faire part de leurs commentaires et de leurs idées.

- Déploiement facile: Lancez votre application en tant qu’API en un seul clic, rationalisant ainsi le processus de déploiement.

En outre, Agenta favorise la collaboration avec des experts du domaine pour une ingénierie et une évaluation rapides. Un autre point fort est la capacité d’Agenta à évaluer systématiquement vos applications LLM et à faciliter le déploiement de votre application en un seul clic.

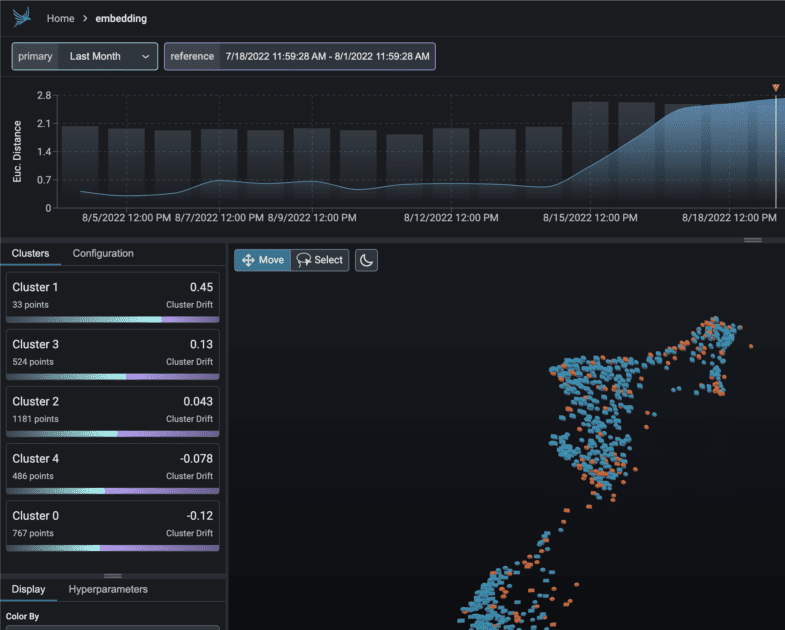

Phoenix

Embarquez pour un voyage instantané dans les perspectives MLOps grâce à Phoenix. Cet outil ingénieux permet d’observer en toute transparence la performance des modèles, la dérive et la qualité des données, le tout sans le fardeau de configurations complexes.

En tant que bibliothèque Python avant-gardiste centrée sur les carnets de notes, Phoenix exploite la puissance des embeddings pour déterrer les complexités cachées dans les modèles LLM, CV, NLP et tabulaires. Améliorez vos modèles grâce aux capacités inégalées de Phoenix.

Caractéristiques principales :

- Investigation de la dérive intégrée: Plongez dans les nuages de points UMAP pendant les cas de distance euclidienne importante et identifiez les groupes de dérives.

- Analyse de la dérive et des performances par regroupement: Déconstruisez vos données en groupes de dérives significatives ou de performances médiocres grâce à HDBSCAN.

- Analyse exploratoire des données à l’aide de l’UMAP: Nuancez vos nuages de points UMAP en fonction des attributs, de la dérive et des performances de votre modèle, en dévoilant les segments problématiques.

LangKit

LangKit est une boîte à outils open-source pour les métriques de texte, conçue pour contrôler efficacement les modèles de langage de grande taille.

La force motrice derrière la création de LangKit provient de la prise de conscience que la transformation des modèles de langage, y compris les LLM, en production comporte plusieurs risques. Les innombrables combinaisons d’entrées potentielles, conduisant à des sorties tout aussi nombreuses, représentent un défi considérable.

Caractéristiques principales :

- Analyse rapide des injections: Évaluez les scores de similarité avec les attaques d’injection rapide reconnues.

- Analyse des sentiments: Évaluez la tonalité des sentiments dans le texte.

- Évaluation de la qualité du texte: Évaluez la lisibilité, la complexité et les notes.

- Détection d’évasion: Identifiez les scores de similarité avec les tentatives connues d’évasion.

- Analyse de la toxicité: Détecte les niveaux de toxicité dans le contenu fourni.

La nature non structurée du texte complique encore les choses dans le domaine de l’observabilité du ML – un défi qui mérite d’être résolu. Après tout, l’absence de compréhension du comportement d’un modèle peut avoir des répercussions importantes.

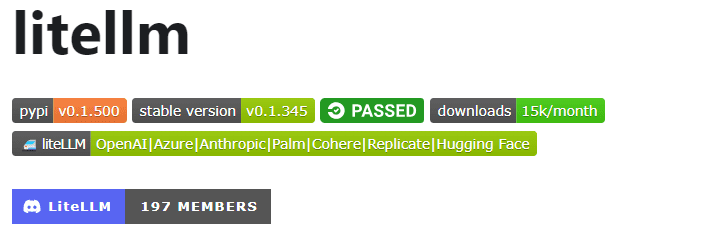

LiteLLM

Avec LiteLLM, simplifiez vos interactions avec diverses API LLM – Anthropic, Huggingface, Cohere, Azure OpenAI, et plus encore – en utilisant un package léger au format OpenAI.

Ce paquetage rationalise le processus d’appel des points d’extrémité d’API de fournisseurs comme OpenAI, Azure, Cohere et Anthropic. Il traduit les entrées vers les points de terminaison de complétion et d’intégration du fournisseur concerné, garantissant ainsi un résultat uniforme. Vous pouvez toujours accéder aux réponses textuelles à [‘choices’][0][‘message’][‘content’].

Caractéristiques principales:

- Appel simplifié de l’API LLM: Simplifie l’interaction avec les API LLM comme Anthropic, Cohere, Azure OpenAI, etc.

- Paquet léger: Une solution compacte pour appeler OpenAI, Azure, Cohere, Anthropic et les points d’extrémité des API.

- Traduction des entrées: Gère la traduction des entrées vers les points d’extrémité de complétion et d’intégration des fournisseurs respectifs.

- Cartographie des exceptions: Mappage des exceptions communes à tous les fournisseurs vers les types d’exception OpenAI pour une gestion standardisée des erreurs.

En outre, le paquet comprend une fonction de mappage d’exception. Elle aligne les exceptions standard des différents fournisseurs sur les types d’exception de l’OpenAI, garantissant ainsi la cohérence de la gestion des erreurs.

LLM-App

Lancez-vous dans la création de votre propre chatbot Discord AI, enrichi de la capacité de répondre aux questions, ou plongez dans l’exploration d’idées similaires de bot AI. Toutes ces fonctionnalités captivantes convergent vers l’application LLM-App.

Je vous présente Pathways LLM-App – une bibliothèque Python méticuleusement conçue pour accélérer le développement d’applications d’IA révolutionnaires.

Caractéristiques principales :

- Conçue pour les modèles ML locaux: LLM App est configurée pour fonctionner avec des modèles ML sur site, en restant dans les limites de l’organisation.

- Traitement des données en temps réel: Cette bibliothèque gère habilement les sources de données en direct, y compris les flux de nouvelles, les API et les flux de données Kafka, avec des autorisations d’utilisateur et une sécurité solide.

- Sessions utilisateur fluides: Le processus de construction de requêtes de la bibliothèque gère efficacement les sessions des utilisateurs, garantissant des interactions transparentes.

Cet atout exceptionnel vous permet de fournir des réponses instantanées qui reflètent les interactions humaines lors des requêtes des utilisateurs. Il accomplit cet exploit remarquable en s’appuyant efficacement sur les dernières informations dissimulées dans vos sources de données.

LLMFlows

LLMFlows est un cadre conçu pour simplifier, clarifier et apporter de la transparence au développement d’applications LLM (Large Language Model) telles que les chatbots, les systèmes de réponse aux questions et les agents.

La complexité peut être amplifiée dans les scénarios du monde réel en raison des relations complexes entre les invites et les appels LLM.

Les créateurs de LLMFlows ont imaginé une API explicite qui permet aux utilisateurs de créer un code propre et compréhensible. Cette API rationalise la création d’interactions LLM complexes, en garantissant un flux transparent entre différents modèles.

Caractéristiques principales :

- Configurez les classes LLM en toute transparence, en sélectionnant méticuleusement des modèles, des paramètres et des réglages spécifiques.

- Garantissez des interactions LLM robustes avec des tentatives automatiques en cas d’échec de l’appel au modèle, ce qui garantit la fiabilité.

- Optimisez les performances et l’efficacité en utilisant les flux asynchrones pour l’exécution parallèle des LLM lorsque les entrées sont disponibles.

- Intégrez des fonctions personnalisées de manipulation de chaînes de caractères directement dans les flux, facilitant ainsi les transformations de texte personnalisées au-delà des appels LLM.

- Maintenez un contrôle et une surveillance complets sur les applications alimentées par LLM avec des rappels, offrant une surveillance et une visibilité complètes sur les processus d’exécution.

Les classes de LLMFlows offrent aux utilisateurs une autorité débridée sans invites cachées ni appels LLM.

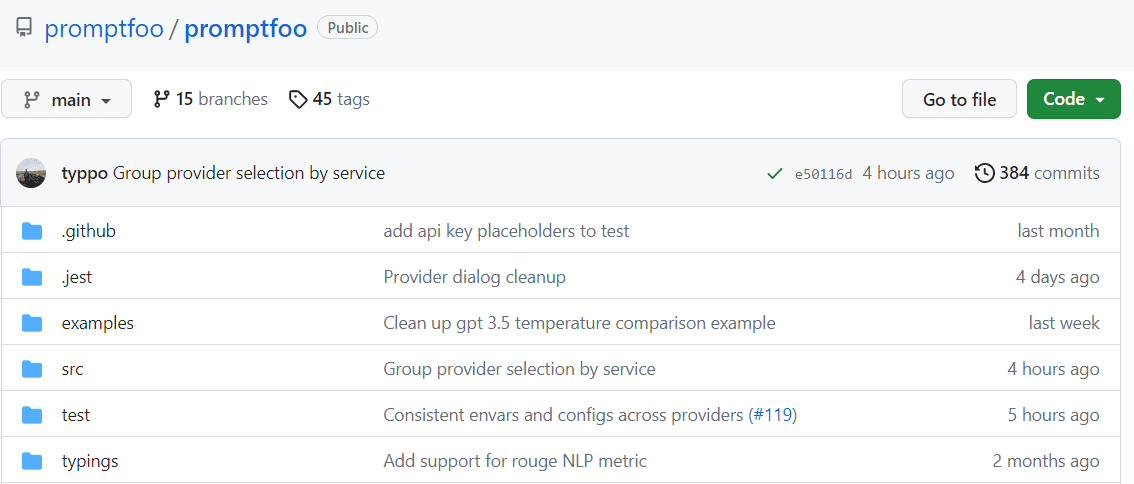

Promptfoo

Accélérez les évaluations grâce à la mise en cache et aux tests simultanés en utilisant promptfoo. Il fournit une interface de ligne de commande (CLI) et une bibliothèque, permettant l’évaluation de la qualité des sorties LLM.

Caractéristiques principales :

- Fiabilité éprouvée : Promptfoo a été méticuleusement conçu pour évaluer et améliorer les applications LLM qui s’adressent à plus de 10 millions d’utilisateurs dans un environnement de production. L’outil fourni est flexible et adaptable à différentes configurations.

- Cases de test conviviales : Définissez des évaluations sans avoir à coder ou à vous débattre avec des carnets de notes encombrants. Une approche simple et déclarative rationalise le processus.

- Flexibilité des langages : Que vous utilisiez Python, Javascript ou tout autre langage, promptfoo s’adapte à vos préférences.

De plus, promptfoo permet de tester systématiquement les messages-guides par rapport à des cas de test prédéfinis. Cela permet d’évaluer la qualité et d’identifier les régressions en facilitant la comparaison directe côte à côte des sorties LLM.

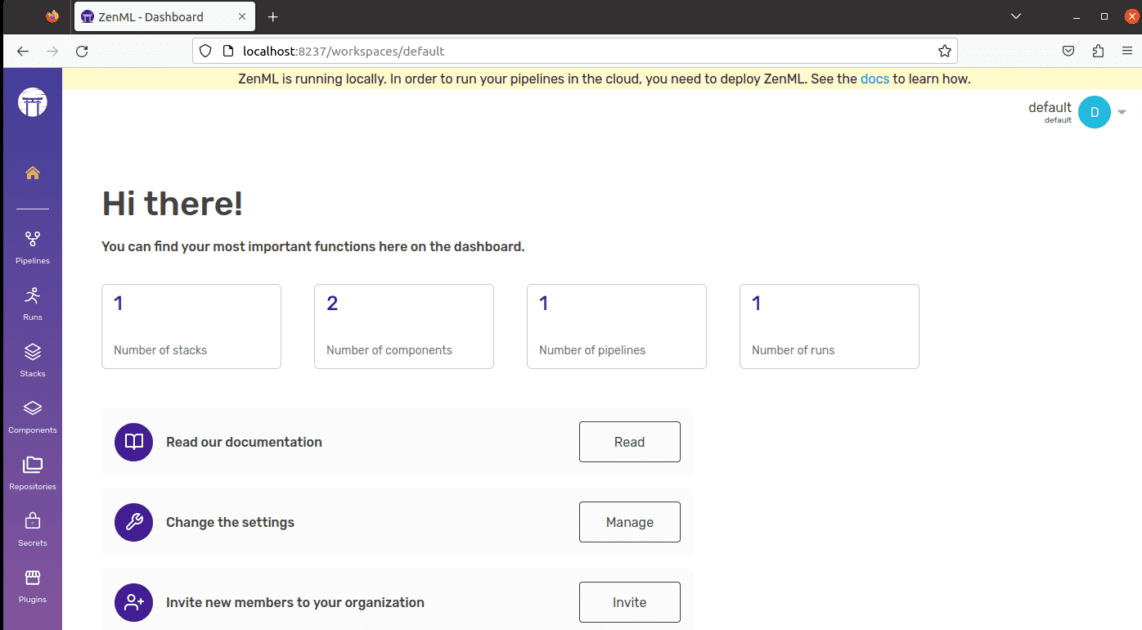

ZenML

Dites bonjour à ZenML – un outil adaptable et open-source conçu pour faciliter le monde des pipelines d’apprentissage automatique pour les professionnels et les organisations. Imaginez un outil qui vous permette de créer des pipelines d’apprentissage automatique prêts à être utilisés dans le monde réel, quelle que soit la complexité de votre projet.

ZenML sépare les aspects techniques du code, ce qui facilite la collaboration entre les développeurs, les data scientists, les experts MLOps et les ingénieurs ML. Cela signifie que vos projets peuvent passer plus facilement du stade de l’idée à celui de l’action.

Caractéristiques principales :

- Pour les Data Scientists: Concentrez-vous sur la création et le test de modèles pendant que ZenML prépare votre code à une utilisation réelle.

- Pour les experts en infrastructure MLOps: Configurez, gérez et déployez rapidement des systèmes complexes pour que vos collègues puissent les utiliser sans problème.

- Pour les ingénieurs ML: Gérez chaque étape de votre projet d’apprentissage automatique, du début à la fin, avec l’aide de ZenML. Cela signifie moins de travail de transfert et plus de clarté dans le parcours de votre organisation.

ZenML est fait pour tout le monde – que vous soyez un professionnel ou que vous fassiez partie d’une organisation. Il s’accompagne d’une méthode d’écriture de code conçue pour les tâches d’apprentissage automatique, et il fonctionne bien avec n’importe quel service ou outil en nuage que vous utilisez. De plus, il vous aide à gérer votre projet en un seul endroit, de sorte que vous n’avez pas à vous soucier de jongler avec différentes choses. Il vous suffit d’écrire votre code une seule fois et de l’utiliser facilement sur d’autres systèmes.

Dernière réflexion

Dans cette odyssée exaltante, gardez toujours à l’esprit que chaque plateforme présente une clé distincte capable de déverrouiller vos aspirations en matière d’IA. Votre sélection a le pouvoir de façonner votre chemin, alors choisissez judicieusement !

Vous pouvez également explorer certains outils d’IA pour les développeurs afin de créer des applications plus rapidement.