Scrapez ce qui compte pour votre entreprise sur Internet grâce à ces puissants outils de web scraping basés sur le cloud.

Les solutions de web scraping basées sur le cloud sont devenues un outil essentiel pour les entreprises et les particuliers qui cherchent à extraire des données précieuses et pertinentes d’Internet.

Jetons maintenant un coup d’œil sur les outils que nous allons présenter dans cette liste. Cette liste est basée sur des heures de recherche et devrait faciliter votre travail de web scraping.

Cet article explore les solutions populaires de web scraping basées sur le cloud qui offrent des capacités de scraping efficaces et fiables.

Boostez vos efforts d’extraction de données dès aujourd’hui !

Maintenant, plongeons dans la liste et découvrons pourquoi le web scraping est plus facile que jamais, grâce à ces outils étonnants !

Scrapestack

Scrapez tout ce que vous voulez sur Internet avec Scrapestack.

Avec plus de 35 millions d’adresses IP, vous n’aurez jamais à vous soucier du blocage des requêtes lors de l’extraction de pages web. Lorsque vous faites un appel REST-API, les requêtes sont envoyées à travers plus de 100 sites mondiaux (en fonction du plan) grâce à une infrastructure fiable et évolutive.

Vous pouvez démarrer GRATUITEMENT pour ~10.000 requêtes avec un support limité. Une fois que vous êtes satisfait, vous pouvez opter pour un plan payant. Scrapestack est prêt pour l’entreprise, et certaines de ses fonctionnalités sont décrites ci-dessous.

- Rendu JavaScript

- Cryptage HTTPS

- Proxies premium

- Requêtes simultanées

- Pas de CAPTCHA

Avec l’aide de leur bonne documentation API, vous pouvez démarrer en cinq minutes avec des exemples de code pour PHP, Python, Nodejs, jQuery, Go, Ruby, etc.

Bright Data

Bright Data vous propose la première plateforme de données Web au monde. Elle vous permet de récupérer les données web publiques qui vous intéressent. Elle propose deux solutions de Web Scraping basées sur le cloud :

Bright Data Web Unlocker

Bright Data Web Unlocker est un outil automatisé de déverrouillage de sites web qui permet d’atteindre des sites web ciblés avec des taux de réussite imprévisibles. Il vous fournit les données Web les plus précises disponibles avec une puissante technologie de déverrouillage sur simple demande.

Web Unlocker gère les empreintes digitales des navigateurs, est compatible avec les codes existants, offre une option de sélection automatique des adresses IP et permet la gestion des cookies et l’amorçage des adresses IP. Vous pouvez également valider automatiquement l’intégrité du contenu en fonction des types de données, du contenu de la réponse, du moment de la demande, etc.

Son prix est de 300 dollars par mois. Vous pouvez également opter pour un plan de paiement à l’utilisation à 5 dollars par minute.

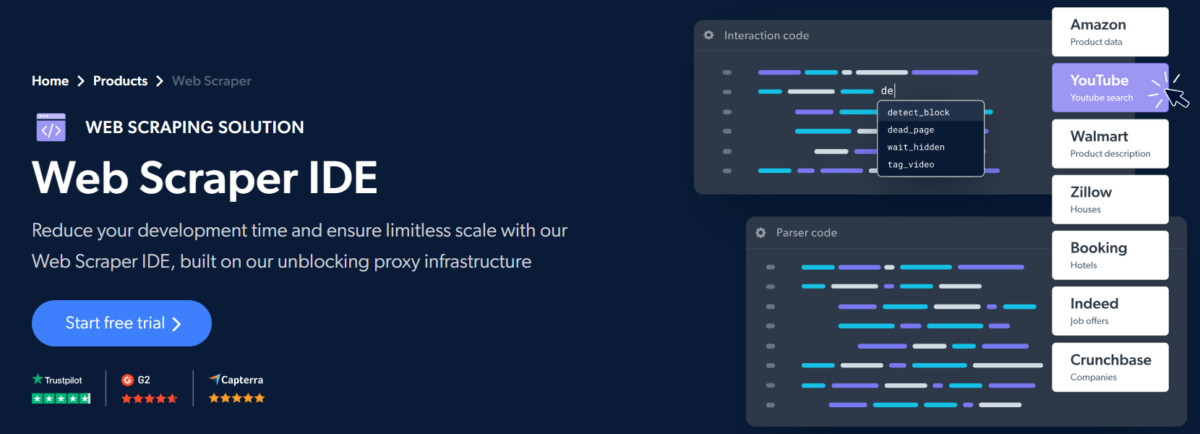

Bright Data Web Scraper IDE

L’IDE Web Scraper de Bright Data est un outil hébergé dans le nuage qui aide les développeurs à coder rapidement des scrapeurs basés sur JavaScript. Il dispose de fonctions et de modèles de code prédéfinis pour extraire des données des principaux sites web sans effort, ce qui permet de réduire de 75 % le temps de développement et d’offrir une grande évolutivité.

La console indique un aperçu interactif en temps réel pour déboguer les erreurs immédiatement. De plus, les outils de débogage natifs permettent d’analyser les recherches précédentes afin d’optimiser les recherches à venir.

Web Scraper IDE offre un contrôle de premier ordre sans le souci de maintenir une infrastructure de déblocage et des proxys. Grâce à sa technologie de déblocage intégrée, il vous permet d’obtenir des données web à partir de n’importe quel endroit, y compris à partir de ressources protégées par CAPTCHA.

Vous pouvez planifier des recherches, connecter leur API aux principaux systèmes de stockage en nuage (Amazon S3, Microsoft Azure, etc.) ou intégrer des crochets Web pour obtenir les données à l’endroit de votre choix. Le plus grand avantage est que Web Scraper IDE fonctionne tout en étant conforme aux politiques globales de protection des données.

Il propose un essai gratuit, des forfaits mensuels et des plans de paiement à l’utilisation, offrant ainsi une excellente flexibilité pour la plupart des cas d’utilisation.

Oxylabs

L’API de web scraping d’Oxylabs est l’un des outils les plus faciles à utiliser pour extraire des données de sites web simples ou complexes, y compris de sites de commerce électronique.

La récupération des données est rapide et précise grâce à son rotateur de proxy intégré unique et au rendu JavaScript, et vous ne payez que pour les résultats qui sont livrés avec succès.

Où que vous soyez, l’API Web Scraper vous permet d’accéder à des données provenant de 195 pays différents.

L’exploitation d’un scraper nécessite le maintien d’une infrastructure qui requiert une maintenance périodique ; Oxylabs offre une infrastructure sans maintenance, de sorte que vous n’avez plus à vous soucier des interdictions d’IP ou d’autres problèmes.

Vos efforts de scraping seront plus souvent couronnés de succès puisqu’Oxylabs peut automatiquement réessayer les tentatives de scraping qui ont échoué.

Voici une liste des fonctionnalités qu’Oxylabs offre à ses utilisateurs. Bien sûr, il ne s’agit que de quelques-unes parmi d’autres !

- Immense pool de proxy de 102M.

- Grattage en masse jusqu’à 1000 URLs.

- Automatisation des activités de scraping de routine.

- Possibilité de récupérer les résultats du scraping sur AWS S3 ou GCS

Oxylabs scraping est gratuit à l’essai pendant une semaine, et les plans de démarrage commencent à 99 $ par mois.

API Abstract

Abstract est une puissance en matière d’API, et vous ne resterez pas insensible après avoir utilisé son API de scraping Web. Ce produit conçu pour les développeurs est rapide et hautement personnalisable.

Vous pouvez choisir parmi 100 serveurs mondiaux pour effectuer les requêtes de l’API de scraping sans vous soucier des temps d’arrêt.

En outre, ses millions d’IP et de proxies en rotation constante garantissent une extraction de données fluide à grande échelle. Et vous pouvez être assuré que vos données sont en sécurité grâce au cryptage SSL 256 bits.

Enfin, vous pouvez essayer Abstract Web Scraping API gratuitement avec un plan de 1000 demandes d’API et passer à des abonnements payants en fonction de vos besoins.

ParseHub

ParseHub vous aide à développer des scrapeurs web pour explorer des sites web uniques et variés avec l’assistance de JavaScript, AJAX, cookies, sessions et commutateurs à l’aide de leur application de bureau et à les déployer sur leur service cloud. Parsehub propose une version gratuite qui vous permet d’obtenir 200 pages de statistiques en 40 minutes, cinq projets communautaires et un support limité.

Octoparse

Vous allez adorer les services d’Octoparse. Ce service fournit une plateforme basée sur le cloud pour que les utilisateurs puissent conduire leurs tâches d’extraction construites avec l’application Octoparse Desktop App.

Jetons un coup d’œil à quelques-unes des caractéristiques d’Octoparse.

- Outil de type “pointer et cliquer”, transparent à configurer et à utiliser

- Prend en charge les sites web à forte composante Javascript

- Il peut exécuter jusqu’à 10 scrapers sur l’ordinateur local si vous n’avez pas besoin d’une grande évolutivité

- Inclut la rotation automatique des IP dans chaque plan

Pour essayer Octoparse, vous pouvez commencer leur essai gratuit, et si vous aimez ses caractéristiques, le plan standard commence à 75 $ par mois.

Zyte

Zyte dispose d’un outil d’extraction automatisé alimenté par l’IA qui vous permet d’obtenir les données dans un format structuré en quelques secondes. Il prend en charge 40 langues et récupère des données du monde entier. Il dispose d’un mécanisme de rotation automatique des adresses IP intégré afin que votre adresse IP ne soit pas bannie.

Zyte dispose d’une API HTTP avec la possibilité d’accéder à plusieurs types de données. Il vous permet également de livrer directement les données sur votre compte Amazon S3.

ScraperAPI

Vous bénéficiez de 1000 appels API gratuits avec ScraperAPI, qui peut gérer les proxies, les navigateurs et les CAPTCHA comme un pro. Il gère plus de 5 milliards de requêtes API chaque mois pour plus de 1 500 entreprises, et je pense que l’une des nombreuses raisons de ce succès est que leur scraper ne se bloque jamais lorsqu’il collecte des données sur le web. Il utilise des millions de proxys pour faire tourner les adresses IP et récupère même les requêtes qui ont échoué.

Lisez aussi: Les meilleurs services/API de résolution de Captcha pour le Web Scraping et l’automatisation

Il est facile à démarrer, rapide et, fait intéressant, très personnalisable. Vous pouvez rendre Javascript pour personnaliser les en-têtes de requête, le type de requête, la géolocalisation IP, et plus encore. Il y a également une garantie de temps de fonctionnement de 99,9 % et vous bénéficiez d’une bande passante illimitée.

Bénéficiez de 10% de réduction avec le code promo – GF10

ScrapingBee

ScrapingBee est un autre service étonnant qui fait tourner les proxies pour vous et peut gérer les navigateurs sans tête tout en ne se faisant pas bloquer. Il est très personnalisable à l’aide de snippets JavaScript et, globalement, peut être utilisé à des fins de référencement, de growth hacking ou simplement de scraping général.

Lisez aussi: Débuter avec le Web Scraping en JavaScript

Il est utilisé par certaines des entreprises les plus importantes, telles que WooCommerce, Zapier et Kayak. Vous pouvez commencer gratuitement avant de passer à un plan payant, à partir de 29 $/mois.

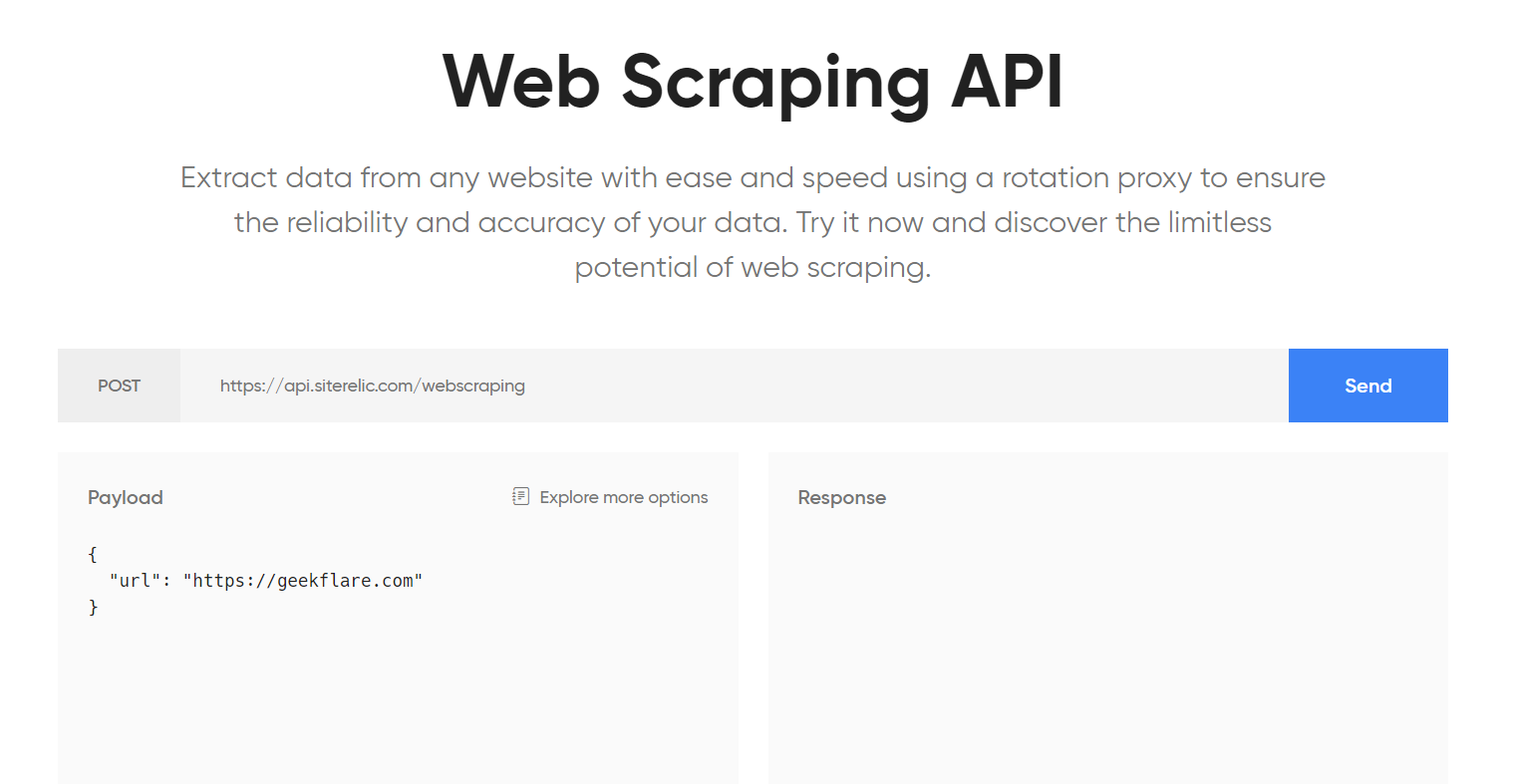

Siterelic

Soutenue par AWS, l’API de scraping Web de Siterelic est aussi fiable qu’elle peut l’être. Elle vous permet d’extraire des données à partir d’un ordinateur de bureau, d’un téléphone portable ou d’une tablette et prend en charge le rendu JavaScript.

Cette API se targue d’un temps de disponibilité élevé et de proxies rotatifs pour éviter d’être bloquée.

En outre, il est extrêmement rapide de démarrer grâce à la documentation disponible sur l’API, qui comprend des illustrations pour cURL, Node.js, Python, Ruby et PHP.

Vous pouvez commencer par le plan gratuit avec 500 requêtes par mois. L’abonnement premium commence à 10 $ par mois pour 10 000 requêtes et ajoute des avantages tels qu’une limite de requêtes par seconde plus élevée et des proxies rotatifs.

Apify

Apify dispose d’un grand nombre de modules appelés acteurs pour traiter les données, transformer les pages web en API, transformer les données, explorer les sites, exécuter Headless Chrome, etc. Il s’agit de la plus grande source d’information jamais créée par l’humanité.

Certains des acteurs prêts à l’emploi peuvent vous aider à démarrer rapidement pour effectuer les opérations suivantes.

- Convertir une page HTML en PDF

- Explorer et extraire des données de pages web

- Scraping Google search, Google Places, Amazon, Booking, Twitter hashtag, Airbnb, Hacker News, etc

- Vérification du contenu des pages web (surveillance des dégradations)

- Analyse du référencement des pages

- Vérifier les liens brisés

et bien d’autres choses encore pour développer les produits et services de votre entreprise.

Web Scraper

Web Scraper, un outil indispensable, est une plateforme en ligne sur laquelle vous pouvez déployer des scraps construits et analysés à l’aide d’une extension chrome gratuite. Grâce à cette extension, vous créez des “sitemaps” qui déterminent la manière dont les données doivent être traitées et extraites. Vous pouvez écrire rapidement les données dans CouchDB ou les télécharger sous forme de fichier CSV.

Voici un aperçu des fonctionnalités offertes par Web Scraper :

- Vous pouvez commencer immédiatement car l’outil est aussi simple que possible et comporte d’excellentes vidéos tutorielles.

- Prend en charge les sites Web à fort contenu javascript

- Son extension est open source, vous ne serez donc pas prisonnier du vendeur si le bureau ferme

- Prend en charge les proxys externes ou la rotation d’IP

Il garantit une extraction automatisée des données en 20 minutes, que vous l’utilisiez à des fins régulières ou professionnelles.

Mozenda

Mozenda est spécialement conçu pour les entreprises qui recherchent une plateforme de grattage de pages web en libre-service basée sur le cloud. Vous serez surpris d’apprendre qu’avec plus de 7 milliards de pages scrappées, Mozenda a le sentiment de servir des clients professionnels de toute la province.

Mozenda possède de nombreuses fonctionnalités, qui ne sont pas limitées à :

- Modélisation pour construire le flux de travail plus rapidement

- Créer des séquences de travail pour automatiser le flux

- Récupérer des données spécifiques à une région

- Bloquer les demandes de domaines indésirables

Vous pouvez essayer Mozenda gratuitement pendant les 30 premiers jours. Pour connaître les tarifs, vous devrez toutefois contacter leurs représentants.

Diffbot

Diffbot vous permet de configurer des robots d’exploration capables de travailler et d’indexer des sites web, puis de les traiter à l’aide de ses API automatiques pour l’extraction de certaines données à partir de différents contenus web. Vous pouvez également créer un extracteur personnalisé si une API d’extraction de données spécifique ne fonctionne pas pour les sites dont vous avez besoin.

Le graphe de connaissances de Diffbot vous permet d’interroger le web pour obtenir des données riches.

Maintenant que nous avons parlé des meilleurs outils de web scraping, voyons ce qu’est le web scraping, comment fonctionnent les outils de web scraping et pourquoi ils sont extrêmement pratiques aujourd’hui.

Qu’est-ce que le “Web Scraping” ?

Le terme “web scraping” fait référence à différentes méthodes de collecte d’informations et de données essentielles sur Internet. On parle également d’extraction de données sur le web, de grattage d’écran ou de récolte de données sur le web.

Il y a plusieurs façons de procéder.

- Manuellement – vous accédez au site web et vérifiez ce dont vous avez besoin.

- Automatique – vous utilisez les outils nécessaires pour configurer ce dont vous avez besoin et vous laissez les outils travailler pour vous.

Si vous optez pour la méthode automatique, vous pouvez soit installer vous-même le logiciel nécessaire, soit tirer parti d’une solution basée sur l’informatique dématérialisée.

Si vous souhaitez configurer le système vous-même, jetez un coup d’œil aux meilleurs frameworks de web scraping.

Pourquoi le Web Scraping basé sur le Cloud ?

En tant que développeur, vous savez sans doute que le web scraping, le HTML scraping, le web crawling et toute autre extraction de données web peuvent être très compliqués. Pour obtenir la source correcte de la page, déterminer la source avec précision, rendre le JavaScript et rassembler les données sous une forme utilisable, il y a beaucoup de travail à effectuer.

Vous devez connaître le logiciel, passer des heures à le configurer pour obtenir les données souhaitées, l’héberger vous-même, vous inquiéter d’être bloqué (vous n’aurez rien à craindre si vous consultez notre liste des meilleurs proxy de rotation d’IP), etc. Au lieu de cela, vous pouvez utiliser une solution basée sur le cloud pour décharger le fournisseur de tous les maux de tête, et vous pouvez vous concentrer sur l’extraction de données pour votre entreprise.

Ainsi, le web scraping basé sur le cloud vous permet de gagner du temps et de protéger votre vie privée. Si vous avez besoin d’autres raisons d’être convaincu, voyons comment il peut aider votre entreprise en pleine croissance.

Comment cela aide-t-il les entreprises ?

- Vous pouvez obtenir des flux de produits, des images, des prix et d’autres détails relatifs au produit à partir de différents sites et créer votre entrepôt de données ou votre site de comparaison de prix.

- Vous pouvez examiner le fonctionnement d’un produit particulier, le comportement des utilisateurs et les retours d’information dont vous avez besoin.

- À l’ère de la numérisation, les entreprises sont très soucieuses des dépenses liées à la gestion de leur réputation en ligne. C’est pourquoi le web scraping est également nécessaire dans ce domaine.

- Il est devenu courant pour les individus de lire des opinions et des articles en ligne à des fins diverses. Il est donc essentiel d’éliminer l’impression de spamming.

- En récupérant les résultats des recherches organiques, vous pouvez instantanément découvrir vos concurrents en matière de référencement pour un terme de recherche spécifique. Vous pouvez déterminer les balises de titre et les mots-clés que les autres planifient.

Lisez aussi: Best Google SERP API to Scrape Real-time Search Results ( Meilleure API Google SERP pour récupérer les résultats de recherche en temps réel)

Avec de tels avantages, il est prudent d’utiliser ces outils de web scraping basés sur le cloud pour l’analyse de la concurrence, la gestion de la réputation de votre entreprise et des solutions détaillées à tous les problèmes qui pourraient survenir.

Conclusion

Il est remarquable de savoir qu’il n’y a pratiquement aucune donnée que vous ne pouvez pas obtenir en extrayant des données web à l’aide de ces outils de web scraping.