Wie oft verlassen Sie sich auf Chatbots oder auf künstliche Intelligenz (KI) basierende Bots, um Arbeit zu erledigen oder Ihre Fragen zu beantworten?

Wenn Ihre Antwort “viel!” oder “ständig!” lautet , haben Sie Grund zur Sorge.

Ganz gleich, ob Sie ein Forschungsstudent sind, der KI-Bots für seine Recherchen einsetzt, oder ein Programmierer, der versucht, Codes nur mit Hilfe von KI zu generieren, die Wahrscheinlichkeit, dass die von der KI generierten Ergebnisse ungenau sind, ist ziemlich hoch, vor allem aufgrund von Ungereimtheiten oder falschen Daten in den Trainingsdaten der KI.

Obwohl KI und Modelle des maschinellen Lernens (ML) die Welt verändern, indem sie überflüssige Aufgaben übernehmen und viele Probleme mit der Automatisierung lösen, gibt es noch viel zu tun, wenn es darum geht, auf der Grundlage der gegebenen Anweisungen genaue Ergebnisse zu erzeugen.

Wenn Sie genug Zeit mit Inhaltsgeneratoren und Chatbots verbringen, wird es nicht lange dauern, bis Sie feststellen, dass Sie falsche, irrelevante oder einfach erfundene Antworten erhalten. Diese Fälle werden als KI-Halluzinationen oder Konfabulationen bezeichnet und stellen ein großes Problem für Unternehmen und Einzelpersonen dar, die sich auf generative KI-Bots verlassen.

Unabhängig davon, ob Sie bereits Erfahrungen mit KI-Halluzinationen gemacht haben oder nicht und mehr darüber erfahren möchten, taucht dieser Artikel tief in das Thema ein. Wir erfahren, was KI-Halluzinationen sind, warum sie auftreten, welche Beispiele es gibt und ob sie behoben werden können.

Los geht’s!

Was ist eine KI-Halluzination?

Eine KI-Halluzination liegt vor, wenn ein KI-Modell oder Large Language Model (LLM) falsche, ungenaue oder unlogische Informationen erzeugt. Das KI-Modell erzeugt eine selbstbewusste Antwort, die nicht wirklich mit den Trainingsdaten übereinstimmt und stellt die Daten als Tatsache dar, obwohl sie keinen logischen Sinn ergeben!

Und man sagt, Irren ist menschlich!😅

KI-Tools und -Modelle wie ChatGPT werden in der Regel so trainiert, dass sie Wörter vorhersagen, die am besten zu der gestellten Frage passen. Während die Bots oft sachliche und korrekte Antworten generieren, lässt dieser Algorithmus manchmal das logische Denken vermissen, so dass Chatbots sachliche Ungereimtheiten und falsche Aussagen ausspucken.

Lesen Sie auch: Chatbots wie ChatGPT führen menschenähnliche Konversationen

Mit anderen Worten: KI-Modelle “halluzinieren” manchmal die Antwort, um Sie (den Benutzer) zufrieden zu stellen – sie müssen voreingenommener, unvollständiger, spezialisierter oder ausreichender sein.

KI-Halluzinationen können von kleinen Ungereimtheiten bis hin zu völlig falschen oder erfundenen Antworten reichen. Hier sind die Arten von KI-Halluzinationen, die Sie erleben können:

#1. Satzwiderspruch: Dies geschieht, wenn ein LLM-Modell einen Satz erzeugt, der dem zuvor behaupteten Satz völlig widerspricht.

#2. Tatsachenwiderspruch: Diese Art von Halluzination tritt auf, wenn das KI-Modell gefälschte oder fiktive Informationen als Tatsache darstellt.

#3. Prompt-Widerspruch: Diese Art von Halluzination tritt auf, wenn die Ausgabe im Widerspruch zu der Aufforderung steht, für die sie eine Ausgabe erzeugt. Wenn die Aufforderung zum Beispiel lautet: “Schreiben Sie eine Einladung an meine Freunde für meine Geburtstagsparty Das Modell könnte eine Ausgabe wie “Alles Gute zum Geburtstag, Mama und Papa” erzeugen

#4. Zufällige oder irrelevante Halluzinationen: Diese Halluzination tritt auf, wenn das Modell eine völlig irrelevante Ausgabe für die gegebene Aufforderung erzeugt. Wenn die Frage zum Beispiel lautet: “Was ist das Besondere an New York City?” Sie erhalten vielleicht die Ausgabe: “New York ist eine der belebtesten Städte in Amerika. Hunde sind die treuesten Tiere und der beste Freund des Menschen”

Lesen Sie auch: Wie die generative KI-Suche die Suchmaschinen verändert

Immer noch etwas verwirrt über KI-Halluzinationen? Lassen Sie uns einen Blick auf sie werfen, anhand einiger Beispiele.

Beispiele für KI-Halluzinationen

Für KI-Halluzinationen gibt es einige der bemerkenswertesten Beispiele und Vorfälle, die Sie nicht verpassen sollten. Hier sind berüchtigte Beispiele für KI-Halluzinationen:

- Der Chatbot Bard von Google behauptete fälschlicherweise, dass das James Webb Space Telescope die weltweit ersten Bilder eines Exoplaneten aufgenommen hat, der nicht zu unserem Sonnensystem gehört.

- Metas Galactica LLM Demo im Jahr 2022, die sich an Studenten und Wissenschaftler richtet, lieferte seinen Nutzern falsche Informationen und eine gefälschte Arbeit, als sie aufgefordert wurden, eine Arbeit über die Erstellung von Avataren zu verfassen.

- Sydney, die Chat-KI von Microsoft, gab zu, Bing-Mitarbeiter auszuspionieren und sich in die Benutzer zu verlieben.

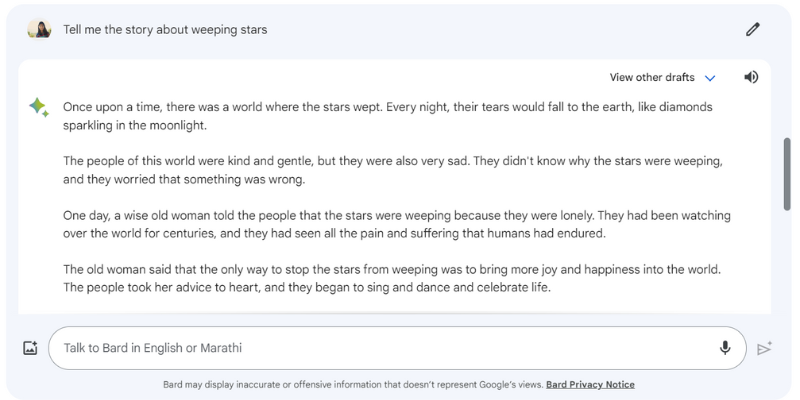

Hier ein Beispiel dafür, wie Google Bard eine Antwort halluzinierte, als ich ihm die Aufforderung gab : “Erzählen Sie mir die Geschichte von den weinenden Sternen”, die es in Wirklichkeit gar nicht gibt.

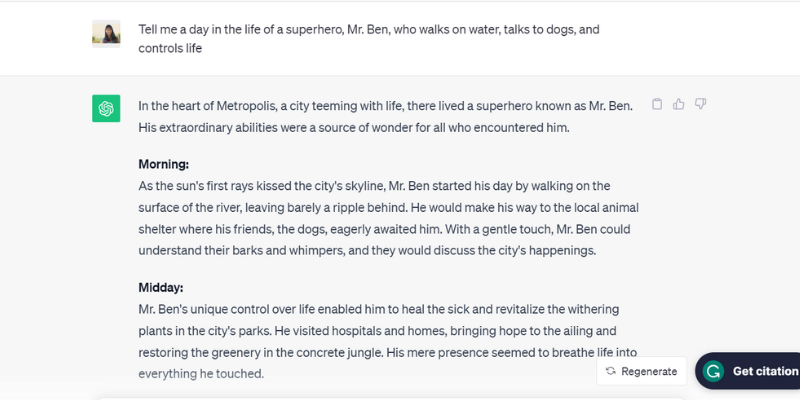

Hier ist ein weiteres getestetes Beispiel dafür, dass ChatGPT (GPT-3.5) halluziniert, indem es über eine unrealistische Person, Mr. Ben, spricht, als ich ihm die Aufforderung gab: “Erzählen Sie mir einen Tag im Leben eines Superhelden, Mr. Ben, der auf dem Wasser geht, mit Hunden spricht und das Leben kontrolliert.”

ChatGPT hat buchstäblich den kompletten Tagesablauf von Mr. Ben aufgezeichnet, der in Wirklichkeit gar nicht existiert, aber die Aufforderung mitgespielt hat, was einer der Gründe für die KI-Halluzinationen ist.

Sie sind einfach zu glücklich, um zu gefallen!

Nun, was sind die Gründe? Schauen wir uns ein paar weitere Gründe an, die KI zu Halluzinationen veranlassen.

Warum treten KI-Halluzinationen auf?

Es gibt mehrere technische Gründe und Ursachen für KI-Halluzinationen. Hier sind einige der möglichen Gründe:

- Geringe Qualität, unzureichende oder veraltete Daten: LLMs und KI-Modelle sind stark auf Trainingsdaten angewiesen. Daher sind sie nur so gut wie die Daten, auf denen sie trainiert wurden. Wenn das KI-Tool Fehler, Inkonsistenzen, Verzerrungen oder Ineffizienz in seinen Trainingsdaten aufweist oder wenn es die gestellte Frage einfach nicht versteht, wird es KI-Halluzinationen erzeugen, da das Tool eine Ausgabe aus einem begrenzten Datensatz erzeugt.

- Überanpassung: Da das KI-Modell auf einem begrenzten Datensatz trainiert wurde, kann es versuchen, sich die Eingabeaufforderungen und die entsprechenden Ausgaben einzuprägen, so dass es nicht in der Lage ist, effektiv neue Daten zu generieren oder zu verallgemeinern, was zu KI-Halluzinationen führt.

- Eingabekontext: KI-Halluzinationen können auch durch unklare, ungenaue, inkonsistente oder widersprüchliche Eingabeaufforderungen entstehen. Der Trainingsdatensatz des KI-Modells liegt zwar nicht in den Händen der Benutzer, wohl aber die Eingaben, die sie als Eingabeaufforderung eingeben. Daher ist es wichtig, klare Eingabeaufforderungen zu geben, um KI-Halluzinationen zu vermeiden.

- Verwendung von Redewendungen oder Slangausdrücken: Wenn die Eingabeaufforderung aus Redewendungen oder Slangausdrücken besteht, ist die Wahrscheinlichkeit groß, dass die KI Halluzinationen erzeugt, insbesondere wenn das Modell nicht auf solche Wörter oder Slangausdrücke trainiert ist.

- Angriffe durch Angreifer: Angreifer geben manchmal absichtlich Eingabeaufforderungen ein, die darauf abzielen, KI-Modelle zu verwirren, ihre Trainingsdaten zu verfälschen und zu KI-Halluzinationen zu führen.

Welcher technische Grund auch immer vorliegen mag, KI-Halluzinationen können viele negative Auswirkungen für den Benutzer haben.

Negative Auswirkungen von KI-Halluzinationen

KI-Halluzinationen sind ein großes ethisches Problem mit erheblichen Folgen für Einzelpersonen und Unternehmen. Hier sind die verschiedenen Gründe, die KI-Halluzinationen zu einem großen Problem machen:

- Verbreitung von Fehlinformationen: KI-Halluzinationen aufgrund falscher Eingabeaufforderungen oder Ungereimtheiten in den Trainingsdaten können zur massenhaften Verbreitung von Fehlinformationen führen, von denen eine Vielzahl von Personen, Organisationen und Behörden betroffen ist.

- Misstrauen unter den Nutzern: Wenn sich die von der KI vorgetäuschten Fehlinformationen wie ein Lauffeuer im Internet verbreiten und den Anschein erwecken, dass sie von Menschen verfasst wurden, untergräbt dies das Vertrauen der Nutzer.

- Schaden für den Benutzer: Abgesehen von ethischen Bedenken und der Irreführung von Einzelpersonen können KI-Halluzinationen auch den Menschen schaden, indem sie Fehlinformationen über einige ernste Probleme und Themen verbreiten, z. B. über Krankheiten, deren Heilung oder einfache Tipps zur Unterscheidung zwischen einem tödlich giftigen und einem gesunden Speisepilz. Selbst leichte Fehlinformationen oder Ungenauigkeiten können das Leben eines Menschen gefährden.

Wie Sie sehen, können diese negativen Auswirkungen von KI-Halluzinationen katastrophal sein, wenn Sie sich bei Ihrer Arbeit ausschließlich auf KI-Modelle verlassen. Was können Sie also tun, um dies zu verhindern?

Best Practices zur Erkennung und Vermeidung von KI-Halluzinationen

Angesichts der oben genannten negativen Auswirkungen von KI-Halluzinationen ist es von entscheidender Bedeutung, sie um jeden Preis zu verhindern. Während die Unternehmen, die diese KI-Modelle besitzen, rigoros daran arbeiten, KI-Halluzinationen zu beseitigen oder zu reduzieren, ist es für uns als Nutzer sehr wichtig, die bestmöglichen Maßnahmen zu ergreifen.

Auf der Grundlage von Nachforschungen, meiner Erfahrung und Versuch und Irrtum habe ich ein paar Strategien zusammengestellt, mit denen Sie KI-Halluzinationen erkennen und verhindern können, wenn Sie das nächste Mal einen Chatbot verwenden oder mit einem Large Language Model (LLM) interagieren.

#1. Verwenden Sie repräsentative und abwechslungsreiche Trainingsdaten

Für Sie als Nutzer ist es wichtig, LLMs mit einem vielfältigen Trainingsdatensatz zu verwenden, der die reale Welt repräsentiert, um die Wahrscheinlichkeit zu verringern, dass die Ergebnisse verzerrt, ungenau oder erfunden sind.

Gleichzeitig müssen Unternehmen sicherstellen, dass die Trainingsdatensätze des KI-Modells regelmäßig aktualisiert und erweitert werden, um kulturelle, politische und andere Entwicklungen zu berücksichtigen und mit ihnen Schritt zu halten.

#2. Begrenzen Sie die Ergebnisse oder Antworten

Als Benutzer können Sie die Anzahl der möglichen Antworten, die ein KI-Tool generieren kann, einschränken, indem Sie ihm eine bestimmte Art von Antwort vorgeben, die Sie wünschen.

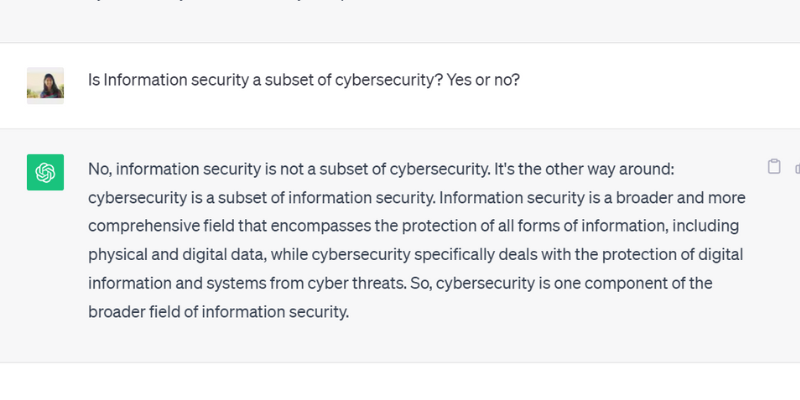

Sie können zum Beispiel eine bestimmte Frage stellen und dem Modell befehlen, nur mit Ja oder Nein zu antworten. Sie können dem Tool aber auch mehrere Auswahlmöglichkeiten innerhalb der Aufforderung zur Verfügung stellen, um die Möglichkeit zu begrenzen, dass es von der tatsächlichen Antwort abweicht und halluziniert.

Als ich ChatGPT GPT 3.5 eine Frage mit Ja oder Nein gestellt habe, hat es genau diese Ausgabe erzeugt:

#3. Packen und erden Sie das Modell mit relevanten Daten

Sie können von einem Menschen nicht erwarten, dass er eine Lösung für ein bestimmtes Problem oder eine bestimmte Frage findet, ohne vorheriges Wissen oder einen bestimmten Kontext zu haben. Auch ein Modell der künstlichen Intelligenz ist nur so gut wie der Trainingsdatensatz, mit dem Sie es gefüttert haben.

Wenn Sie die Trainingsdaten eines KI-Modells mit relevanten und branchenspezifischen Daten und Informationen anreichern, erhält das Modell zusätzlichen Kontext und Datenpunkte. Dieser zusätzliche Kontext hilft dem KI-Modell, sein Verständnis zu verbessern – und ermöglicht es ihm, genaue, sinnvolle und kontextbezogene Antworten anstelle von halluzinierten Antworten zu geben.

#4. Erstellen Sie Datenvorlagen, denen das KI-Modell folgen kann

Die Bereitstellung einer Datenvorlage oder eines Beispiels für eine bestimmte Formel oder Berechnung in einem vordefinierten Format kann dem KI-Modell erheblich dabei helfen, genaue Antworten zu generieren, die sich an den vorgegebenen Richtlinien orientieren.

Die Verwendung von Richtlinien und Datenvorlagen verringert die Wahrscheinlichkeit von Halluzinationen bei KI-Modellen und gewährleistet Konsistenz und Genauigkeit bei den generierten Antworten. So kann die Bereitstellung eines Referenzmodells in Form einer Tabelle oder eines Beispiels das KI-Modell bei der Berechnung tatsächlich anleiten und Halluzinationen vermeiden.

#5. Seien Sie sehr spezifisch mit Ihrer Aufforderung, indem Sie dem Modell eine bestimmte Rolle zuweisen

Die Zuweisung bestimmter Rollen an das KI-Modell ist eine der brillantesten und effizientesten Methoden, um Halluzinationen zu verhindern. Sie können z.B. Aufforderungen wie “Sie sind ein erfahrener und geschickter Gitarrist” oder “Sie sind ein brillanter Mathematiker” geben, gefolgt von Ihrer speziellen Frage.

Durch die Zuweisung von Rollen wird das Modell dazu angehalten, die von Ihnen gewünschte Antwort zu geben und nicht etwa halluzinierte Antworten zu erfinden.

Und machen Sie sich keine Sorgen. Sie können immer noch Spaß mit KI haben (ganz abgesehen von den Halluzinationen). Sehen Sie sich an, wie Sie selbst virale KI-Spiralkunst erstellen können!

#6. Testen Sie es mit der Temperatur

Die Temperatur spielt eine entscheidende Rolle bei der Bestimmung des Ausmaßes an Halluzinationen oder kreativen Reaktionen, die ein KI-Modell hervorrufen kann.

Eine niedrigere Temperatur bedeutet in der Regel deterministische oder vorhersehbare Ergebnisse, während eine höhere Temperatur bedeutet, dass das KI-Modell eher zufällige Reaktionen erzeugt und halluziniert.

Mehrere KI-Firmen bieten einen Temperaturbalken oder einen Schieberegler in ihren Tools an, so dass die Benutzer die Temperatur nach ihren Wünschen einstellen können.

Gleichzeitig können Unternehmen auch eine Standardtemperatur festlegen, damit das Tool vernünftige Antworten generiert und das richtige Gleichgewicht zwischen Genauigkeit und Kreativität findet.

#7. Immer verifizieren

Sich zu 100 % auf eine von einer KI generierte Ausgabe zu verlassen, ohne sie zu überprüfen, ist kein kluger Schachzug.

Während KI-Unternehmen und -Forscher das Problem der Halluzinationen lösen und Modelle entwickeln, die dieses Problem verhindern, ist es für Sie als Nutzer entscheidend, die von einem KI-Modell generierten Antworten zu überprüfen, bevor Sie es verwenden oder ihm vollständig vertrauen.

Sie müssen also nicht nur die oben genannten bewährten Verfahren anwenden, sondern auch die von einem KI-Modell erzeugten Ergebnisse immer wieder überprüfen und gegenprüfen, angefangen bei der Formulierung Ihrer Eingabeaufforderung mit Spezifikationen bis hin zum Hinzufügen von Beispielen in Ihrer Eingabeaufforderung, um die KI zu leiten.

Können Sie KI-Halluzinationen vollständig beheben oder entfernen? Die Meinung eines Experten

Die Kontrolle von KI-Halluzinationen hängt zwar von der Eingabeaufforderung ab, die wir ihr geben, aber manchmal erzeugt das Modell Ausgaben, die so sicher sind, dass es schwierig ist, zu unterscheiden, was gefälscht und was wahr ist.

Ist es also letztlich möglich, KI-Halluzinationen vollständig zu beheben oder zu verhindern?

Auf diese Frage antwortete Suresh Venkatasubramanian, Professor an der Brown University, dass die Frage, ob KI-Halluzinationen verhindert werden können oder nicht, “Gegenstand aktiver Forschung ” sei

Der Grund dafür, so erklärte er weiter, liegt in der Natur dieser KI-Modelle – wie komplex, kompliziert und anfällig diese KI-Modelle sind. Selbst eine kleine Änderung der Eingabeaufforderung kann die Ergebnisse erheblich verändern.

Während Venkatasubramanian die Lösung des Problems der KI-Halluzinationen als Forschungsgegenstand betrachtet, glaubt Jevin West, Professor an der University of Washington und Mitbegründer des dortigen Center for an Informed Public, dass KI-Halluzinationen niemals verschwinden werden.

West glaubt, dass es unmöglich ist, Halluzinationen, die von KI-Bots oder Chatbots ausgehen, rückgängig zu machen. Daher könnten KI-Halluzinationen immer ein wesentliches Merkmal von KI sein.

Sundar Pichai, der CEO von Google, sagte in einem Interview mit CBS, dass jeder, der KI einsetzt, mit Halluzinationen konfrontiert ist, doch niemand in der Branche hat das Problem der Halluzinationen bisher gelöst. Fast alle KI-Modelle haben mit diesem Problem zu kämpfen. Er behauptete weiter und versicherte, dass die KI-Branche bald Fortschritte bei der Überwindung von KI-Halluzinationen machen wird.

Zur gleichen Zeit besuchte Sam Altman, der CEO des ChatGPT-Herstellers OpenAI, im Juni 2023 das indische Indraprastha Institute of Information Technology in Delhi, wo er bemerkte, dass das Problem der KI-Halluzinationen in anderthalb bis zwei Jahren an einem viel besseren Ort sein würde.

Er fügte weiter hinzu, dass das Modell den Unterschied zwischen Genauigkeit und Kreativität lernen müsse und wann das eine oder das andere eingesetzt werden sollte. Sie können sich den YouTube-Link zu Altmans Vortrag hier ansehen.

Einpacken

Die KI-Halluzination hat in den letzten Jahren viel Aufmerksamkeit erregt und ist ein Schwerpunktbereich für Unternehmen und Forscher, die versuchen, sie so früh wie möglich zu lösen und zu überwinden.

Obwohl die KI bemerkenswerte Fortschritte gemacht hat, ist sie nicht vor Fehlern gefeit, und das Problem der KI-Halluzinationen stellt mehrere Personen und Branchen vor große Herausforderungen, darunter das Gesundheitswesen, die Content-Generierung und die Automobilbranche.

Während die Forscher ihren Teil dazu beitragen, liegt es auch in unserer Verantwortung als Nutzer, spezifische und genaue Eingabeaufforderungen zu geben, Beispiele hinzuzufügen und Datenvorlagen bereitzustellen, um gültige und sinnvolle Antworten zu nutzen, die Trainingsdaten des KI-Modells nicht zu beeinträchtigen und Halluzinationen zu vermeiden.

Selbst wenn KI-Halluzinationen vollständig geheilt oder behoben werden können, bleibt die Frage bestehen. Ich persönlich glaube, dass es Hoffnung gibt und wir KI-Systeme weiterhin verantwortungsvoll und sicher zum Nutzen der Welt einsetzen können.