Llama 2 es una familia de grandes modelos lingüísticos (LLM) preentrenados y afinados desarrollada por Meta, disponible para uso personal y comercial sin coste alguno, con distintos tamaños para adaptarse a casos de uso y requisitos computacionales específicos.

Meta lanzó la serie Llama de LLMs, seguida por la popularidad de ChatGPT de OpenAI. Llama 2 está ahora disponible de forma gratuita para que todo el mundo pueda utilizarla y experimentar con la tecnología de IA generativa.

¿Qué es Llama 2?

Llama 2 es una colección de LLMs construidos por Meta. Un LLM es un tipo específico de red neuronal entrenada para manejar entradas relacionadas con el lenguaje y responder del mismo modo.

El modelo fundacional, Llama 2, ha sido entrenado con dos billones de tokens y tiene diferentes tamaños de modelo que van de 7 a 70 billones de parámetros. El otro, Llama 2 Chat, se ha optimizado adicionalmente para diálogos mediante un ajuste fino supervisado y se ha entrenado con más de un millón de nuevas anotaciones humanas para garantizar la seguridad y la utilidad.

Llama 2, aunque está disponible para uso personal, se dirige principalmente a los profesionales de la empresa. Ayudará a los desarrolladores a crear rápidamente sus propias aplicaciones basadas en IA generativa. Especialmente, las versiones afinadas (Llama 2 Chat y Llama Código) son magníficas para que las pequeñas empresas se pongan en marcha sin gastar recursos en la formación previa.

¿Cómo funciona Llama 2?

Llama 2 es un modelo lingüístico autorregresivo basado en una arquitectura de transformadores. Esto significa que toma la secuencia de palabras como entrada para generar la salida un token cada vez, al tiempo que toma continuamente el contexto de la respuesta en curso.

Los LLM como Llama 2 y Llama 2 Chat pueden comprender fácilmente el lenguaje cotidiano, lo que les ayuda a as tareas de procesamiento del lenguaje natural (PLN), como la escritura, la codificación, la traducción, el resumen, etc., dentro de una sencilla interfaz de chat.

El modelo base, Llama 2, necesita un ajuste fino para servir a casos de uso específicos. Por otro lado, Llama 2 Chat se ha optimizado para los diálogos, como su conocido competidor, ChatGPT.

Requisitos del sistema para ejecutar Llama 2

Para ejecutar Llama 2 con eficacia, Meta recomienda utilizar varias GPU de gama ultra alta, como las NVIDIA A100 o H100, y utilizar técnicas como el paralelismo tensorial. Los requisitos específicos de hardware dependen de la velocidad deseada y del tipo de tarea.

El paralelismo tensorial consiste en ejecutar redes neuronales a gran escala dividiendo la carga de trabajo entre varios dispositivos.

Meta afirma además que Llama 2 puede ejecutarse con unidades de procesamiento tensorial (TPU) y también con hardware estándar de bajo coste a través de proyectos de optimización como llama.cpp y MLC LLM.

En cuanto al software, Llama 2 sólo está soportado oficialmente en Linux. Aún así, existe soporte no oficial para otros sistemas operativos. Por ejemplo, llama.cpp puede ayudarle a experimentar Lllama 2 en macOS, Windows, Linux, FreeBSD e incluso como imagen Docker. Del mismo modo, MLC LLM también es compatible con Android e iOS, además de las principales plataformas de escritorio.

Características de Llama 2

Llama 2 ofrece características como el soporte de idiomas, la distribución, la versión de codificación, las variantes del modelo, etc.

- Soporte multilingüe: Llama 2 está capacitada principalmente en inglés, pero también funciona en otros 28 idiomas, con una capacidad limitada en ellos. Los proyectos impulsados por la comunidad están trabajando para mejorar la compatibilidad con otros idiomas.

- Accesibilidad y distribución: Meta ha liberado Llama 2 bajo una licencia permisiva para uso personal y comercial gratuito. Las empresas con menos de 700 millones de usuarios activos mensuales pueden utilizarlo gratuitamente, mientras que las demás necesitan la aprobación de Meta.

- Capacidades avanzadas de codificación: Code Llama, una versión de Llama 2 específica para la codificación, ha sido creada por Meta para la programación. Se ha lanzado en tres variantes: modelo base, especializado en Python, y el último para una mejor comprensión de las instrucciones en lenguaje natural.

- Variantes del modelo: Llama 2 se presenta en varios tamaños de modelo, como 7B, 13B, 34B y 70B, lo que ofrece amplias posibilidades de elección para diferentes tareas y disponibilidad computacional.

- Flexibilidad de despliegue: Uno puede desplegar Llama 2 en hardware de nivel empresarial o en equipos básicos. Además, puede disponer de configuraciones preconfiguradas de Llama 2 con proveedores de servicios en la nube, como Microsoft Azure, AWS y Google Cloud.

- Capacidades autorregresivas: Llama 2 responde de forma autorregresiva, lo que le permite generar texto contextualmente relevante. Esto la convierte en un modelo de IA muy adecuado para la generación de historias, conversaciones y creación de contenidos de corto alcance.

¿Cómo utilizar Llama 2?

Hay múltiples maneras de utilizar Llama 2, incluyendo localmente, en la nube y con plataformas de terceros.

Instalación local: Este método implica varios pasos, como solicitar el acceso al modelo desde Meta, descargar Python y satisfacer otras dependencias, cargar el modelo, tokenizar la entrada, generar el texto y realizar el ajuste fino (opcional).

En la nube: El uso de Llama 2 en el socio oficial de Meta, Azure, comienza por localizarlo en el catálogo de modelos y seleccionar el preferido de la colección tras comprobar sus fichas de modelo. A continuación, configure los parámetros de inferencia, ajuste el modelo, evalúelo con datos de prueba y despliéguelo.

Plataformas de terceros: Este es el método más sencillo para probar el rendimiento de estos modelos. Existen sitios web como llama2.ai que permiten seleccionar el modelo, ajustar los parámetros de inferencia y realizar pruebas.

Llama frente a Llama 2: Diferencias que debe conocer

Llama 2 es una mejora significativa respecto a su predecesora, Llama. He aquí una tabla que resume algunas diferencias importantes entre ellos.

| Atributos | Llama | Llama 2 |

|---|---|---|

| Fecha de lanzamiento | 24 de febrero de 2023 | 18 de julio de 2023 |

| Formación | 1-1,4 billones de tokens | 2 billones de fichas |

| Longitud del contexto | 2048 tokens | 4096 fichas |

| Variantes del modelo | 7B, 13B, 33B, 65B | 7B, 13B Y 70B |

| Modelos oficiales afinados | No | Llama 2 Chat y Código Llama |

| Soporte de idiomas | 20 Idiomas | 27 Idiomas |

| Huella de carbono de la formación de modelos | 1.015 tCO2eq | 539 tCO2eq (compensadas) |

| Disponibilidad nativa en la nube | No compatible | Azure, AWS, GCP, etc. |

Además, Llama 2 supera a Llama en la mayoría de los estándares de PNL, como MMLU, TriviaQA, HumanEval, Natural Questions, AGIEval, etc., lo que indica un mejor rendimiento general.

Comparación de Llama 2, GPT y Géminis: un análisis detallado de las características y el rendimiento

Llama2, GPT y Géminis pertenecen a la misma liga de LLM. Sin embargo, la mayor diferencia entre ellos es que GPT y Géminis son proyectos de código cerrado, mientras que Llama 2 es un proyecto de código abierto. Esto da a los desarrolladores la libertad de construir sus aplicaciones sobre el LLM de Meta.

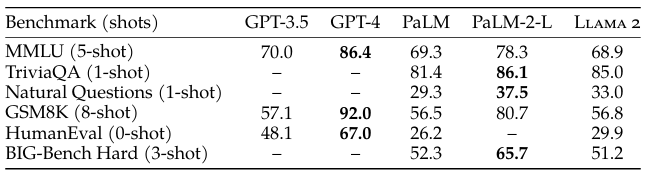

En cuanto al rendimiento, GPT-4 se sitúa por delante de Llama 2 y Gemini (PaLM2) en las pruebas comparativas, incluyendo la base de conocimientos general (MMLU), las matemáticas básicas (GSM8K) y la codificación (HumanEval).

Géminis obtiene unos resultados impresionantes en investigación y análisis (TriviaQA), recuperación de información en tiempo real (Natural Questions) y razonamiento de alto nivel (BIG-Bench Hard).

Llama 2 rindió a la par que GPT-3.5, excepto en las tareas relacionadas con la codificación. En general, Llama 2 resultó ser un gato de todos los oficios LLM sin un solo punto de pura brillantez. El mayor incentivo para implantar Llama2 sigue siendo que es de código abierto y gratuito.

¡Apueste por Llama 2!

Meta ha hecho más accesible la tecnología LLM con Llama 2, permitiendo a las empresas integrar modelos preentrenados en sus aplicaciones. Sin embargo, algunos particulares podrían pasarse a la competencia debido a la interfaz simplificada y a la limitada disponibilidad geográfica de Meta AI.

Llama 2 se dirige principalmente a las empresas, pero requiere más mejoras antes de popularizarse. También puede integrarse con las aplicaciones metaverso de Meta para mejorar las conversaciones e interacciones en entornos virtuales.

Preguntas frecuentes

Llama 2 puede utilizarse para construir aplicaciones basadas en IA generativa, similares a ChatGPT.

No. GPT-4 es mejor que Llama 2 a la hora de responder a múltiples consultas sobre dominios específicos, matemáticas y tareas de codificación.

Sí. Llama 2 es gratuito para uso personal y comercial, pero las organizaciones con más de 700 millones de usuarios activos al mes deben ponerse en contacto con Meta para conocer las condiciones adicionales.

Sí, Llama 2 está disponible para uso comercial. Una empresa puede desplegar Llama 2 in situ o utilizando servicios en la nube como Microsoft Azure, AWS y Google Cloud.

Llama 2 ha sido entrenado en 27 idiomas, pero su soporte para idiomas distintos del inglés es limitado. Existen proyectos comunitarios disponibles para la búsqueda de soporte lingüístico adicional.

El soporte oficial de Llama 2 se limita a Linux, pero existen proyectos como llama.cpp y MLC LLM que permiten su ejecución en otros sistemas operativos, como Windows y macOS.

La arquitectura de Llama 2 difiere de Llama 1 en varios aspectos. Ambas variantes se basan en transformadores, pero Llama 2 presenta ajustes en el tamaño de los parámetros, los datos de entrenamiento y la longitud del contexto. Además, los modelos más grandes de Llama 2 utilizan la atención de consulta agrupada para mejorar la escalabilidad de la inferencia.