Sora AI es un modelo de texto a vídeo desarrollado por OpenAI, las mentes detrás de ChatGPT. Sora AI aún está en desarrollo, por lo que aprender a acceder a Sora tendrá que esperar… por ahora. A pesar de ello, estudiar su rendimiento en comparación con otros generadores de texto a vídeo es importante para navegar por el futuro de la creación de contenidos con IA.

Los vídeos de ejemplo de OpenAI demuestran la destreza de la IA Sora para producir visuales fotorrealistas. Además, no parece tener ningún problema a la hora de crear animaciones visualmente agradables similares a las de los dibujos animados. Los movimientos de los personajes, la iluminación, las proporciones y los detalles minuciosos (como las manchas faciales y la textura del pelaje) son bastante precisos. Por todo ello, la IA de Sora se perfila como el modelo ideal de IA de texto a vídeo.

Los mejores gener adores de IA de texto a vídeo disponibles hasta ahora son fáciles de usar y crean contenidos de alta calidad, aunque con notables limitaciones. Hasta ahora, incluso los generadores más utilizados sólo pueden producir con precisión rostros, torsos y voces humanas. OpenAI parece estar innovando características únicas que destacan entre la competencia.

El desarrollo de modelos de IA más nuevos, complejos y cada vez más impresionantes se ha convertido en una carrera armamentística. Aunque los programadores de IA trabajan duro para inventar herramientas novedosas y útiles, también es necesario implantar protocolos de seguridad.

Evitar que modelos tan potentes como Sora se utilicen para crear animaciones inapropiadas (que inciten al odio, que infrinjan los derechos de autor y otras posibilidades negativas) es vital. No sólo por nuestra seguridad, sino para aplicar las mejores prácticas racionales en la industria, algo que OpenAI se está tomando muy en serio.

Cómo acceder a Sora AI

Actualmente no hay acceso público a Sora AI. Sólo unos pocos individuos pueden utilizar este modelo de texto a vídeo. Además de los «equipos rojos» que investigan cómo hacer que su uso sea lo más seguro posible, OpenAI ha proporcionado acceso a unos pocos artistas, diseñadores y cineastas para que lo prueben.

En un reciente artículo de preguntas frecuentes de OpenAI sobre el acceso a Sora, la empresa afirmaba que no tienen un calendario respecto a la disponibilidad pública. Además, OpenAI no comparte detalles sobre quiénes están implicados fuera de sus oficinas. Vagamente, sí mencionaron el compromiso con los responsables políticos, los educadores, etc. para obtener información sobre el desarrollo y el uso responsables de Sora.

¿Puede convertirse en probador de la IA de Sora?

Hasta ahora, no hay forma oficial de convertirse en probador de Sora, nien miembro de los «equipos rojos» de OpenAI Ha habido muchos hilos sobre estas cuestiones en el foro de la comunidad de OpenAI. Sin embargo, los moderadores recuerdan rápidamente a los usuarios que no existe una forma oficial de apuntarse a las pruebas de Sora. Tras estos recordatorios, los hilos se cierran para evitar confundir a otros usuarios.

OpenAI está decidida a hacer que Sora sea lo más seguro posible antes de permitir que el público en general ponga sus manos en este complejo modelo de IA. La razón principal de la falta de detalles es también la seguridad. Dar información sobre los probadores es inseguro, ya que podrían ser un objetivo.

Por ello, es posible que pase algún tiempo antes de que el público tenga acceso a Sora. OpenAI está exagerando la calidad de su modelo de IA en desarrollo, por lo que es posible que un lanzamiento general no esté demasiado lejos en el futuro. La mayoría de las empresas tienden a comercializar sus servicios y productos mucho antes de su lanzamiento, pero no suelen hacerlo con años de antelación. Por lo tanto, una especulación razonable para el lanzamiento público de Sora AI sería más adelante, en 2024 o 2025.

Ejemplos del funcionamiento de Sora AI

Sora presume de una animación que define la industria en muchas áreas (iluminación, detalles minuciosos, etc.), pero tiene dificultades con los escollos habituales de la IA.

Lo que la IA de Sora no puede hacer todavía

Hay algunos problemas a la hora de interpretar conceptos e indicaciones. Por ejemplo, cuando se le dice que genere imágenes de un «cangrejo ermitaño que utiliza una bombilla incandescente como caparazón», Sora produce imágenes de una criatura parecida a un cangrejo con un caparazón genérico en la espalda que posee una bombilla en su parte trasera.

En esta duración playera de la animación, queda claro que el personaje sólo se parece vagamente a un cangrejo. Sí, tiene patas y pinzas, pero ninguna especie viva de cangrejo (o de animales parecidos a los cangrejos) tiene un caparazón como el que aparece en las imágenes de Sora. Además, la bombilla no se utiliza como caparazón, sino que simplemente está sujeta a la parte trasera del armazón del personaje.

Encontrará otro ejemplo en la página web de OpenAI dedicada a Sora. En uno de los cinco vídeos en los que se describen los puntos débiles actuales de Sora, uno de los más destacados muestra a un hombre corriendo en una cinta en marcha atrás. Criterios como las direcciones -arriba, abajo, izquierda y derecha- son actualmente difíciles de analizar para Sora. OpenAI ha sido transparente y honesta sobre las carencias de su modelo de conversión de texto a vídeo en desarrollo, lo que parece una señal de que saben dónde y cómo mejorar.

En general, hay 5 problemas principales (conocidos) con los gráficos de la IA de Sora:

- Interpretación direccional

- Los personajes y objetos aparecen y desaparecen

- Los objetos y los personajes se mueven unos a través de otros

- Definición de cuándo los objetos deben ser rígidos o blandos

- Determinación de los resultados de las interacciones físicas entre personajes y objetos

Tenga en cuenta que a la IA de Sora aún le queda un largo camino por recorrer antes de estar lista para el público. Como tal, sus fallos actuales serán abordados y corregidos, al menos hasta cierto punto.

Lo que la IA de Sora hace bien

Aunque el próximo generador de texto a vídeo de OpenAI no puede manejar todos los aspectos de las interacciones íntimas entre personajes y objetos, los efectos visuales son casi impecables cuando la atención se centra en el entorno.

Losamplios planos de cámara que muestran paisajes costeros y las nevadas vistas a vista de pájaro de Tokio son maravillosamente realistas. Del mismo modo, las tomas de la vida salvaje parecen convincentes.

Es más, Sora es experto en combinar componentes orgánicos e inorgánicos cuando las instrucciones son vagas. A diferencia de instrucciones complejas y únicas como «Dale a un cangrejo ermitaño una bombilla por caparazón», otras más sencillas y con más libertad como «Pastor alemán cibernético» dan resultados más atractivos.

Recuerde que los modelos de IA necesitan aprender a través de la ingesta de datos. Hay muchos más ejemplos visuales de perros con prótesis que imágenes de cangrejos ermitaños con objetos de cristal en la espalda.

En una nota similar, Sora AI tiene acceso a una gran cantidad de imágenes de la naturaleza para producir animaciones de estilo documental casi indistinguibles de la vida real. La generación de efectos visuales como una mariposa posada sobre una flor es coherente y elegante.

Por razones inversas, Sora puede crear contenidos impresionantemente estéticos en escenarios completamente ficticios. Cuando hay menos física del mundo real que tener en cuenta, los modelos de IA de texto a vídeo suelen rellenar de forma lógica los huecos de información puntual. Por lo tanto, las simulaciones que representan conceptos de ciencia ficción como drones corriendo en el planeta Marte tienen un aspecto estupendo, aunque no realista (por la naturaleza del prompt).

Idear un prompt para una animación más parecida a los dibujos animados se beneficia de esta libertad. Si se afina la redacción de un prompt, Sora puede convertir un párrafo de texto de entrada en un tramo de animación a la altura de Pixar y otros grandes estudios de animación. El resultado podría ser el adorable retozo de una ardilla esférica… ocualquier otra cosa que desee el usuario.

El extraño mundo de los generadores de texto a vídeo

Además de los que acuden en masa a los generadores de vídeo de IA con fines de diseño y realización cinematográfica, algunos desean acceder a Sora por diversión. Empujando los límites de los detalles de las instrucciones, los usuarios pueden acabar con algunos contenidos hilarantes y extraños. Desde carreras surrealistas en bicicleta a través de los océanos hasta la fusión con una manta en una cama, algunos resultados se disfrutan más por su valor cómico que con fines artísticos.

Por un lado, los aspectos fantásticos son tentadores para los tipos creativos que buscan diversión. Mientras que, por otro lado, estos aspectos visuales facilitan el desarrollo de las películas. Por ejemplo, si un director quiere rodar una escena ambientada en una realidad alternativa en la que los animales comen joyas, habría montones de problemas relacionados con los derechos de los animales, por no decir otra cosa. Sin embargo, con el acceso a la IA de Sora, esas escenas pueden generarse en un ordenador sin riesgo alguno.

Hoy en día, la industria cinematográfica trata mucho mejor que antes a los no humanos con compasión en el plató. Si no fuera así, ¡seguro que este podcast de Golden Retriever tendría algo que decir al respecto! Hablando en serio, los generadores de texto a vídeo revolucionarán la forma de hacer películas.

Una mirada a los procesos técnicos de Sora AI

Para entender cómo Sora puede crear vistas impresionantes y realizar trucos de magia con una cuchara, eche un vistazo al informe técnico de OpenAI.

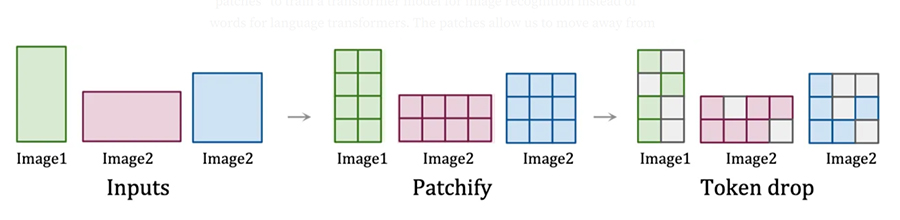

El proceso comienza con la compresión de los datos de la imagen en parches de espaciotiempo que actúan como fichas de transformación. En términos sencillos: los parches de espaciotiempo (en este caso) son pequeñas secciones de información visual que tienen marcadores temporales. Los tokens transformadores son el nivel más diminuto de las unidades de datos utilizadas en el entrenamiento de la IA: cada parche es un token.

Desglosando aún más el proceso

- Se identifican las entradas de imágenes

- Las entradas de imagen se diseccionan en parches

- Los parches aleatorios (tokens) se analizan hasta que todos han sido procesados

El proceso de parcheado y posterior conversión de los datos visuales en tokens permite a los modelos de IA aprender de forma eficaz. Esto permite a Sora determinar cómo se relacionan los elementos, cuándo se supone que deben producirse las acciones, así como muchas otras cosas. Además, esto permite a Sora consumir datos visuales de múltiples resoluciones y relaciones de aspecto. En concreto, la ingestión de imágenes y vídeos en sus formatos nativos entrena a los modelos de IA a calibrar con mayor precisión diversos aspectos visuales mediante la comparación de las diferencias entre cada ficha.

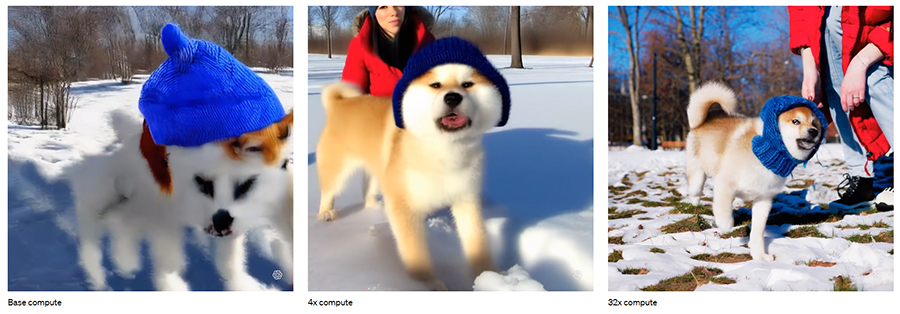

Dicho esto, ¡el proceso no termina aquí! Una vez engullidos los tokens, el cálculo complejo se ejecuta varias veces por secuencia de generación de contenidos. Al principio (en el cómputo base), el vídeo creado parece abstracto. Sin embargo, a medida que aumenta el cómputo de entrenamiento, Sora se vuelve cada vez más capaz de producir visuales análogos a los de la vida real.

Opinión del autor

Lo que se ha visto de Sora hasta ahora deja a la competencia fuera del agua. Los generadores de texto a vídeo existentes sólo son viables para insertar un anfitrión humano en el contenido. Nada de lo que hay actualmente en el mercado puede crear vídeos complejos, asombrosos y (sobre todo) realistas a partir de sólo indicaciones de texto.

Para equilibrar la balanza: La IA de Sora tiene un largo camino por recorrer antes de que se permita al público acceder a ella. Dicho esto, resulta increíblemente prometedora para muchos fines artísticos y científicos. No sólo puede ser una herramienta fantástica en la realización de películas, sino que algún día puede permitir a los científicos simular escenarios antes imposibles. Sí, el concepto de física de Sora tiene que mejorar mucho antes de que pueda utilizarse para este último fin; sin embargo, es probable que tanto ella como otros modelos de IA similares lo consigan en unos años.

Por ejemplo, imagine un mundo en el que las mentes más brillantes puedan utilizar generadores de texto a vídeo para simular los resultados de diversos accidentes. Hacerlo puede ayudar a los investigadores a crear trajes de seguridad de una calidad inigualable con una fracción de su presupuesto anterior. A su vez, esto reduciría las lesiones, las facturas médicas y los costes de las operaciones hospitalarias, todo lo cual beneficiaría a la sociedad.

Sin embargo, eso aún está muy lejos. Mientras los líderes de la industria trabajan para profundizar en el conocimiento de Sora y modelos similares, hay un montón de vídeos de IA descabellados con los que disfrutar. Hasta entonces, siéntese, relájese y planifique el futuro.