El sesgo algorítmico puede afectar a varios aspectos de nuestras vidas, desde obtener recomendaciones de contenidos en línea hasta encontrar trabajo y tomar decisiones financieras.

El sesgo está en la naturaleza humana. Cada persona tiene un género, una raza, una educación, una cultura, unas creencias, unas experiencias, etc. diferentes.

Por lo tanto, sus opiniones, pensamientos, gustos y preferencias varían de unos a otros. Pueden desarrollar ciertos prejuicios hacia o contra determinadas categorías.

Las máquinas no son diferentes. Éstas también pueden ver a las personas, las cosas y los acontecimientos de forma diferente debido a los sesgos introducidos en sus algoritmos. Debido a estos sesgos, los sistemas de IA y ML pueden producir resultados injustos, perjudicando a las personas de muchas maneras.

En este artículo, hablaré sobre qué son los sesgos algorítmicos, sus tipos y cómo detectarlos y reducirlos para mejorar la imparcialidad en los resultados.

Comencemos

¿Qué son los sesgos algorítmicos?

Un sesgo algorítmico es la tendencia de los algoritmos de ML e IA a reflejar sesgos similares a los humanos y generar resultados injustos. Los sesgos pueden basarse en el género, la edad, la raza, la religión, la etnia, la cultura, etc.

En el contexto de la inteligencia artificial y el aprendizaje automático, los sesgos algorítmicos son errores sistemáticos y repetibles introducidos en un sistema que producen resultados injustos.

Los sesgos en los algoritmos pueden surgir por muchas razones, como decisiones relacionadas con la forma en que se recogen, eligen, codifican o utilizan los datos en el entrenamiento del algoritmo, el uso previsto, el diseño del algoritmo, etc.

Ejemplo: Se puede observar un sesgo algorítmico en el resultado de un motor de búsqueda, lo que da lugar a violaciones de la privacidad, sesgos sociales, etc.

Hay muchos casos de sesgos algorítmicos en ámbitos como los resultados electorales, la difusión de discursos de odio en línea, la sanidad, la justicia penal, la contratación, etc. Esto está agravando los sesgos existentes en materia de género, raza, economía y sociedad.

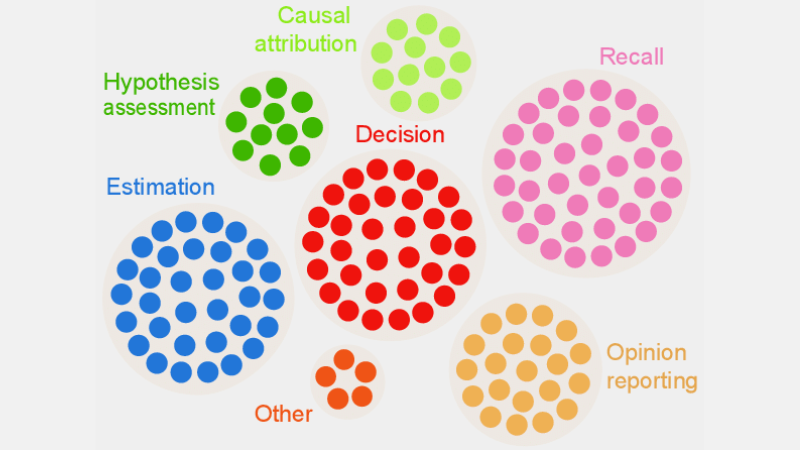

Tipos de sesgos algorítmicos

#1. Sesgo de datos

El sesgo de los datos se produce cuando los datos necesarios para entrenar un modelo de IA no representan adecuadamente escenarios o poblaciones del mundo real. Esto puede dar lugar a conjuntos de datos desequilibrados o sesgados.

Ejemplo: Supongamos que una solución de software de reconocimiento facial se entrena principalmente en la población blanca. Entonces, puede tener un rendimiento deficiente cuando se le encargue reconocer a personas con tonos de piel más oscuros, lo que les afectaría.

#2. Sesgo de medición

Este sesgo puede surgir debido a un error en el proceso de medición o recopilación de datos.

Ejemplo: Si se entrena un algoritmo de diagnóstico sanitario para detectar una enfermedad basándose en algunas métricas como las visitas previas al médico, puede nublar el juicio y causar un sesgo al pasar por alto los síntomas reales.

#3. Sesgo de modelo

Los sesgos de modelo surgen al diseñar el algoritmo o el modelo de IA.

Ejemplo: Supongamos que un sistema de IA tiene un algoritmo diseñado para maximizar los beneficios a toda costa; podría acabar dando prioridad a las ganancias financieras a costa de la ética empresarial, la seguridad, la equidad, etc.

#4. Sesgo de evaluación

El sesgo de evaluación puede producirse cuando los factores o criterios para evaluar el rendimiento de un sistema de IA están sesgados.

Ejemplo: Si un sistema de IA de evaluación del rendimiento utiliza pruebas estándar que favorecen a una categoría específica de empleados de una empresa, puede fomentar las desigualdades.

#5. Sesgo de información

El sesgo de notificación puede producirse cuando el conjunto de datos de entrenamiento carece de un reflejo exacto de la realidad en su frecuencia de eventos.

Ejemplo: Si una herramienta de seguridad de IA no obtiene buenos resultados en una categoría específica, puede marcar toda la categoría como sospechosa.

Esto significa que el conjunto de datos sobre el que se ha entrenado el sistema marcó cada incidente histórico relacionado con esa categoría como inseguro debido a la mayor frecuencia de incidentes.

#6. Sesgo de selección

El sesgo de selección surge cuando los datos de entrenamiento se seleccionan sin una aleatorización adecuada o no representan bien a la población total.

Ejemplo: Si una herramienta de reconocimiento facial se entrena con datos limitados, puede empezar a mostrar cierta discriminación contra los datos con los que se encuentra menos, como identificar a las mujeres de color en política que a los hombres y a los individuos de piel más clara en política.

#7. Sesgo implícito

El sesgo implícito surge cuando el algoritmo de IA hace suposiciones basadas en ciertas experiencias personales, que podrían no aplicarse a categorías o personas más amplias de forma explícita.

Ejemplo: Si un científico de datos que diseña un algoritmo de IA cree personalmente que a las mujeres les gusta principalmente el rosa y no el azul o el negro, el sistema puede recomendar productos en consecuencia, lo que no se aplica a todas las mujeres. A muchas les gusta el azul o el negro.

#8. Sesgo de atribución de grupo

Este sesgo puede producirse cuando los diseñadores de algoritmos aplican cosas que están pensadas para ciertos individuos a un grupo completo, tanto si esos individuos forman parte del grupo como si no. El sesgo de atribución de grupo es común en las herramientas de reclutamiento y admisión.

Ejemplo: Una herramienta de admisión puede favorecer a los candidatos de una escuela específica, discriminando a otros estudiantes que no pertenecen a esa escuela.

#9. Sesgo histórico

La recopilación de conjuntos de datos históricos es importante cuando se reúnen conjuntos de datos para entrenar un algoritmo de ML. Pero si no presta atención, pueden producirse sesgos en sus algoritmos debido a los sesgos presentes en sus datos históricos.

Ejemplo: Si entrena un modelo de IA con 10 años de datos históricos para preseleccionar candidatos a puestos técnicos, podría favorecer a los solicitantes masculinos si en los datos de entrenamiento hay más hombres que mujeres.

#10. Sesgo de etiqueta

Al entrenar algoritmos de ML, es posible que tenga que etiquetar muchos datos para que resulten útiles. Sin embargo, el proceso de etiquetado de los datos podría variar mucho, generando incoherencias e introduciendo sesgos en el sistema de IA.

Ejemplo: Supongamos que entrena un algoritmo de IA etiquetando gatos en imágenes mediante cajas. Si no presta atención, el algoritmo podría fallar en la identificación de un gato en una imagen si no se ve su cara, pero puede identificar los que tienen caras de gato.

Esto significa que el algoritmo tiene un sesgo en la identificación de imágenes con gatos que miran de frente. No puede identificar al gato si la imagen está tomada desde un ángulo diferente en el que se ve el cuerpo pero no la cara.

#11. Sesgo de exclusión

El sesgo de exclusión surge cuando una persona específica, un grupo de personas o una categoría se excluye involuntaria o intencionadamente durante la recopilación de datos si se piensa que son irrelevantes. Ocurre sobre todo durante la fase de preparación de los datos del ciclo de vida del LD, en el momento de limpiar los datos y prepararlos para su uso.

Ejemplo: Supongamos que un sistema de predicción basado en IA tiene que determinar la popularidad de un producto específico durante la temporada de invierno basándose en su tasa de compra. Entonces, si un científico de datos se da cuenta de algunas compras en octubre y elimina esos registros, pensando que son erróneos y tomando como duración estándar de noviembre a enero. Pero hay lugares en los que el invierno supera esos meses. Por tanto, el algoritmo estará sesgado hacia los países que reciben el invierno de noviembre a enero.

¿Cómo se introducen los sesgos en los algoritmos?

Datos de entrenamiento

La principal fuente de sesgo algorítmico son los datos sesgados utilizados para entrenar los algoritmos de IA y ML. Si los propios datos de entrenamiento contienen elementos de desigualdad y prejuicios, el algoritmo aprenderá esos elementos y perpetuará los sesgos.

Diseño

Al diseñar el algoritmo, el desarrollador puede introducir a sabiendas o sin saberlo los reflejos de pensamientos o preferencias personales en el sistema de IA. Así, el sistema de IA estará sesgado hacia determinadas categorías.

Toma de decisiones

Muchas veces, los científicos de datos y los líderes toman decisiones basándose en sus experiencias personales, su entorno, sus creencias, etcétera. Estas decisiones también se reflejan en los algoritmos, lo que provoca sesgos.

Falta de diversidad

Debido a la falta de diversidad en el equipo de desarrollo, los miembros del equipo acaban creando algoritmos que no representan a toda la población. No tienen experiencia ni están expuestos a otras culturas, orígenes, creencias, formas, etc., por lo que sus algoritmos pueden estar sesgados de una determinada manera.

Preprocesamiento de datos

El método utilizado para limpiar y procesar los datos puede introducir un sesgo algorítmico. Además, si no se diseñan estos métodos cuidadosamente para contrarrestar el sesgo, éste podría agravarse en el modelo de IA.

Arquitectura

La arquitectura del modelo y el tipo de algoritmo de ML que elija también pueden introducir sesgos. Algunos algoritmos atraen el sesgo más que otros, junto con la forma en que están diseñados.

Selección de características

Las características que elija para entrenar un algoritmo de IA son una de las causas del sesgo. Si no elige las características teniendo en cuenta su impacto en la imparcialidad del resultado, puede surgir cierto sesgo, favoreciendo algunas categorías.

Historia y cultura

Si un algoritmo se alimenta y se entrena con datos tomados de la historia o de determinadas culturas, puede heredar sesgos como prejuicios, creencias, normas, etc. Estos sesgos pueden influir en los resultados de la IA aunque sean injustos e irrelevantes en el presente.

Deriva de datos

Los datos que utiliza hoy para entrenar sus algoritmos de IA pueden volverse irrelevantes, inútiles u obsoletos en el futuro. Esto podría deberse a la evolución de la tecnología o de la sociedad. Sin embargo, estos conjuntos de datos aún pueden introducir sesgos y obstaculizar el rendimiento.

Bucles de retroalimentación

Algunos sistemas de IA no sólo pueden comunicarse con los usuarios, sino también adaptarse a sus comportamientos. De este modo, el algoritmo puede potenciar los sesgos existentes. Así, cuando los sesgos personales de los usuarios entran en el sistema de IA, éste puede generar un bucle de retroalimentación sesgado.

¿Cómo detectar el sesgo algorítmico?

Defina qué es «justo

Para detectar resultados injustos o sesgos en los algoritmos, necesita definir qué implica exactamente «justo» para el sistema de IA. Para ello, puede tener en cuenta factores como el sexo, la edad, la raza, la sexualidad, la región, la cultura, etc.

Determine las métricas para calcular la equidad, como la igualdad de oportunidades, la paridad predictiva, los impactos, etc. Una vez definida la «imparcialidad», le resultará más fácil detectar lo que no es justo y resolver la situación.

Audite los datos de formación

Analice a fondo sus datos de entrenamiento para buscar desequilibrios e incoherencias en la representación de las distintas categorías. Debe examinar la distribución de las características y comprobar si representa o no la demografía del mundo real.

Para visualizar los datos, puede crear histogramas, mapas de calor, gráficos de dispersión, etc. para resaltar las disparidades y los patrones que no pueden revelarse con la ayuda de un mero análisis estadístico.

Aparte de las auditorías internas, puede involucrar a expertos y auditores externos para evaluar el sesgo del sistema.

Mida el rendimiento del modelo

Para detectar sesgos, intente medir el rendimiento de su modelo de IA para varios grupos demográficos y categorías. Le ayudará dividir la formación en diferentes grupos en función de la raza, el sexo, etc. También puede utilizar sus métricas de imparcialidad para calcular las diferencias en los resultados.

Utilice algoritmos adecuados

Elija algoritmos que promuevan resultados justos y puedan abordar el sesgo en el entrenamiento de un modelo de IA. Los algoritmos que tienen en cuenta la imparcialidad pretenden evitar el sesgo al tiempo que garantizan la igualdad de predicciones en las distintas categorías.

Software de detección de sesgos

Puede utilizar herramientas y bibliotecas especializadas que tengan en cuenta la imparcialidad para detectar sesgos. Estas herramientas ofrecen métricas de imparcialidad, visualizaciones, pruebas estadísticas y mucho más para detectar sesgos. Algunas de las más populares son AI Fairness 360 e IBM Fairness 360.

Busque la opinión de los usuarios

Pida a los usuarios y clientes su opinión sobre el sistema de IA. Anímeles a dar su opinión sincera si han sentido algún tipo de trato injusto o sesgo en el sistema de IA. Estos datos le ayudarán a descubrir problemas que podrían no ser señalados en las herramientas automatizadas y otros procedimientos de detección.

Cómo mitigar el sesgo en los algoritmos

Diversifique su empresa

Crear diversidad en su empresa y en su equipo de desarrollo permite detectar y eliminar más rápidamente los sesgos. La razón es que los sesgos pueden ser advertidos rápidamente por los usuarios que se ven afectados por ellos.

Por lo tanto, diversifique su empresa no sólo en términos demográficos, sino también en habilidades y experiencia. Incluya a personas de diferentes géneros, identidades, razas, colores de piel, orígenes económicos, etc., así como a personas con diferentes experiencias educativas y formación.

De este modo, conseguirá recoger perspectivas, experiencias, valores culturales, gustos y aversiones muy variados, etc. Esto le ayudará a mejorar la imparcialidad de sus algoritmos de IA, reduciendo los sesgos.

Promueva la transparencia

Sea transparente con su equipo sobre el objetivo, los algoritmos, las fuentes de datos y las decisiones relativas a un sistema de IA. Esto permitirá a los usuarios comprender cómo funciona el sistema de IA y por qué genera determinados resultados. Esta transparencia fomentará la confianza.

Algoritmos conscientes de la equidad

Utilice algoritmos conscientes de la equidad cuando desarrolle el modelo para garantizar que se generan resultados justos para las diferentes categorías. Esto resulta evidente si crea sistemas de IA para sectores muy regulados como las finanzas, la sanidad, etc.

Evalúe el rendimiento del modelo

Ponga a prueba sus modelos para examinar el rendimiento de la IA en varios grupos y subgrupos. Le ayudará a comprender problemas que no son visibles en las métricas agregadas. También puede simular distintos escenarios para comprobar su rendimiento en ellos, incluidos los complejos.

Siga unas directrices éticas

Formule algunas directrices éticas para el desarrollo de sistemas de IA, respetando la equidad, la privacidad, la seguridad y los derechos humanos. Debe hacer cumplir esas directrices en toda su organización para que la equidad aumente en toda la organización y se refleje en los resultados del sistema de IA.

Establezca controles y responsabilidades

Establezca responsabilidades claras para todos los miembros del equipo que trabajen en el diseño, el desarrollo, el mantenimiento y la implantación del sistema de IA. También debe establecer controles adecuados con protocolos y marcos estrictos para abordar los sesgos, los errores y otras preocupaciones.

Aparte de lo anterior, debe realizar auditorías periódicas para reducir los sesgos y esforzarse por conseguir mejoras continuas. Asimismo, manténgase al día de los cambios recientes en la tecnología, la demografía y otros factores.

Ejemplos reales de sesgos algorítmicos

#1. El algoritmo de Amazon

Amazon es líder en la industria del comercio electrónico. Sin embargo, su herramienta de contratación que utilizaba IA para evaluar a los solicitantes de empleo según sus cualificaciones mostró un sesgo de género. Este sistema de IA se entrenó utilizando currículos de candidatos anteriores en los puestos técnicos.

Por desgracia, los datos contenían un mayor número de solicitantes masculinos, lo que la IA aprendió. Así, favoreció involuntariamente a los solicitantes masculinos en puestos técnicos frente a las mujeres, que estaban infrarrepresentadas. Amazon tuvo que descontinuar la herramienta en 2017 a pesar de hacer esfuerzos para reducir el sesgo.

#2. Algoritmos racistas en la sanidad estadounidense

Un algoritmo que los hospitales con sede en EE UU utilizaban para prever los pacientes que necesitaban cuidados adicionales tenía un fuerte sesgo hacia los pacientes blancos. El sistema evaluaba las necesidades médicas de los pacientes basándose en su historial de gastos en atención sanitaria, correlacionando el coste con las necesidades médicas.

El algoritmo del sistema no tenía en cuenta cómo pagaban los pacientes blancos y negros sus necesidades sanitarias. A pesar de no controlar la enfermedad, los pacientes negros pagaban sobre todo las urgencias. Así, se les categorizó como pacientes más sanos y no reunían los requisitos para recibir atención adicional en comparación con los pacientes blancos.

#3. El algoritmo discriminatorio de Google

El sistema de anuncios en línea de Google resultó discriminatorio. Mostraba los puestos mejor pagados, como los de director general, a los hombres en una proporción significativamente mayor que a las mujeres. Aunque el 27% de los directores ejecutivos estadounidenses son mujeres, la representación de éstas es mucho menor en Google, en torno al 11%.

El algoritmo podría haber mostrado el resultado aprendiendo el comportamiento de los usuarios, como que las personas que ven y hacen clic en los anuncios de puestos bien pagados son hombres; el algoritmo de IA mostrará esos anuncios a los hombres más que a las mujeres.

Conclusión

El sesgo algorítmico en los sistemas de ML e IA puede conducir a resultados injustos. Estos resultados pueden afectar a las personas en diversos campos, desde la sanidad, la ciberseguridad y el comercio electrónico hasta las elecciones, el empleo y otros. Puede llevar a la discriminación por motivos de género, raza, demografía, orientación sexual y otros aspectos.

De ahí la importancia de reducir los sesgos en los algoritmos de IA y ML para promover la equidad en los resultados. La información anterior le ayudará a detectar los sesgos y a reducirlos para que pueda crear sistemas de IA justos para los usuarios.

También puede leer sobre la gobernanza de la IA.