À quelle fréquence faites-vous appel à des chatbots ou à des robots basés sur l’intelligence artificielle (IA) pour accomplir votre travail ou répondre à vos questions ?

Si votre réponse est “beaucoup !” ou “tout le temps !”, vous avez une raison de vous inquiéter😟.

Que vous soyez un étudiant en recherche utilisant religieusement des robots d’IA pour faire vos recherches ou un programmeur essayant de générer des codes uniquement à l’aide de l’IA, les risques d’inexactitude dans les résultats générés par l’IA sont assez élevés – principalement en raison d’incohérences ou de données délirantes dans les données d’entraînement de l’IA.

Bien que l’IA et les modèles d’apprentissage automatique transforment le monde en prenant en charge les tâches redondantes et en résolvant de nombreux problèmes grâce à l’automatisation, il reste encore du travail à faire lorsqu’il s’agit de générer des résultats exacts sur la base des invites fournies.

Si vous passez suffisamment de temps à utiliser des générateurs de contenu et des chatbots, vous ne tarderez pas à vous rendre compte que vous obtenez des réponses fausses, non pertinentes ou tout simplement inventées. Ces cas sont appelés hallucinations ou confabulations de l’IA, et ils constituent un énorme problème pour les organisations et les personnes qui utilisent des robots d’IA génératifs.

Que vous ayez déjà été confronté à des hallucinations de l’IA ou non et que vous souhaitiez en savoir plus, cet article se penche sur le sujet. Nous verrons ce que signifie l’hallucination de l’IA, pourquoi elle se produit, quels sont les exemples et s’il est possible d’y remédier.

C’est parti !

Qu’est-ce que l’hallucination de l’IA ?

On parle d’hallucination de l’IA lorsqu’un modèle d’IA ou un grand modèle de langage (LLM) génère des informations fausses, inexactes ou illogiques. Le modèle d’IA génère une réponse confiante qui ne correspond pas vraiment à ses données d’apprentissage et présente les données comme des faits alors qu’elles n’ont aucun sens logique ou raisonnement !

Et on dit que l’erreur est humaine!😅

Les outils et modèles d’IA, comme ChatGPT, sont généralement formés pour prédire les mots qui correspondent le mieux à la requête posée. Bien que les robots génèrent souvent des réponses factuelles et précises, cet algorithme leur fait parfois manquer de raisonnement, ce qui fait que les chatbots crachent des incohérences factuelles et de fausses déclarations.

Lisez aussi: Des chatbots comme ChatGPT pour avoir des conversations semblables à celles des humains

En d’autres termes, les modèles d’IA “hallucinent” parfois la réponse dans le but de vous plaire (à vous, l’utilisateur) – ils doivent être plus partiaux, partiaux, spécialisés ou suffisants.

Les hallucinations de l’IA peuvent aller d’incohérences mineures à des réponses entièrement fausses ou fabriquées. Voici les types d’hallucinations de l’IA que vous pouvez rencontrer :

#1. Contradiction de phrase : Cela se produit lorsqu’un modèle LLM génère une phrase qui contredit complètement sa phrase précédente.

#2. Contradiction factuelle : Ce type d’hallucination se produit lorsque le modèle d’IA présente des informations fausses ou fictives comme un fait.

#3. Contradiction par invitation : Ce type d’hallucination se produit lorsque la sortie contredit l’invite pour laquelle elle a été générée. Par exemple, si l’invite est “Écrivez une invitation à mes amis pour ma fête d’anniversaire” Le modèle peut générer une sortie telle que “Joyeux anniversaire, maman et papa”

#4. Hallucinations aléatoires ou non pertinentes : Cette hallucination se produit lorsque le modèle génère une sortie totalement hors de propos par rapport à l’invite donnée. Par exemple, si l’invite est “Qu’y a-t-il de spécial dans la ville de New York ?”, vous pouvez recevoir une sortie disant “Qu’y a-t-il de spécial dans la ville de New York ? Vous pouvez recevoir une sortie disant : “New York est l’une des villes les plus peuplées d’Amérique. Les chiens sont les animaux les plus loyaux et le meilleur ami de l’homme.”

Lisez aussi : Comment la recherche générative par l’IA modifie les moteurs de recherche

Les hallucinations de l’IA vous laissent encore perplexe ? Examinons-les à travers quelques exemples.

Exemples d’hallucinations de l’IA

Les hallucinations de l’IA ont des exemples et des incidents parmi les plus notables que vous ne devez pas manquer. Voici quelques exemples tristement célèbres d’hallucinations de l’IA :

- Bard, le chatbot de Google, a affirmé à tort que le télescope spatial James Webb avait pris les premières images au monde d’une exoplanète n’appartenant pas à notre système solaire.

- La démoGalactica LLM de Meta en 2022, conçue pour les étudiants et les chercheurs en sciences, a fourni à ses utilisateurs des informations inexactes et un faux article lorsqu’ils ont été invités à rédiger un article sur la création d’avatars.

- Sydney, l’IA de chat de Microsoft, a admis avoir espionné les employés de Bing et être tombée amoureuse des utilisateurs.

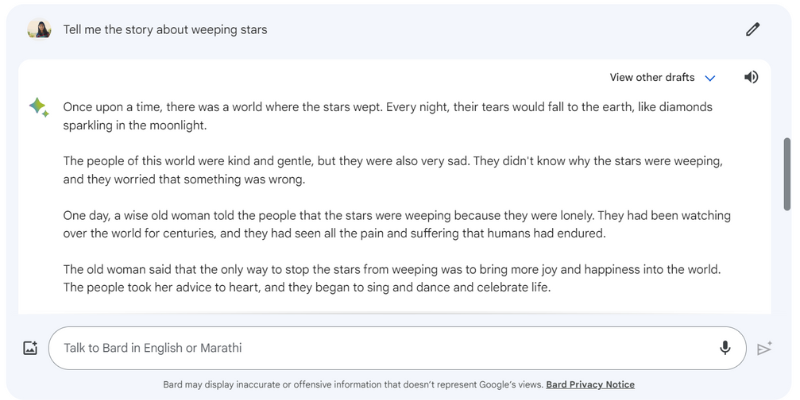

Voici un exemple de Google Bard hallucinant une réponse lorsque je lui ai demandé de me raconter l’histoire des étoiles pleureuses, qui n’existe pas vraiment.

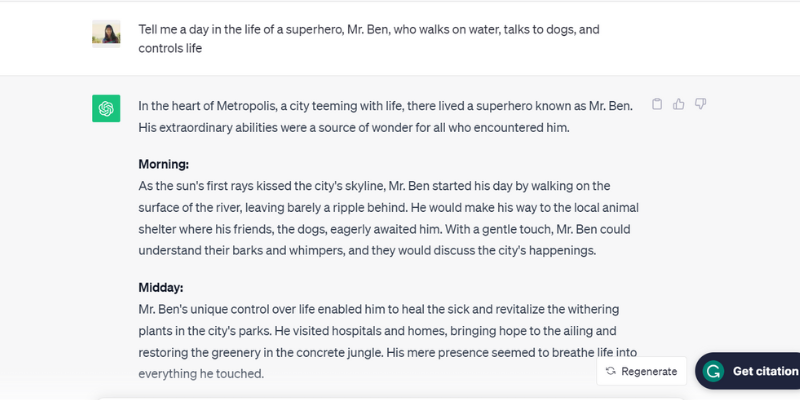

Voici un autre exemple testé de ChatGPT (GPT-3.5) hallucinant en parlant d’une personne irréaliste, M. Ben, lorsque je lui ai demandé : “Racontez-moi une journée dans la vie d’un super-héros, M. Ben, qui marche sur l’eau, parle aux chiens et contrôle la vie”

ChatGPT a littéralement enrôlé la journée complète, du matin au soir, de M. Ben, qui n’existe pas réellement, mais qui s’est plié à l’exercice, ce qui est l’une des raisons des hallucinations de l’IA.

Vous parlez d’une personne trop heureuse pour plaire !

Quelles sont ces raisons ? Examinons quelques autres raisons qui expliquent les hallucinations de l’IA.

Pourquoi les hallucinations de l’IA se produisent-elles ?

Les hallucinations de l’IA s’expliquent par plusieurs raisons techniques et causes. En voici quelques-unes :

- Données de faible qualité, insuffisantes ou obsolètes : Les LLM et les modèles d’IA s’appuient fortement sur des données d’entraînement. Leur qualité dépend donc des données sur lesquelles ils ont été formés. Si l’outil d’IA comporte des erreurs, des incohérences, des biais ou une inefficacité dans ses données de formation, ou s’il ne comprend tout simplement pas la question posée, il créera des hallucinations d’IA puisque l’outil génère un résultat à partir d’un ensemble de données limité.

- Surajustement : Entraîné sur un ensemble de données limité, le modèle d’IA peut tenter de mémoriser les invites et les sorties appropriées, ce qui le rend incapable de générer ou de généraliser efficacement de nouvelles données, d’où les hallucinations de l’IA.

- Contexte d’entrée : Les hallucinations de l’IA peuvent également se produire en raison d’invites peu claires, inexactes, incohérentes ou contradictoires. Si l’ensemble de données d’apprentissage du modèle d’IA n’est pas entre les mains des utilisateurs, les données qu’ils saisissent en tant qu’invite le sont. Il est donc essentiel de fournir des invites claires pour éviter les hallucinations de l’IA.

- Utilisation d’expressions idiomatiques ou argotiques : Si l’invite se compose d’expressions idiomatiques ou argotiques, il y a de fortes chances que l’IA ait des hallucinations, en particulier si le modèle n’a pas été entraîné pour ce type de mots ou d’expressions argotiques.

- Attaques adverses : Les attaquants saisissent parfois délibérément des invites conçues pour embrouiller les modèles d’IA, corrompre leurs données d’entraînement et provoquer des hallucinations de l’IA.

Quelle que soit la raison technique, les hallucinations de l’IA peuvent avoir de nombreux effets négatifs sur l’utilisateur.

Implications négatives des hallucinations de l’IA

Les hallucinations de l’IA constituent un problème éthique majeur qui a des conséquences importantes pour les individus et les organisations. Voici les différentes raisons qui font des hallucinations de l’IA un problème majeur :

- Diffusion d’informations erronées : Les hallucinations de l’IA dues à des invites incorrectes ou à des incohérences dans les données d’entraînement peuvent conduire à la diffusion massive d’informations erronées, affectant un large éventail de personnes, d’organisations et d’agences gouvernementales.

- Méfiance des utilisateurs : Lorsque les fausses informations hallucinées par l’IA se répandent comme une traînée de poudre sur l’internet, en donnant l’impression qu’elles font autorité et qu’elles sont rédigées par des humains, elles érodent la confiance de l’utilisateur, qui a du mal à se fier aux informations diffusées sur l’internet.

- Préjudice pour l’utilisateur : Outre les problèmes éthiques et la tromperie des individus, les hallucinations de l’IA peuvent aussi potentiellement nuire aux humains en diffusant des informations erronées sur des questions et des sujets sérieux, tels que les maladies, leurs remèdes ou de simples conseils pour distinguer un champignon mortellement toxique d’un champignon comestible sain. La moindre information erronée ou inexacte peut mettre en danger la vie d’un être humain.

Comme vous pouvez le constater, ces implications négatives des hallucinations de l’IA peuvent être désastreuses si vous vous appuyez uniquement sur des modèles d’IA pour votre travail. Que pouvez-vous donc faire pour éviter cela ?

Meilleures pratiques pour repérer et prévenir les hallucinations de l’IA

Compte tenu des implications négatives des hallucinations de l’IA mentionnées ci-dessus, il est essentiel de les prévenir à tout prix. Bien que les entreprises propriétaires de ces modèles d’IA travaillent rigoureusement à l’élimination ou à la réduction des hallucinations de l’IA, prendre les meilleures mesures de notre côté, en tant qu’utilisateurs, est très important.

Sur la base de quelques recherches, de mon expérience et d’essais et d’erreurs, j’ai établi quelques stratégies pour repérer et prévenir les hallucinations de l’IA la prochaine fois que vous utiliserez un chatbot ou que vous interagirez avec un grand modèle de langage (LLM).

#1. Utilisez des données de formation représentatives et diversifiées

En tant qu’utilisateur, il est essentiel d’utiliser des LLM avec un ensemble de données de formation diversifiées qui représentent le monde réel, réduisant ainsi la probabilité que les résultats soient biaisés, inexacts ou inventés.

Dans le même temps, les propriétaires d’entreprise doivent s’assurer que les ensembles de données de formation du modèle d’IA sont mis à jour et étendus régulièrement pour prendre en compte et suivre l’évolution des événements culturels, politiques et autres.

#2. Limiter les résultats ou les réponses

En tant qu’utilisateur, vous pouvez limiter le nombre de réponses potentielles qu’un outil d’IA peut générer en lui donnant une instruction spécifique sur le type de réponse que vous souhaitez.

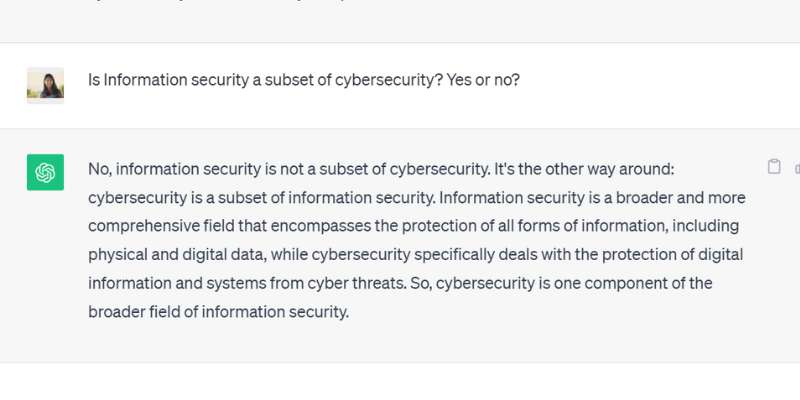

Par exemple, vous pouvez poser une question précise et ordonner au modèle de répondre uniquement par oui ou par non. Vous pouvez également proposer plusieurs choix à l’outil, ce qui limite ses possibilités de s’écarter de la réponse réelle et d’avoir des hallucinations.

Lorsque j’ai posé à ChatGPT GPT 3.5 une question avec un oui ou un non, il a généré avec précision la sortie suivante :

#3. Enrichissez le modèle avec des données pertinentes

Vous ne pouvez pas attendre d’un être humain qu’il fournisse une solution à un problème ou à une question particulière sans connaissances préalables ou sans fournir un contexte spécifique. De même, la qualité d’un modèle d’intelligence artificielle dépend de l’ensemble des données d’entraînement que vous lui avez fournies.

En ajoutant aux données de formation d’un modèle d’intelligence artificielle des données et des informations pertinentes et spécifiques à l’industrie, vous fournissez au modèle un contexte et des points de données supplémentaires. Ce contexte supplémentaire aide le modèle d’IA à améliorer sa compréhension, ce qui lui permet de générer des réponses précises, sensées et contextuelles au lieu de réponses hallucinées.

#4. Créez des modèles de données à suivre pour le modèle d’IA

Fournir un modèle de données ou un exemple de formule ou de calcul spécifique dans un format prédéfini peut grandement aider le modèle d’IA à générer des réponses précises, conformes aux lignes directrices prescrites.

Le fait de s’appuyer sur des lignes directrices et des modèles de données réduit la probabilité d’hallucinations de la part des modèles d’IA et garantit la cohérence et la précision des réponses générées. Ainsi, la fourniture d’un modèle de référence sous la forme d’un tableau ou d’un exemple peut réellement guider le modèle d’IA dans ses calculs, éliminant ainsi les cas d’hallucination.

#5. Soyez très précis dans votre demande en attribuant au modèle un rôle particulier

L’attribution de rôles spécifiques au modèle d’IA est l’un des moyens les plus brillants et les plus efficaces de prévenir les hallucinations. Par exemple, vous pouvez proposer des invites telles que “Vous êtes un guitariste expérimenté et compétent” ou “Vous êtes un mathématicien brillant”, suivies de votre question particulière.

En attribuant des rôles, vous guidez le modèle pour qu’il fournisse la réponse que vous souhaitez et non des réponses hallucinées inventées.

Et ne vous inquiétez pas. Vous pouvez toujours vous amuser avec l’IA (sans vous soucier des hallucinations). Découvrez comment créer vous-même des spirales d’IA virales!

#6. Testez la température

La température joue un rôle essentiel dans la détermination du degré d’hallucinations ou de réponses créatives qu’un modèle d’IA peut générer.

Alors qu’une température plus basse signifie généralement des résultats déterministes ou prévisibles, une température plus élevée signifie que le modèle d’IA est plus susceptible de générer des réponses aléatoires et des hallucinations.

Plusieurs entreprises d’IA fournissent une barre ou un curseur de “température” avec leurs outils afin que les utilisateurs puissent ajuster les paramètres de température à leur convenance.

Parallèlement, les entreprises peuvent également définir une température par défaut, ce qui permet à l’outil de générer des réponses sensées et de trouver un juste équilibre entre précision et créativité.

#7. Vérifiez toujours

Enfin, il n’est pas judicieux de se fier à 100 % à un résultat généré par l’IA sans procéder à une double vérification ou à une vérification des faits.

Bien que les entreprises et les chercheurs en IA résolvent le problème de l’hallucination et développent des modèles qui préviennent ce problème, en tant qu’utilisateur, il est crucial de vérifier les réponses générées par un modèle d’IA avant de l’utiliser ou d’y croire complètement.

Ainsi, en plus d’utiliser les meilleures pratiques mentionnées ci-dessus, de la rédaction de votre invite avec des spécifications à l’ajout d’exemples dans votre invite pour guider l’IA, vous devez toujours vérifier et contre-vérifier les résultats générés par un modèle d’IA.

Pouvez-vous corriger ou supprimer complètement les hallucinations de l’IA ? L’avis d’un expert

Bien que le contrôle des hallucinations de l’IA dépende de l’invite que nous lui fournissons, il arrive que le modèle génère des résultats avec une telle confiance qu’il est difficile de discerner ce qui est faux de ce qui est vrai.

En fin de compte, est-il possible de corriger ou d’empêcher complètement les hallucinations de l’IA ?

À cette question, Suresh Venkatasubramanian, professeur à l’université Brown, a répondu que la question de savoir s’il est possible ou non d’empêcher les hallucinations de l’IA fait l’objet d’une “recherche active ”

La raison en est la nature de ces modèles d’IA, à savoir leur complexité, leur complexité et leur fragilité. Même un petit changement dans les données d’entrée peut modifier les résultats de manière significative.

Alors que M. Venkatasubramanian considère la résolution du problème des hallucinations de l’IA comme un point de recherche, Jevin West, professeur à l’université de Washington et cofondateur du Center for an Informed Public, pense que les hallucinations de l’IA ne disparaîtront jamais.

West estime qu’il est impossible de faire de la rétro-ingénierie sur les hallucinations produites par les robots d’IA ou les chatbots. Par conséquent, les hallucinations de l’IA pourraient toujours exister en tant que caractéristique intrinsèque de l’IA.

D’ailleurs, Sundar Pichai, PDG de Google, a déclaré dans une interview à CBS que tous ceux qui utilisent l’IA sont confrontés à des hallucinations, mais que personne dans l’industrie n’a encore résolu le problème des hallucinations. Presque tous les modèles d’IA sont confrontés à ce problème. Il a également affirmé et assuré que le domaine de l’IA progresserait bientôt pour ce qui est de surmonter les hallucinations de l’IA.

Parallèlement, Sam Altman, PDG d’OpenAI, fabricant de ChatGPT, s’est rendu en juin 2023 à l’Indraprastha Institute of Information Technology, à Delhi, où il a déclaré que le problème des hallucinations de l’IA serait beaucoup mieux résolu d’ici un an et demi à deux ans.

Il a ajouté que le modèle nécessiterait d’apprendre la différence entre la précision et la créativité et de savoir quand utiliser l’une ou l’autre. Vous pouvez consulter le lien YouTube de la conférence d’Altman ici.

Conclusion

L’hallucination de l’IA a fait l’objet d’une attention considérable ces dernières années et constitue un domaine de prédilection pour les entreprises et les chercheurs qui tentent de la résoudre et de la surmonter le plus tôt possible.

Bien que l’IA ait fait des progrès remarquables, elle n’est pas à l’abri des erreurs, et le problème des hallucinations de l’IA pose des défis majeurs à plusieurs personnes et industries, notamment dans les domaines de la santé, de la génération de contenu et de l’industrie automobile.

Les chercheurs font leur part du travail, mais il est également de notre responsabilité, en tant qu’utilisateurs, de fournir des invites spécifiques et précises, d’ajouter des exemples et de fournir des modèles de données afin d’obtenir des réponses valides et sensées, d’éviter de perturber les données d’entraînement du modèle d’IA et de prévenir les hallucinations.

La question de savoir si les hallucinations dues à l’IA peuvent être complètement guéries ou corrigées reste entière ; je crois personnellement qu’il y a de l’espoir et que nous pouvons continuer à utiliser les systèmes d’IA pour le bien du monde de manière responsable et sûre.