Nous faisons partie d’une bonne infrastructure de réseau, dont l’exemple est la connectivité internet à haut débit.

L’infrastructure de réseau est essentielle à la communication, à la collaboration et au commerce dans le monde moderne. Alors, continuez à vous documenter sur le sujet.

Le réseau et l’infrastructure et leur importance

L’absence d’une infrastructure de réseau robuste, fiable et sécurisée constitue un obstacle. Par exemple, avez-vous déjà été confronté à une connectivité internet lente, à des déconnexions fréquentes ou à des lenteurs dans le téléchargement de vidéos ou la diffusion en continu sur YouTube ? Tout cela est dû à une mauvaise connectivité réseau.

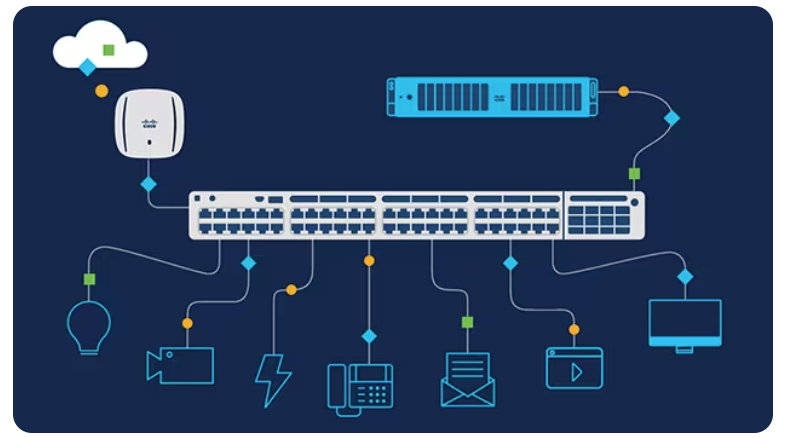

L’infrastructure réseau est essentielle à toute entreprise, quelle que soit sa taille ou son type, pour assurer une communication efficace, un partage des données et une connectivité sécurisée. Tous les dispositifs matériels, tels que les routeurs, les pare-feu, les commutateurs et les câbles, ainsi que les logiciels, tels que les systèmes d’exploitation, les protocoles et les applications de sécurité, font partie de l’infrastructure de réseau.

Tous les matériels et logiciels jouent un rôle important en permettant aux entreprises de toutes tailles de fournir un accès fiable aux services de réseau, de l’informatique en nuage aux solutions informatiques gérées, en passant par les connexions internet.

Dans le monde dynamique et en constante évolution d’aujourd’hui, une infrastructure de réseau optimisée n’est pas une option mais une nécessité pour les entreprises d’améliorer leurs capacités numériques afin d’atteindre un public beaucoup plus large, ce qui contribuerait à améliorer leur crédibilité.

L’infrastructure réseau joue un rôle essentiel dans les entreprises de toutes tailles et de tous types pour améliorer la communication et accroître la productivité. Les mesures de sécurité avancées qu’elle offre contribueront à défendre les données de l’entreprise contre les cyberattaques. La mise en œuvre de l’automatisation dans votre infrastructure de réseau contribuera à améliorer l’efficacité et l’évolutivité, ce qui permettra aux entreprises de rester compétitives pendant des années.

Une infrastructure réseau bien conçue est essentielle pour réduire les temps d’arrêt, améliorer le service à la clientèle et renforcer l’innovation afin de répondre à la demande croissante des clients. De l’amélioration de la communication et de la sécurité à l’accroissement de l’efficacité et de l’évolutivité, l’investissement dans le bon réseau peut faire une énorme différence dans la réussite future.

Toute entreprise doit investir dans une infrastructure réseau fiable pour assurer des opérations efficaces et une productivité maximale. Les réseaux robustes constituent la base de la réussite actuelle et garantissent que les entreprises sont prêtes à faire face aux changements de demain.

Comment une infrastructure de réseau robuste aide-t-elle les entreprises à mener leurs activités sans heurts ?

Des solutions de réseau conçues par des professionnels permettent aux petites et grandes entreprises de maximiser leur fiabilité opérationnelle grâce à une communication améliorée, à des mesures de sécurité robustes, à une meilleure évolutivité et à une garantie de conformité totale.

L’investissement dans une infrastructure complète aidera les entreprises à obtenir une efficacité à long terme en permettant aux employés de se connecter et de collaborer plus efficacement, où qu’ils se trouvent, et en leur donnant accès aux ressources vitales à tout moment.

Les systèmes de réseau sophistiqués offrent une protection essentielle contre les violations de données en utilisant des outils de cryptage avancés et des techniques d’authentification personnalisables adaptées aux exigences de chaque entreprise.

En outre, l’évolutivité accrue de l’architecture du réseau offre une certaine flexibilité aux entreprises en pleine croissance, leur permettant d’étendre les ressources du réseau, d’accueillir davantage d’utilisateurs et d’améliorer la capacité de stockage des données. Cela garantit des performances optimales, même pendant les périodes de pointe, alors que l’entreprise continue de croître au fil du temps.

L’intégration de nouvelles technologies telles que l’automatisation, l’apprentissage automatique, l’intelligence artificielle, l’informatique en nuage et l’IdO offre divers avantages. Ces avancées aident à réduire les coûts, à renforcer les mesures de sécurité des données, à améliorer les niveaux de satisfaction des clients et à augmenter les capacités de redondance tout en minimisant la dépendance humaine.

Une infrastructure réseau fiable est essentielle pour toute entreprise opérant dans un secteur réglementé. Elle les aide à stocker et à transmettre des données sensibles en toute sécurité, tout en respectant les réglementations. Grâce aux possibilités de travail à distance facilitées par ce système sécurisé, les entreprises ont la possibilité d’attirer des talents du monde entier, de réduire les dépenses liées à l’espace de bureau et de rester compétitives sur le marché actuel sans compromettre la sécurité ou l’efficacité.

Dans les sous-sections suivantes, nous examinerons les différents composants liés à l’infrastructure du réseau qui collaborent à la construction d’une infrastructure sûre et robuste.

VPN (réseau privé virtuel)

Un VPN (réseau privé virtuel) établit une connexion sécurisée entre votre appareil et l’internet ou le réseau, garantissant ainsi une meilleure protection de la vie privée et une plus grande sécurité des données. L’objectif principal est de s’assurer que l’ensemble de votre trafic et de vos données sont dissimulés à d’autres sources, de sorte qu’il leur est pratiquement impossible de voir et de tracer vos informations.

En utilisant la technologie du tunnel, les protocoles VPN améliorent la sécurité et le cryptage. Ils garantissent que les données peuvent traverser en privé les réseaux publics avec intégrité et authenticité, empêchant ainsi les tiers d’accéder à ces informations.

Un VPN permet de disposer d’adresses IP supplémentaires, ce qui garantit un accès sécurisé à vos données, qui sont cryptées. Il permet également d’empêcher les pirates informatiques et les agents d’espionnage de suivre vos informations et de faire de l’espionnage en ligne.

Un réseau privé virtuel (VPN) donne un sentiment de sécurité aux personnes et aux organisations qui surfent sur l’internet. Grâce à une connexion VPN, les personnes peuvent accéder à des informations sans être suivies ou surveillées.

Naviguer sur le web de manière anonyme est le meilleur soulagement qu’une connexion VPN puisse apporter. Le VPN est de plus en plus utilisé par les internautes pour préserver le secret de leurs données.

Comment fonctionne un VPN ?

Un VPN établit un tunnel sécurisé entre l’appareil de l’utilisateur et un serveur VPN distant, le connectant à la destination souhaitée. Pour ce faire, différents protocoles de tunnelage sont utilisés, notamment L2TP/IPsec, OpenVPN, PPTP (Point-to-Point Tunnelling Protocol) et Secure Socket Tunnelling Protocol (SSTP).

L2TP/IPsec, qui signifie respectivement Layer 2 Tunnelling Protocol et Internet Protocol Security, est un protocole VPN largement utilisé. L2TP agit comme un protocole de tunnelisation qui établit une connexion sécurisée entre votre appareil et le serveur VPN. Quant à IPsec, il s’agit d’un protocole de cryptage spécialement conçu pour crypter le trafic transmis par le tunnel L2TP.

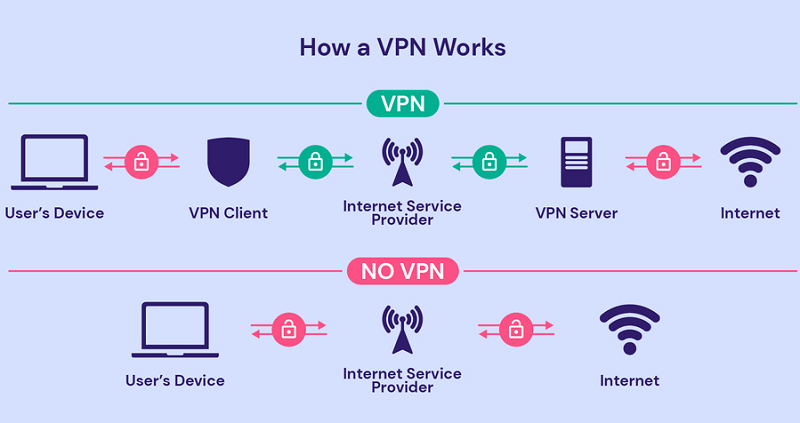

Le flux de données entre l’appareil de l’utilisateur et la destination passe par le VPN, comme le montre l’image ci-dessous. L’image illustre et simplifie efficacement la compréhension du trafic et du mouvement des données.

Voyons comment la communication s’effectue à travers le VPN :

- Le client VPN doit être installé sur l’appareil de l’utilisateur.

- L’appareil de l’utilisateur se connecte au serveur VPN, qui dissimule son adresse IP et lui en attribue une nouvelle (IPsec) afin de garantir la confidentialité et la sécurité en ligne.

- Le protocole IPsec crypte le trafic de votre appareil avant de l’envoyer au serveur VPN.

- Une fois qu’il atteint le serveur de destination, le trafic est décrypté et transmis au site web ou au service auquel vous souhaitez accéder.

- Après avoir reçu la réponse de la source, le serveur VPN la crypte et l’envoie à votre appareil. Elle est ensuite décryptée et affichée.

En combinant les protocoles L2TP et IPsec, vous pouvez établir une connexion sécurisée entre votre appareil et la destination. Le serveur L2TP crée un tunnel crypté pour que le trafic passe en toute sécurité, tandis que le protocole IPsec le crypte.

Pour garantir que l’accès n’est pas compromis en cas de déconnexion des connexions VPN, la plupart des fournisseurs proposent une technologie “kill switch” qui bloque l’activité internet jusqu’à ce que la reconnexion soit établie, offrant ainsi une protection supplémentaire contre les pirates informatiques qui tentent d’intercepter les paquets de données.

Avantages de l’adoption d’un VPN

Un VPN est simplement un service dans lequel votre propre trafic internet est crypté et acheminé via un serveur situé quelque part dans un endroit presque totalement éloigné. Cela vous donne l’impression de surfer depuis l’endroit même où se trouve le serveur.

Voici les avantages de l’utilisation d’un VPN :

- Vous pouvez protéger votre vie privée en ligne en cachant votre adresse IP et en cryptant vos transferts de données. Il devient moins pratique pour les sites web et les annonceurs de suivre les mouvements en ligne d’une personne.

- Vous pouvez également utiliser un VPN pour renforcer votre sécurité en ligne grâce au cryptage du trafic envoyé et reçu, vous protégeant ainsi de tout type de logiciel malveillant, entre autres cyberattaques.

- Un VPN vous rendra anonyme, c’est-à-dire qu’il cachera votre adresse IP ainsi que votre localisation. Cela s’avère très utile pour contourner la censure ou accéder à des contenus géo-bloqués.

- L’expérience du streaming peut être meilleure avec un VPN si l’étranglement et le géo-blocage sont évités.

- Un VPN peut certainement aider à partager des fichiers de manière anonyme, mais surtout en toute sécurité.

Types de VPN

Il existe de nombreux types de VPN, chacun présentant ses propres avantages et inconvénients.

Les types de VPN les plus courants sont les suivants :

- LesVPN personnels sont destinés aux utilisateurs individuels et s’accompagnent d’une configuration facile et de niveaux de sécurité et de confidentialité améliorés.

- Un VPN mobile possède des caractéristiques de sécurité identiques à celles d’un VPN personnel. Cependant, il est conçu spécifiquement pour les utilisateurs de smartphones ou de tablettes. Cette optimisation leur permet de bénéficier de connexions plus rapides et d’une qualité de signal supérieure, même dans les zones où la réception est plus faible.

- LesVPN d’accès à distance offrent aux employés des connexions sécurisées et privées au réseau de leur entreprise, qu’ils travaillent à domicile ou qu’ils soient en déplacement. Cette solution pratique leur permet de récupérer des fichiers et d’accéder aux applications nécessaires à leur travail en toute sécurité.

- LesVPN de site à site constituent une méthode sûre et efficace pour connecter plusieurs réseaux, y compris différents bureaux, ou pour relier le réseau d’une entreprise à un serveur en nuage. La transmission des données reste ainsi protégée tout au long de la connexion.

- Lesserveurs virtuels dédiés (VDS ) offrent des performances et une sécurité accrues par rapport aux serveurs partagés. En outre, ils offrent les avantages supplémentaires de l’évolutivité, de la rentabilité et de la fiabilité. Les SDV constituent donc un excellent choix pour les personnes qui souhaitent bénéficier d’une expérience en ligne de haut niveau sans compromettre la vitesse ou la confidentialité.

Lisez aussi : Comment tester la vitesse de votre VPN

Cas d’utilisation des VPN

Un VPN est un service de cryptage offrant une sécurité accrue pour le trafic en ligne. Il le redirige efficacement vers un serveur situé ailleurs, ce qui donne l’impression de naviguer depuis cette zone géographique, permet d’accéder à des sites/services bloqués et assure l’anonymat lors de l’accès à des réseaux Wi-Fi publics vulnérables.

Voici quelques-unes des applications les plus courantes des VPN :

- L’utilisation d’un VPN pour le travail à distance permet aux individus de se connecter en toute sécurité au réseau de leur entreprise, quel que soit l’endroit où ils se trouvent. Cette solution remarquable offre la liberté de travailler depuis le confort de son domicile ou même en explorant des contrées lointaines, tout en protégeant des informations précieuses et en garantissant des mesures de sécurité optimales.

- Les passionnés de jeux peuvent améliorer leur expérience de jeu en utilisant un VPN. Le VPN minimise le décalage et améliore les temps de réponse en dirigeant le trafic internet vers un serveur plus proche du serveur de jeu. Ce routage optimisé réduit les délais et garantit un jeu plus fluide pour les joueurs passionnés.

- Les réseaux Wi-Fi publics ne sont pas sûrs. Pour protéger vos informations personnelles et professionnelles lorsque vous accédez à un réseau Wi-Fi public, le VPN crypte votre activité en ligne et dissimule votre adresse IP, renforçant ainsi la sécurité de vos données personnelles.

- Le VPN vous permet d’accéder à des contenus bloqués ou de contourner la censure mise en place par certains gouvernements ou organisations. Le VPN permet d’accéder à des sites web et à des contenus non restreints, tels que les émissions de Netflix ou d’autres plateformes de médias sociaux dont l’accès est limité à leur pays.

- Un VPN offre des avantages en matière de sécurité et de protection de la vie privée. Le cryptage de votre trafic et la dissimulation de votre adresse IP vous protègent des menaces potentielles. Les pirates informatiques ont du mal à surveiller vos activités en ligne ou à accéder à vos données personnelles grâce à cette couche protectrice.

Meilleures pratiques

Voici quelques bonnes pratiques à suivre lors de l’utilisation d’un VPN qui vous aideront à vous assurer que vous utilisez un VPN en toute sécurité :

- Choisissez un fournisseur de services VPN qui a fait ses preuves : Le marché est inondé de nombreux fournisseurs de VPN, essayez donc de choisir celui qui a une bonne réputation et qui a fait ses preuves.

- Lorsque vous vous inscrivez à un VPN, il est important de prendre le temps de lire attentivement les conditions d’utilisation. Vous éviterez ainsi que vos données soient collectées par des tiers ou vendues sans votre consentement.

- Assurez-vous que des protocoles de cryptage solides sont utilisés et que votre fournisseur de VPN publie régulièrement des mises à jour de sécurité afin de vous protéger contre les dernières menaces.

- Ne vous connectez toujours qu’à des serveurs de confiance avant de désactiver le tunneling fractionné, car cela vous permettra de sécuriser tout le trafic entrant via une connexion à un réseau privé virtuel.

- Utilisez un “kill switch” pour vous déconnecter instantanément d’internet en cas d’interruption de la connexion.

- Changez tous les mots de passe associés aux comptes importants pour une sécurité accrue contre le vol potentiel de données avant de commencer à utiliser un VPN.

- Faites également attention au type de données utilisateur qui sont stockées ou enregistrées par vos fournisseurs de VPN.

Lisez aussi : Ce dont vous devez vous méfier avant d’utiliser un VPN

Les meilleurs fournisseurs de VPN

#1. NordVPN

Ses solutions VPN sont admirées par des experts très bien notés ainsi que par les utilisateurs. NordVPN fournit de puissantes protections grâce à ses serveurs VPN doubles qui cryptent vos données deux fois tout en changeant l’adresse IP pour maintenir l’anonymat.

Il fournit également une utilisation illimitée des données à travers des milliers de serveurs VPN mondiaux et prend en charge plusieurs appareils simultanément, tels que Windows, macOS, Linux, iOS et Android. Il offre une généreuse garantie de remboursement de 30 jours.

#2. Ivacy VPN

Ivacy est un service en ligne expérimenté qui fournit des solutions VPN pour protéger votre identité numérique contre les cybermenaces. Il met l’accent sur la vulnérabilité d’Internet et les risques qui y sont associés, protégeant ainsi les intérêts des utilisateurs dans un environnement sécurisé. Il sécurise même les utilisateurs lorsqu’ils accèdent à des contenus étrangers depuis n’importe où dans le monde en contournant les restrictions géographiques.

En outre, ils peuvent diffuser des contenus géo-restreints à partir de différents services de streaming tels que Netflix, BBC iPlayer, Disney, Hulu, et bien d’autres encore, en quelques clics de souris.

Si vous cherchez un moyen sûr et privé de naviguer sur internet, un VPN est une excellente option. Il existe de nombreux fournisseurs de VPN, ce qui vous permet de choisir celui qui correspond à vos besoins et à votre budget.

Système de noms de domaine (DNS)

Le DNS (Domain Name System) est un système de dénomination hiérarchique qui traduit les noms de domaine lisibles par l’homme, tels que www.geekflare.com/fr, en adresses IP (Internet Protocol) lisibles par la machine, telles que 52.95.120.67. L’adresse IP est le moyen par lequel les ordinateurs se connectent et communiquent.

Les ordinateurs communiquent par des nombres, c’est pourquoi le DNS traduit les noms de sites web lisibles par l’homme en nombres lisibles par l’ordinateur, appelés adresses IP, afin que les ordinateurs puissent communiquer entre eux sur l’internet ou le réseau.

Le DNS, également appelé annuaire téléphonique de l’internet, est un élément essentiel de la navigation sur le web. Il traduit les noms de domaine en adresses IP (Internet Protocol) et les stocke dans sa table ou son enregistrement à des fins de mappage, ce qui permet aux sites web de se charger rapidement lorsque vous les avez déjà visités.

Toutefois, lorsque vous visitez de nouveaux sites, le DNS doit résoudre le nom de domaine en adresse IP avant de pouvoir l’ouvrir dans votre navigateur, ce qui ralentit les temps de chargement par rapport aux visites précédentes.

En bref, le DNS évite aux humains de devoir se souvenir de nombres compliqués comme 52.95.120.67 lorsqu’ils naviguent sur des sites web sur leurs appareils.

Le DNS est un élément essentiel du fonctionnement de l’internet. Sans DNS, les personnes seraient obligées de se souvenir de longues séquences numériques pour accéder aux sites web.

Lorsque vous saisissez un nom de domaine (site web) tel que www.google.com ou www.geekflare.com/fr dans votre navigateur, l’ordinateur envoie une requête à un serveur DNS. Le serveur DNS recherche alors dans ses enregistrements l’adresse IP correspondante liée à ce nom de domaine et la renvoie à l’ordinateur, qui atteint alors le site web de destination à l’aide d’une adresse IP.

Comment le DNS contribue-t-il à la résolution des noms ?

Dans cette section, nous allons voir comment le DNS résout les noms de domaine par étapes.

Supposons que vous saisissiez un nom de domaine dans votre navigateur, par exemple www.geekflare.com/fr, et que votre ordinateur envoie une demande à un serveur DNS spécifique. Le serveur DNS recherche d’abord l’adresse IP dans son cache, mais s’il ne connaît pas cette adresse IP particulière, il la transmet à un autre serveur DNS. Ce processus se poursuit jusqu’à ce que le DNS trouve ou identifie l’adresse IP de ce nom de domaine.

Une fois qu’il a trouvé l’adresse IP correspondant à ce nom de domaine, il envoie une réponse à votre système. Votre ordinateur de surf utilisera cette adresse IP pour se connecter à www.geekflare.com/fr.

L’architecture DNS est hiérarchique : différents ensembles de serveurs DNS se chargent de différentes parties du processus de résolution des noms de domaine.

Voici les étapes de la résolution de noms DNS :

- L’utilisateur saisit un nom de domaine dans son navigateur.

- Le navigateur envoie une demande à un résolveur DNS.

- Le résolveur DNS interroge les serveurs de noms racine.

- Les serveurs de noms racine renvoient les adresses des serveurs de noms de domaines de premier niveau (TLD).

- Le résolveur DNS interroge les serveurs de noms TLD.

- Les serveurs de noms TLD renvoient les adresses des serveurs de noms faisant autorité pour le nom de domaine.

- Le résolveur DNS interroge les serveurs de noms faisant autorité.

- Les serveurs de noms faisant autorité renvoient l’adresse IP du site web.

- Le navigateur utilise l’adresse IP pour se connecter au site web.

La résolution des noms DNS est une procédure complexe, mais elle constitue un élément important de la communication sur l’internet. La connaissance du fonctionnement du DNS permet aux professionnels de l’informatique de comprendre le fonctionnement de l’internet et donc de résoudre les problèmes liés à la connectivité.

Lisez aussi : Principaux avantages de l’utilisation du filtrage DNS pour les entreprises

Qu’est-ce qu’un enregistrement DNS ?

Les enregistrements de domaine sont les instructions utilisées par les serveurs DNS pour résoudre les noms de domaine. Les enregistrements sont stockés dans une structure hiérarchique où chaque nom de domaine stocke un certain nombre d’entrées. Les enregistrements des TLD (domaines de premier niveau) constituent le niveau le plus élevé et sont stockés dans les serveurs racine et dirigés vers les serveurs de noms pour les niveaux suivants.

En d’autres termes, les enregistrements servent à faire correspondre les noms de domaine à la bonne adresse IP, ce qui permet de diriger le trafic sur le site. Les enregistrements DNS permettent également de spécifier les serveurs de messagerie liés à un nom de domaine particulier et autorisent les alias ou les redirections d’une adresse à une autre.

Vous trouverez ci-dessous les enregistrements DNS les plus importants et leurs fonctions :

- A : Associe un nom de domaine à une adresse IP et dirige le trafic web vers le site web approprié.

- AAAA : Il est similaire à l’enregistrement A, mais il associe un nom de domaine à une adresse IPv6. IPv6 est la version la plus récente de l’adressage IP.

- CNAME: Associe un nom de domaine à un autre nom de domaine. Il est utilisé pour créer des alias de sites web ou pour rediriger le trafic d’un domaine vers un autre.

- MX: Il spécifie les serveurs de messagerie pour un domaine. Les clients de messagerie l’utilisent pour envoyer et recevoir des courriels pour le domaine.

- NS: Cet enregistrement répertorie les serveurs de noms d’un domaine. Les serveurs de noms sont responsables du stockage et de la mise à jour des enregistrements DNS pour un domaine.

Problèmes DNS courants et conseils de dépannage

Dans cette section, nous allons examiner quelques-uns des problèmes DNS les plus courants rencontrés par les utilisateurs et la manière de les résoudre.

Problèmes courants

- Pas de réponse du serveur DNS : Il s’agit de l’un des problèmes de DNS les plus fréquents auxquels sont confrontés les utilisateurs. Les raisons de ce problème peuvent être diverses, comme une mauvaise configuration du serveur DNS à diverses occasions, une panne de réseau ou même une coupure de courant. Lorsqu’un tel événement se produit, l’utilisateur ne peut ni naviguer ni accéder à un site web.

- Empoisonnement du cache DNS: Dans ce cas, les attaquants injectent des informations DNS erronées dans la zone de cache d’un serveur DNS. Les utilisateurs sont alors dirigés vers d’autres sites web malveillants.

- Lenteur des recherches DNS: La lenteur des recherches DNS peut être due à de nombreux facteurs, tels que la distance entre vous et le serveur DNS, la charge du serveur DNS ou la lenteur du résolveur. Dans tous ces cas, vous ne pourrez pas vous connecter au site web visé.

- Pas de résolution de nom de domaine : Si les enregistrements DNS du domaine sont incorrects, cela peut entraîner des problèmes tels que l’impossibilité d’accéder à un domaine, l’impossibilité de communiquer ou de recevoir des courriels par le biais de communications, etc.

Lisez aussi : Comment configurer la mise en cache DNS à l’aide de dnsmasq sur Ubuntu

Passons en revue quelques étapes courantes de dépannage et de résolution des problèmes DNS :

Si vous êtes confronté à un problème de connectivité DNS ou à des problèmes déclarés, vous pouvez commencer par suivre les étapes de base ci-dessous pour vérifier le problème de connectivité :

1️⃣ Connexion internet lente/non connectée

Dans ce cas, il n’y aura pas de résolution de nom de domaine. Vérifiez donc les câbles de connectivité, redémarrez le routeur, recherchez les logiciels malveillants, etc. Vérifiez également si un site web est en cours d’exécution.

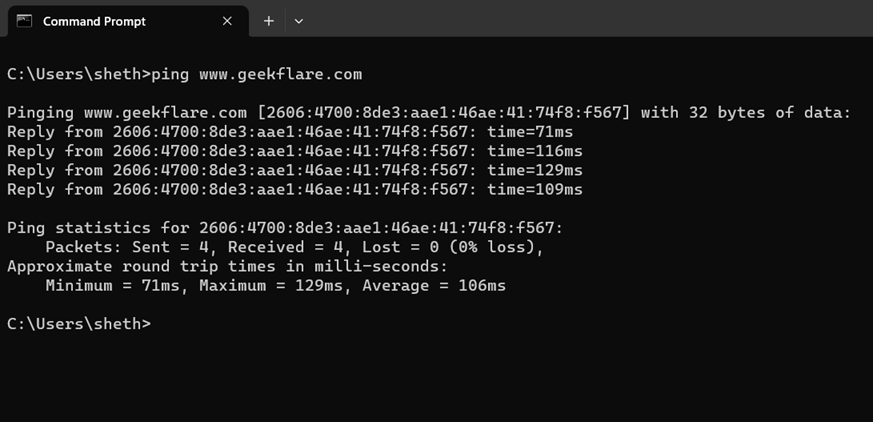

Par exemple, tapez ping à l’invite de commande et le nom du domaine ou du site web pour lequel vous rencontrez des problèmes, comme indiqué ci-dessous.

Ping www.geekflare.com/frSi le site web est en ligne, vous obtiendrez une réponse. Si la commande ping ne donne pas de réponse, il est fort probable que le problème se situe du côté du site web.

Une autre solution consiste à vérifier le serveur DNS :

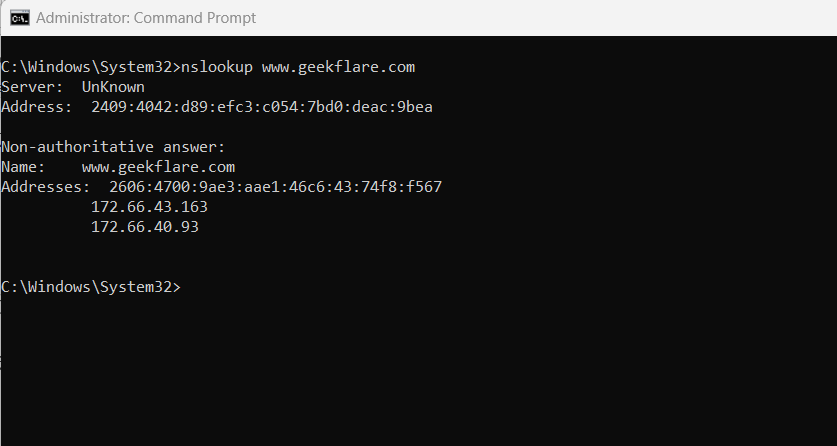

Si votre serveur DNS est lent ou surchargé, les recherches DNS (résolution de noms) peuvent être lentes ou inexistantes. L’un des moyens les plus simples de vérifier est d’utiliser la commande Name Server Lookup (nslookup).

Cette commande interroge les serveurs de noms de domaine et obtient les détails. Si vous obtenez une réponse, le serveur DNS fonctionne correctement.

nslookup www.geekflare.com/frLe résultat de cette commande est indiqué ci-dessous :

2️⃣ Mise à jour des enregistrements DNS

Le DNS conserve les enregistrements des adresses IP correspondant à des sites web populaires, mais il est fort probable que ce cache soit la cible d’attaques malveillantes, entraînant une lenteur, une absence de réponse ou une redirection vers d’autres sites web. Dans certains cas, il est également possible que les adresses IP soient corrompues ou mal mappées.

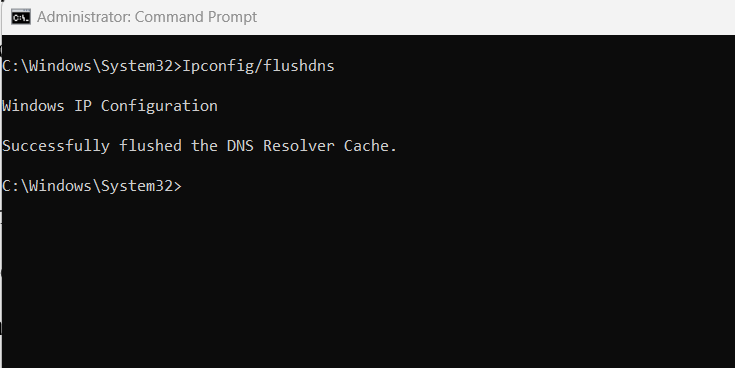

Pour résoudre ces problèmes, le meilleur moyen est d’effacer ou de vider le cache DNS sur le serveur DNS, comme indiqué ci-dessous :

Exécutez la commande suivante à partir de la ligne de commande :

dnscmd [] /clearcacheCette commande effacera le cache du serveur DNS et en créera un nouveau au fur et à mesure qu’il recevra de nouvelles requêtes.

De même, le cache DNS est également disponible sur un système client.

Pour vider le cache DNS sur un système client, vous pouvez exécuter la commande suivante à partir de la ligne de commande :

Ipconfig/flushdnsUne fois la commande exécutée avec succès, vous obtiendrez l’état indiqué ci-dessous :

Dans le même temps, il existe également une probabilité de problèmes d’attribution d’adresses IP dynamiques et de mauvaise configuration du serveur DNS sur votre poste de travail. Cela entraînera également des problèmes de connectivité avec le site web destinataire.

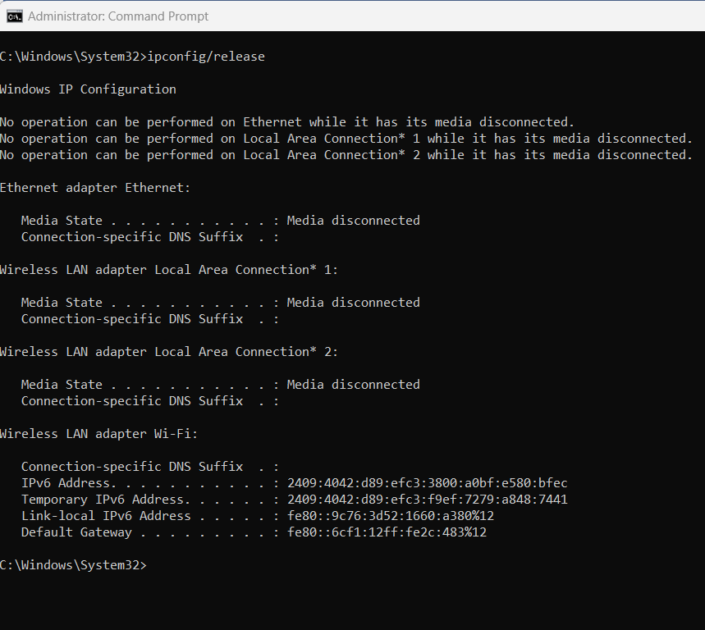

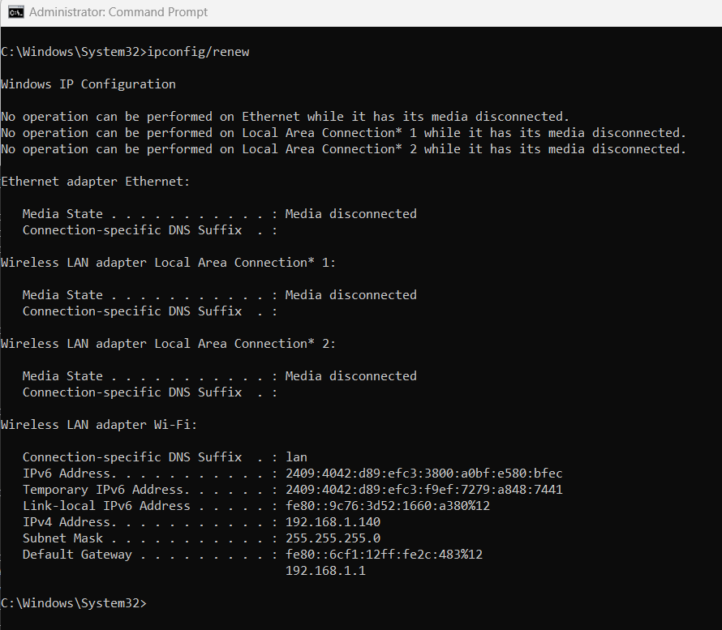

Pour résoudre ce problème, vous pouvez exécuter des commandes pour libérer et renouveler l’adresse IP, le masque de sous-réseau, la passerelle par défaut et les paramètres du serveur DNS sur votre ordinateur de bureau :

Vous pouvez exécuter les commandes suivantes à partir de la ligne de commande de votre système :

Ipconfig/releaseCette commande libérera ou effacera tous vos paramètres IP existants sur votre système local.

Ensuite, vous pouvez exécuter la commande renew à partir de la ligne de commande comme suit :

Ipconfig/renewElle renouvellera et attribuera toutes les nouvelles adresses IP, la passerelle par défaut, les paramètres DNS et les informations connexes à votre système.

3️⃣ Modifier les paramètres DNS

Dans certains cas, il est possible que le DNS alloué dynamiquement ne fonctionne pas comme prévu. Dans ce cas, vous pouvez allouer un serveur DNS manuel.

Vous pouvez modifier les paramètres DNS pour les serveurs DNS publics, et les options standard sont les suivantes :

Adresse Google primaire : 8.8.8.8

Adresse secondaire : 8.8.4.4

OU

Adresse primaire de Cloudflare : 1.1.1.1

Adresse secondaire : 1.0.0.1

Ces outils sont disponibles gratuitement.

Si vous cherchez d’autres outils pour dépanner le DNS, vous pouvez jeter un coup d’œil au dépannage de la santé du DNS.

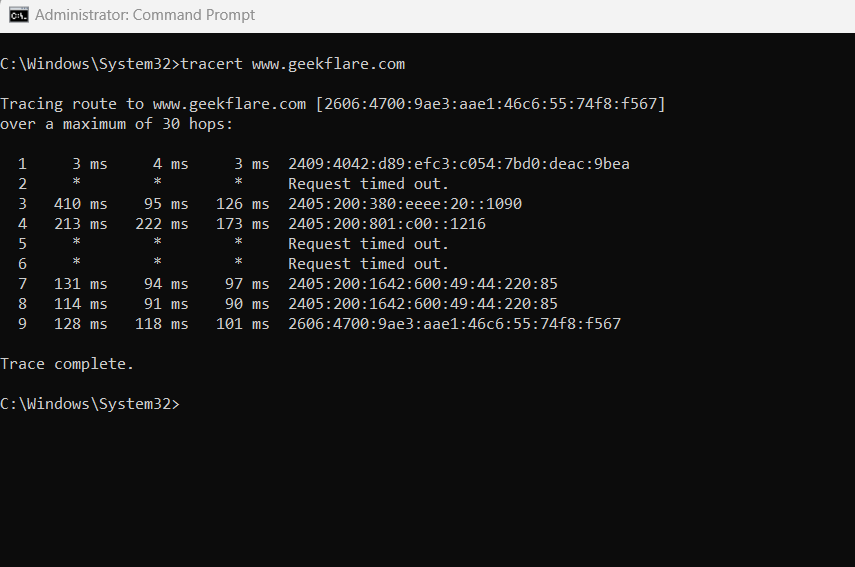

4️⃣ Vérification du chemin d’accès au réseau

Lors du dépannage des problèmes de DNS et de connectivité, il est important de savoir où les paquets de données se sont arrêtés sur le réseau.

Pour identifier les paquets de données interrompus entre votre système et le site web de destination, vous pouvez utiliser l’outil de ligne de commande Tracert.

Exécutez la commande Tracert nom du site web. Vous pouvez jeter un coup d’œil à l’image ci-dessous, dans laquelle vous pouvez voir les traces de connectivité vers le site web www.geekflare.com/fr.

Tracert www.geekflare.com/fr

Cette commande permet de suivre le chemin d’un paquet depuis votre ordinateur jusqu’à un serveur distant. Cela peut être utile pour dépanner les problèmes de DNS si vous pensez qu’il y a un problème avec l’infrastructure du réseau. Pour plus d’informations sur l’utilisation et l’analyse de cette commande, vous pouvez consulter le site de Microsoft.

Enfin, vous avez la possibilité de contacter votre fournisseur d’accès à Internet (FAI) pour l’informer de la lenteur de votre connexion Internet. Le FAI peut vous aider à résoudre le problème ou vous fournir un autre serveur DNS à utiliser.

Sécurité du réseau

La sécurité des réseaux est devenue vitale pour les organisations de tous secteurs et de toutes tailles. Elle garantit la protection d’informations précieuses contre les accès non autorisés, les attaques de virus, l’usurpation d’identité ou toute perturbation susceptible de nuire à l’efficacité opérationnelle.

La sécurité des réseaux remplit plusieurs fonctions essentielles. Elle protège les données sensibles, atténue les pertes financières, assure la conformité réglementaire des entreprises et prévient les attaques de ransomware et le vol de données, entre autres aspects importants.

L’utilisation généralisée de l’internet par les particuliers et les organisations, associée à l’adaptation rapide de la technologie numérique, expose presque tout le monde à une gamme variée de cybermenaces. En outre, les progrès de l’intelligence artificielle (IA) ont accru le niveau de sophistication de ces attaques.

Dans cette ère numérique en constante évolution, il est primordial d’assurer la sécurité. Pour y parvenir, les organisations doivent mettre en œuvre des mesures de protection de la sécurité du réseau, des politiques robustes et une infrastructure réseau sécurisée, en plus d’une authentification multifactorielle et d’audits de sécurité réguliers. Ces mesures proactives minimisent les risques et sécurisent les données précieuses.

Selon le rapport, les violations de données ont un coût moyen d’environ 4,35 millions de dollars américains dans le monde. Ces violations sont répandues dans divers secteurs, notamment les soins de santé, la finance, les produits pharmaceutiques, la technologie, l’énergie, les services et les domaines industriels.

La mise en œuvre de mesures complètes de sécurité des réseaux protège les informations confidentielles contre les accès non autorisés ou les écoutes clandestines. Cela garantit la protection des données financières, des dossiers personnels et de la précieuse propriété intellectuelle, permettant aux entreprises de respecter la conformité tout en assurant la sécurité des données des clients et en préservant l’intégrité opérationnelle.

Dans les sous-sections suivantes, nous verrons les différents types de menaces réseau, les mesures préventives et les meilleures pratiques.

Types de menaces pour la sécurité des réseaux et méthodes de prévention

Voyons les différentes menaces qui pèsent sur la sécurité des réseaux et les méthodes permettant de protéger vos données et votre infrastructure contre ces menaces.

Parmi les menaces réseau les plus répandues, citons les logiciels malveillants, l’hameçonnage, les attaques par déni de service (DDoS), l’usurpation d’identité, le vol de données, les attaques par ransomware et les violations de droits d’auteur.

Examinez quelques-unes des menaces réseau les plus courantes et les méthodes de prévention.

1️⃣ Logiciels malveillants (malware) : Les logiciels malveillants sont des logiciels destinés à endommager ou à attaquer un système informatique et à voler des données personnelles et sensibles. Il peut être installé sur un système en cliquant sur un lien malveillant, en ouvrant une pièce jointe infectée ou en téléchargeant un fichier à partir d’une source non fiable.

Il existe de nombreux types de logiciels malveillants ; les plus courants sont les virus, les vers, les chevaux de Troie, les rançongiciels et les logiciels espions.

- Mesures préventives : Comme il est très probable que des logiciels malveillants pénètrent dans votre système par le biais de liens suspects, évitez d’ouvrir ou de cliquer sur les liens reçus de ressources inconnues. Faites attention à l’utilisation des réseaux Wi-Fi publics ; si vous souhaitez les utiliser, préférez un VPN pour protéger vos données.

- Un antivirus et un pare-feu robustes jouent également un rôle important dans la protection de votre système contre les logiciels malveillants.

- Phishing (hameçonnage) : Le phishing est une attaque sociale sur diverses plateformes sociales où l’attaquant envoie un message frauduleux au destinataire pour qu’il révèle des informations personnelles, telles que des mots de passe, des numéros de carte de crédit ou d’autres données sensibles. Les courriels d’hameçonnage, comme ceux des banques ou des sociétés de cartes de crédit, semblent souvent provenir de sources légitimes. L’hameçonnage se produit principalement par le biais de courriels, de textes mobiles, d’appels téléphoniques, etc.

- Mesures préventives : Prenez des précautions lorsque vous répondez à un courriel, un appel téléphonique ou un message texte inconnu. Soyez prudent lorsque vous ouvrez les liens et les pièces jointes présents dans l’e-mail. Évitez strictement de partager en ligne vos informations personnelles, telles que vos mots de passe, les détails de vos cartes, etc.

Pour éviter les attaques de logiciels malveillants et les tentatives d’hameçonnage, activez l’authentification à deux facteurs (2FA), utilisez des mots de passe forts et tenez-vous au courant des dernières tentatives d’hameçonnage. L’adoption de dispositifs sécurisés tels que les pare-feu et les logiciels antivirus vous aidera à rester en sécurité.

Lisez aussi : Services en ligne pour supprimer les logiciels malveillants et nettoyer les sites web piratés

2️⃣ Déni de service distribué (DDoS) : Comme son nom l’indique, cette cyberattaque empêche les utilisateurs légitimes d’accéder aux sites web et aux services. Ces attaques se produisent généralement sous forme d’attaques volumétriques, dans lesquelles les ressources du serveur sont bloquées par l’envoi de nombreuses requêtes, telles que des paquets HTTP ou SYN.

La seconde est l’attaque par protocole, qui consiste à exploiter les vulnérabilités du protocole. Dans les deux cas, ces attaques se sont avérées très efficaces pour perturber le service si elles ne sont pas protégées de manière sûre.

Il existe différents types d’attaques DDoS, dont les principaux sont les suivants :

- Lesréseaux de zombies: L’attaquant utilise un botnet, un réseau d’ordinateurs infectés, pour envoyer du trafic vers l’appareil ou le réseau cible.

- Attaques par la foule: Dans ce type d’attaques, des personnes sont utilisées pour envoyer du trafic vers la cible en les payant.

- Attaques parrainées par un État: Ces attaques sont parrainées par des gouvernements ou d’autres organisations.

Mesures préventives : Les organisations peuvent protéger leurs données et leurs ressources contre les attaques DDoS en adoptant les mesures de sécurité appropriées. Des outils et des dispositifs de sécurité tels que des pare-feu, des équilibreurs de charge, un service d’atténuation des attaques DDoS et des mises à jour logicielles régulières contribueront à prévenir les attaques DDoS.

En outre, si les employés réagissent plus rapidement à ces attaques, cela permettra d’éviter des pannes ou des catastrophes importantes, et la sensibilisation des employés à ces attaques contribuera également à les surmonter.

Comme indiqué dans les sous-sections suivantes, les entreprises doivent suivre les meilleures normes et pratiques de sécurité pour protéger leurs données et leur infrastructure des menaces qui pèsent sur le réseau.

Contrôle de l’accès au réseau et méthodes d’authentification pour prévenir les cyberattaques

L’une des principales sources de fuites ou d’espionnage concerne souvent les identifiants de connexion. Par conséquent, la mise en œuvre de méthodes d’authentification robustes pour accéder aux ressources du réseau est cruciale pour protéger votre réseau contre des perturbations importantes.

Nous allons maintenant nous pencher sur le contrôle d’accès au réseau (NAC) et ses différentes méthodes d’authentification afin de vous protéger efficacement contre les cyber-attaques.

- Contrôle d’accès au réseau (NAC) : Il s’agit d’un cadre de sécurité complet qui régule et gère les autorisations d’accès aux ressources du réseau. Ce système essentiel protège efficacement les réseaux en empêchant les entrées non autorisées et en protégeant contre les activités potentiellement dangereuses.

- Mots de passe: Ils constituent la méthode d’authentification la plus courante, mais peuvent malheureusement être facilement compromis. Microsoft suggère d’utiliser des mots de passe d’une longueur minimale de 8 caractères avec une combinaison de lettres minuscules et majuscules, de caractères spéciaux et de chiffres.

- Authentification multifactorielle (MFA): Le système MFA ajoute une couche supplémentaire de sécurité et est largement reconnu comme l’une des méthodes d’authentification les plus robustes. Il oblige les utilisateurs à fournir au moins deux facteurs pour accéder au réseau en toute sécurité.

- Biométrie: L’authentification biométrique repose sur des caractéristiques physiques telles que les empreintes digitales ou les scans faciaux pour établir et confirmer l’identité.

- Authentification par jeton: Elle utilise un jeton physique, comme un porte-clés ou une carte à puce, pour vérifier l’identité des utilisateurs. Bien qu’elle offre une sécurité accrue, elle peut parfois gêner les utilisateurs. Il n’est pas possible de mettre en œuvre une méthode d’authentification unique qui convienne à tous les types de réseaux.

Le choix de la méthode d’authentification dépend entièrement des exigences spécifiques du réseau, telles que le niveau de sécurité souhaité, les coûts de mise en œuvre et la commodité pour l’utilisateur.

En mettant en œuvre une solution NAC robuste, les entreprises peuvent empêcher efficacement les accès non autorisés et les activités malveillantes, protégeant ainsi leurs réseaux.

Mise en œuvre de politiques et de bonnes pratiques en matière de sécurité des réseaux

Il est fortement recommandé de suivre certaines bonnes pratiques et politiques de sécurité afin d’éliminer plusieurs menaces réseau, d’assurer votre sécurité et celle de votre organisation, et de veiller à ce que vos données soient protégées et ne soient pas exposées à des personnes non autorisées.

Examinons quelques-unes des meilleures politiques et pratiques de sécurité du réseau :

- Auditer la sécurité du réseau : Il s’agit de l’une des étapes les plus critiques qui doit être réalisée selon un calendrier précis. Cela permettra de mettre en évidence les failles de votre réseau afin que vous puissiez prendre des mesures immédiates pour sécuriser votre infrastructure réseau.

- Adoptez les meilleurs dispositifs de sécurité : Les meilleurs dispositifs de sécurité dans votre infrastructure vous aideront à vous protéger contre l’accès non autorisé à un réseau, à surveiller le trafic réseau pour détecter toute activité suspecte et à générer des alertes en cas d’attaques potentielles. Des dispositifs tels que les pare-feu, les systèmes de détection et de prévention des intrusions (IDS/IPS), les pare-feu pour applications web (WAF), les systèmes de prévention des pertes de données (DLP), les antivirus et les logiciels malveillants vous aideront à cet égard.

- Mettre à jour les politiques de sécurité de l’organisation en fonction des besoins. Il s’agit de l’une des étapes essentielles, car les attaques étant de plus en plus sophistiquées, les politiques de sécurité des organisations doivent être mises à jour fréquemment.

- Des outils comme le VPN jouent un rôle important dans le cryptage de vos données sensibles et la prévention des accès non autorisés. Le VPN est très utile lorsque les employés se connectent à distance à l’infrastructure de l’entreprise.

- L’utilisation de mots de passe forts est l’un des aspects les plus importants mais les plus souvent ignorés. La recommandation standard pour des mots de passe forts est d’avoir au moins 12 caractères de long et d’inclure un mélange de lettres majuscules et minuscules, de chiffres et de symboles.

- L’authentification multifactorielle (MFA) ajoute une couche de sécurité supplémentaire à votre processus de connexion en vous demandant d’entrer un code depuis votre téléphone en plus de votre mot de passe.

- Un système d’exploitation doit être mis à jour régulièrement pour bénéficier des correctifs de sécurité qui contribueront à protéger votre système/serveur contre les vulnérabilités.

- Il arrive également que des piratages, des vols de données, des compromissions de réseaux, etc. surviennent dans les entreprises, alors que toutes les mesures de sécurité ont été mises en place. Pour faire face à de telles situations, il est fortement recommandé de disposer d’un plan de reprise après sinistre, d’un plan d’intervention en cas d’incident, d’un plan de continuité des activités (BCP), etc.

- Parallèlement, la mise en place de sauvegardes régulières et la sensibilisation des employés à la cybersécurité contribueront sans aucun doute à la création d’un plan solide qui sécurisera votre réseau à tous les égards.

Lisez aussi : IDS vs IPS : Guide complet des solutions de sécurité réseau

Pare-feu

En termes simples, un pare-feu surveille et analyse le trafic/les données qui pénètrent dans votre réseau 24 heures sur 24 et empêche tout trafic qui semble suspect.

Un pare-feu est un dispositif de sécurité réseau de premier ordre et hautement préférable qui analyse, surveille et contrôle le trafic/les données qui entrent et sortent du réseau.

Conformément aux règles définies par l’organisation, un pare-feu fonctionne en examinant chaque paquet de données. Il détermine s’il faut les autoriser ou les bloquer en fonction de facteurs spécifiques tels que les adresses IP source et destination, le numéro de port et le type de trafic.

Les pare-feu jouent un rôle essentiel dans la protection des réseaux contre les accès non autorisés, les logiciels malveillants, les attaques DDoS et diverses autres cybermenaces.

Les types de pare-feu et leur fonctionnement

Il existe principalement trois types de pare-feu : Matériel, logiciel et sans état.

🔷 Pare-feu matériels

Les pare-feu matériels sont des dispositifs physiques connectés à un réseau qui servent de passerelles pour le trafic entrant et sortant. Ils offrent des performances et une sécurité accrues par rapport aux pare-feu logiciels, bien qu’ils puissent être coûteux.

Ils sont généralement placés au périmètre du réseau, servant de barrière protectrice entre le réseau interne et le monde extérieur. Ils peuvent également être déployés à la périphérie d’un réseau, par exemple pour sécuriser les communications entre une succursale et le siège de l’entreprise.

Les pare-feu matériels utilisent trois méthodes principales pour surveiller et analyser le trafic qui les traverse. Ces méthodes sont les suivantes

- Le filtrage des paquets consiste à examiner les en-têtes des paquets de données pour déterminer s’ils doivent être autorisés ou non à pénétrer dans un réseau.

- L’inspection dynamique améliore les capacités du pare-feu en tenant compte de l’état de la connexion entre deux hôtes, ce qui permet de déjouer efficacement les attaques qui exploitent les vulnérabilités du protocole TCP/IP. Cette méthode va au-delà du filtrage de paquets de base et fournit un niveau de protection plus avancé.

- Dans la méthode d’inspection de la couche application, les paquets réseau sont examinés afin de déterminer s’ils doivent être autorisés ou refusés. Cette approche est plus avancée que la méthode de pare-feu avec état.

Les pare-feu matériels offrent une sécurité, des performances et une évolutivité supérieures à celles des solutions logicielles. Ces systèmes robustes gèrent rapidement d’importants volumes de trafic tout en offrant un large éventail de fonctionnalités. Ils prennent notamment en charge les VPN, la détection des intrusions et le filtrage de contenu.

Dans l’ensemble, les pare-feu matériels sont préférables aux pare-feu logiciels pour sécuriser et protéger les réseaux, mais ils sont plus coûteux et plus complexes à gérer. Ils présentent le risque d’un point de défaillance unique en ce sens que s’ils tombent en panne, c’est l’ensemble du réseau qui peut être exposé à la vulnérabilité.

🔷 Pare-feu logiciels

Les pare-feu logiciels sont des applications logicielles installées et configurées sur un serveur. Ils visent à protéger soit un seul serveur, soit un seul réseau, tout en offrant une sécurité supplémentaire par rapport aux pare-feu matériels. En outre, les pare-feu logiciels sont rentables et simples à installer et à configurer.

Un pare-feu logiciel fonctionne au niveau de la couche application et protège contre les attaques malveillantes. Il examine avec diligence les paquets de données à la recherche de tout signe de contenu suspect et les bloque rapidement si nécessaire. Cette protection complète permet aux entreprises de se défendre contre les escroqueries par hameçonnage, les infections par logiciels malveillants, les menaces virales et d’autres cyberrisques susceptibles de compromettre leurs systèmes.

Les pare-feu logiciels utilisent également trois modes de surveillance et d’analyse du réseau, comme le font les pare-feu matériels.

🔷 Pare-feu sans état

Un pare-feu sans état est un dispositif de sécurité précieux pour les petits réseaux et ceux dont les ressources sont limitées. Il filtre efficacement le trafic réseau en utilisant des règles simples. Contrairement à son homologue avec état, il ne garde pas trace des connexions réseau et ne tient pas compte du contexte entourant les paquets. Il évalue chaque paquet de manière indépendante afin de garantir des mesures de sécurité optimales.

Les pare-feu sans état sont relativement simples à configurer, mais ils offrent moins de sécurité que les pare-feu avec état.

Lisez aussi : Qu’est-ce qu’un pare-feu avec ou sans état ?

Avantages du pare-feu

Voici quelques-uns des avantages qu’un pare-feu réseau apporte à votre réseau :

- Il améliore la visibilité en augmentant les capacités de surveillance.

- Il assure une gestion centralisée, ce qui permet une administration facile et efficace du réseau.

- Les pare-feu sont évolutifs, de sorte que le réseau peut se développer et s’adapter en fonction des besoins.

- Un pare-feu est vital car il s’agit d’un dispositif de sécurité essentiel que les entreprises ou les particuliers utilisent pour protéger leurs données et leurs réseaux contre les cybermenaces.

- Un pare-feu protège la barrière contre tout accès non autorisé, prévenant ainsi les menaces potentielles des pirates, des logiciels malveillants ou de tout autre risque cybernétique. Grâce à cette mesure de défense, votre réseau restera à l’abri de toute tentative de la part d’utilisateurs non autorisés.

- Il peut contribuer à prévenir les violations de données en bloquant l’accès non autorisé aux données sensibles.

- Un pare-feu protège contre les logiciels malveillants, notamment les virus, les vers et les chevaux de Troie. Il protège votre réseau contre ces menaces malveillantes.

- Un pare-feu joue un rôle crucial dans l’amélioration des performances du réseau en filtrant le trafic inutile, ce qui améliore l’efficacité globale.

L’accès au réseau peut être finement contrôlé grâce à la configuration du pare-feu. Ce puissant dispositif permet aux administrateurs d’accorder ou de restreindre de manière sélective l’accès à des ressources réseau spécifiques, notamment des sites web, des applications et des périphériques.

Règles de pare-feu et directives de configuration

Les règles de pare-feu comprennent des instructions permettant de gérer la sécurité du trafic réseau au sein d’un système. Ces instructions prennent en compte différents critères, tels que les adresses IP, les numéros de port et les protocoles, afin de garantir une configuration sécurisée.

Pour garantir le bon fonctionnement de ce processus, il est essentiel de suivre les meilleures pratiques lors de la configuration.

Les lignes directrices relatives à la configuration des pare-feu sont essentielles pour établir des stratégies de défense fiables contre les intrusions potentielles ou les logiciels malveillants. En outre, elles contribuent à maintenir un flux efficace du système.

Vous trouverez ci-dessous quelques-unes des règles et des directives de configuration des pare-feu les plus importantes :

- Chaque organisation doit élaborer, respecter et mettre à jour régulièrement une politique en matière de pare-feu. Cette politique consiste en un ensemble de règles qui dictent la manière dont le pare-feu gère le trafic réseau.

- Pour assurer une protection maximale, le réseau bloque tout le trafic entrant, à moins qu’il ne soit spécifiquement autorisé par les règles du pare-feu.

- Le réseau n’autorise que le trafic sortant essentiel, ce qui garantit la sauvegarde et la protection des données sensibles contre les fuites potentielles.

- Pour renforcer la sécurité du réseau et empêcher les accès non autorisés et les attaques ciblées, il est conseillé d’utiliser des adresses IP source et destination spécifiques ainsi que des numéros de port. Cette pratique permet de réguler efficacement le trafic entrant et sortant et d’atténuer les risques potentiels pour votre réseau.

- Pour garantir une sécurité optimale de votre pare-feu, il est impératif de rester informé des derniers correctifs et mises à jour de sécurité. L’application régulière de ces correctifs garantit un dispositif hautement sécurisé et permet d’adapter en permanence les règles du pare-feu en fonction des modifications de la politique du réseau et des objectifs de l’organisation.

- Les administrateurs doivent surveiller quotidiennement les journaux du pare-feu. Cette pratique leur permet d’obtenir des informations précieuses sur le trafic du réseau, facilitant ainsi l’identification de toute activité suspecte.

Applications du pare-feu dans la sécurité du réseau

Comme nous l’avons vu plus haut, les pare-feu jouent un rôle crucial dans la préservation de la sécurité en ligne. Ils y parviennent en bloquant les sites et applications malveillants, en séparant les données sensibles pour déjouer les tentatives de piratage, en conservant les journaux d’activité des utilisateurs à des fins d’audit et en appliquant des politiques de sécurité rigoureuses.

En adhérant aux meilleures pratiques et en exploitant efficacement les pare-feu, les utilisateurs peuvent protéger leurs réseaux des menaces potentielles en toute confiance.

Voici quelques-unes des applications spécifiques des pare-feu :

- Les petites entreprises peuvent utiliser les pare-feu pour se protéger des accès non autorisés à l’internet. Ces établissements sont souvent la cible de cyberattaques car ils sont considérés comme moins sûrs que les grandes organisations.

- Les réseaux domestiques peuvent bénéficier de l’utilisation de pare-feux car ils protègent les accès non autorisés à l’internet. Les réseaux domestiques se connectent souvent à l’internet par l’intermédiaire de divers dispositifs susceptibles d’être attaqués. La mise en place d’un pare-feu permet de protéger ces dispositifs vulnérables.

- Les centres de données, où sont stockées des informations critiques, doivent être protégés contre les cybercriminels. Pour protéger ces actifs précieux, les pare-feu sont largement déployés dans le périmètre du centre de données.

- Comme la plupart des entreprises passent à l’informatique en nuage, elles sont devenues plus vulnérables aux attaques ; elles adoptent donc massivement des pare-feux avancés.

- Les grandes entreprises s’appuient entièrement sur les pare-feux pour garantir la sécurité de leurs vastes systèmes de réseau et de leurs données.

Équilibreur de charge

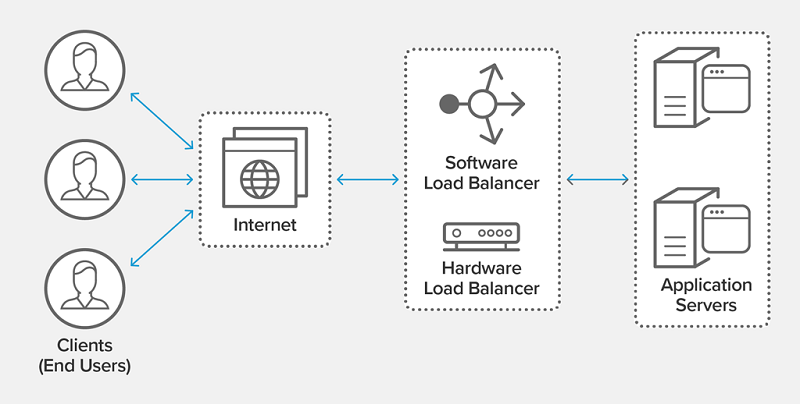

L’équilibreur de charge est un outil essentiel pour une distribution efficace du trafic. Il peut s’agir d’un dispositif matériel ou d’une application logicielle conçue pour répartir efficacement le trafic entrant entre plusieurs serveurs dorsaux. Cela permet de garantir des performances optimales et de répondre à des demandes importantes avec une efficacité sans faille.

Les répartiteurs de charge sont un élément essentiel de toute application à fort trafic. Ils contribuent à améliorer les performances, la fiabilité et la sécurité.

L’internet est devenu un outil essentiel pour la société, permettant des connexions sans précédent entre les individus. Il sert de passerelle vers une vaste gamme d’informations et de ressources à l’échelle mondiale, répondant à des besoins variés tels que le divertissement, l’éducation et les entreprises.

Le nombre d’utilisateurs n’ayant cessé de grimper en flèche au cours des deux dernières décennies, il est évident que son influence ne fera que s’étendre, favorisant la connectivité à grande échelle.

Les entreprises doivent souvent répondre à des besoins exponentiels en créant des fermes de serveurs, également connues sous le nom de pools de serveurs. Ces fermes de serveurs sont constituées de groupes de serveurs qui gèrent efficacement de gros volumes de trafic. Pour gérer efficacement ces volumes élevés, les entreprises déploient des équilibreurs de charge qui répartissent les demandes entrantes de manière uniforme sur tous les serveurs.

Ils sont devenus de plus en plus cruciaux dans l’infrastructure informatique moderne. Ils constituent des outils essentiels pour optimiser les performances des serveurs web et des serveurs d’application, tout en garantissant la fiabilité en répartissant uniformément les demandes des utilisateurs.

Les répartiteurs de charge empêchent efficacement la surcharge des ressources individuelles, garantissant ainsi un accès rapide et sans erreur aux données. Par conséquent, ils permettent d’améliorer la satisfaction des clients.

L’importance de l’équilibrage de la charge s’étend à tous les types de serveurs, depuis les serveurs web et les systèmes de base de données jusqu’aux serveurs de stockage.

L’utilisation de l’équilibrage de charge devient un aspect essentiel de toute stratégie de continuité des activités lorsque plusieurs ressources sont disponibles.

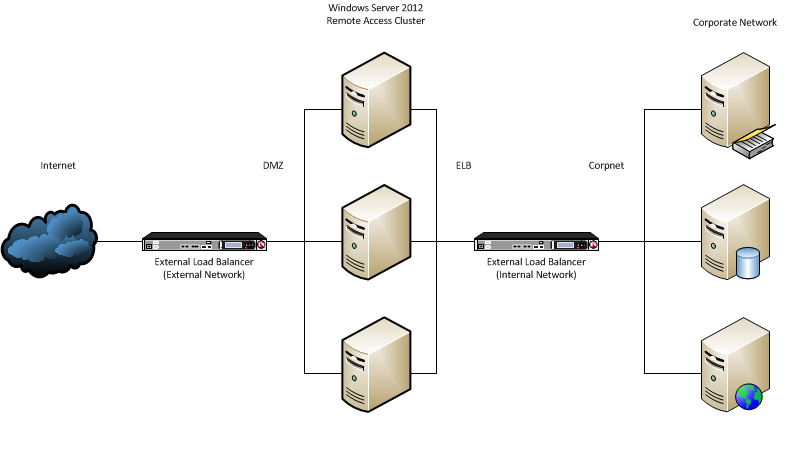

Comment fonctionne un équilibreur de charge ?

Un équilibreur de charge est indispensable aux entreprises pour gérer efficacement le trafic réseau. Il évalue rapidement des facteurs tels que la capacité, l’emplacement et les niveaux de charge. En répartissant les demandes sur plusieurs serveurs en fonction de règles prédéterminées, il améliore l’expérience de l’utilisateur et garantit des performances optimales.

Cette approche permet d’augmenter le volume avec une vitesse accrue sans compromettre la qualité ou la fiabilité, ce qui conduit en fin de compte à une satisfaction ininterrompue des clients.

Voici les étapes du fonctionnement d’un équilibreur de charge :

- Lorsqu’un client souhaite accéder aux informations d’un site web ou d’une application particulière, la demande est d’abord interceptée par un équilibreur de charge, puis atterrit sur le serveur concerné.

- L’équilibreur de charge, grâce à son algorithme d’équilibrage de charge, détermine le serveur le plus approprié auquel la demande du client doit être envoyée.

- Après avoir déterminé le serveur approprié, l’équilibreur de charge envoie la demande au serveur sélectionné.

- Le serveur traite la demande et répond à l’équilibreur de charge.

- L’équilibreur de charge renvoie ensuite la réponse au client.

- Les équilibreurs de charge sont des outils précieux qui améliorent les performances, la disponibilité et la sécurité des applications.

Les équilibreurs de charge utilisent les algorithmes d’équilibrage de charge décrits dans la sous-section suivante.

Avantages d’un équilibreur de charge

Les équilibreurs de charge offrent de nombreux avantages. Ils améliorent les performances, la disponibilité et les coûts en optimisant l’utilisation des ressources pour n’importe quelle application.

Voyons les avantages plus spécifiques des équilibreurs de charge :

- Les équilibreurs de charge sont des outils essentiels qui permettent de répartir le trafic sur plusieurs serveurs. En répartissant la charge de travail, ils améliorent efficacement les performances de l’application et empêchent la surcharge du serveur, prévenant ainsi toute dégradation potentielle. Les utilisateurs bénéficient ainsi de temps de réponse plus rapides et d’une stabilité accrue.

- Les répartiteurs de charge jouent un rôle crucial dans l’amélioration de la disponibilité des applications. En assurant la redondance et l’accessibilité continue, ils redirigent automatiquement le trafic vers les serveurs fonctionnels lorsque l’un d’entre eux est défaillant. Cette performance fiable garantit une expérience utilisateur ininterrompue, quelles que soient les circonstances.

- Les solutions d’équilibrage de charge sont mises en œuvre pour réduire les coûts en optimisant l’utilisation des ressources. Le trafic est réparti sur plusieurs serveurs, de sorte qu’aucun d’entre eux ne reste sous-utilisé. Cette approche permet d’économiser sur le matériel et les coûts d’exploitation.

- Les équilibreurs de charge améliorent l’optimisation en répartissant uniformément les charges de travail, évitant ainsi qu’une seule ressource ne soit submergée. Cette technologie améliore considérablement la fiabilité et l’efficacité de tout système.

Types d’équilibreurs de charge

Il existe trois types d’équilibreurs de charge :

❇️ Les équilibreurs de charge matériels sont des dispositifs physiques qui offrent des performances et une évolutivité accrues par rapport aux équilibreurs de charge logiciels. Bien qu’ils soient plus coûteux, leurs fonctionnalités spécialisées justifient l’investissement. Les équilibreurs de charge matériels sont utilisés dans les environnements à fort trafic, tels que les sites de commerce électronique et les applications web.

❇️ Les équilibreurs de charge logiciels sont des applications logicielles qui fonctionnent sur des serveurs. Ils offrent une alternative économique aux équilibreurs de charge matériels, bien que leurs performances et leur évolutivité ne soient pas toujours au même niveau. Ils conviennent aux petites entreprises et aux organisations dont le trafic est modéré.

❇️ Les répartiteurs de charge virtuels sont des répartiteurs de charge logiciels déployés sur des machines virtuelles. Ils offrent une solution rentable pour distribuer le trafic, mais leur fiabilité peut laisser à désirer.

Pour trouver l’équilibreur de charge idéal qui répond à vos besoins, il est essentiel de prendre en compte les exigences de l’organisation en termes de rentabilité, de facilité d’utilisation, de besoins en trafic, de complexité et d’objectifs d’évolutivité.

Les équilibreurs de charge matériels, logiciels et virtuels présentent des avantages et des inconvénients. Un équilibreur de charge matériel est recommandé si vous prévoyez un trafic important et si vous recherchez une grande fiabilité.

En revanche, si le budget est une préoccupation et que vous ne prévoyez pas un trafic important, un équilibreur de charge logiciel conviendrait. Pour ceux qui souhaitent une installation et une gestion faciles, un équilibreur de charge virtuel constitue un choix intéressant.

Le type de trafic que vous devez gérer avec votre équilibreur de charge est un autre facteur qui détermine le choix de l’équilibreur de charge à utiliser.

Il existe principalement quatre types d’équilibreurs de charge :

🔷 Les équilibreurs de charge d’application (ALB) gèrent le trafic HTTP/HTTPS, en le distribuant efficacement en fonction du contenu de la demande, comme l’URL ou les en-têtes HTTP. En outre, les ALB effectuent des contrôles de santé sur les serveurs dorsaux, garantissant que seuls les serveurs sains reçoivent du trafic. Vous trouverez de plus amples informations à l’adresse Application load balancer.

🔷 Les équilibreurs de charge réseau (NLB) sont couramment utilisés pour acheminer le trafic TCP. Il s’agit d’une solution optimale pour les applications qui exigent une réactivité rapide ou une capacité de transmission de données accrue. Les NLB peuvent distribuer efficacement le trafic entre plusieurs zones de disponibilité, renforçant ainsi les capacités de tolérance aux pannes.

🔷 Les répartiteurs de charge de serveurs globaux (GSLB) peuvent améliorer les performances en dirigeant le trafic vers le serveur le plus proche. Ces outils facilitent l’acheminement du trafic entre différentes régions géographiques. Ces équilibreurs peuvent être utiles pour les applications qui doivent être disponibles pour les utilisateurs dans différentes parties du monde.

🔷 L’équilibrage de la charge DNS est une technique permettant de répartir les demandes DNS entre plusieurs serveurs. Cela permet d’améliorer les temps de réponse, d’accroître la disponibilité et d’améliorer les performances des requêtes de retour.

Quels sont les algorithmes et les méthodes de répartition de la charge ?

Un algorithme de répartition de charge est l’ensemble des règles qu’un équilibreur de charge suit pour déterminer le meilleur serveur pour chacune des demandes des clients. Les algorithmes d’équilibrage de charge se répartissent en deux catégories principales : Les algorithmes statiques et les algorithmes dynamiques.

Voyons en détail chacune de ces méthodes d’équilibrage de la charge :

🟢 Équilibrage statique de la charge

Dans l’équilibrage de charge statique, l’algorithme prédéterminé répartit automatiquement le trafic entre les serveurs sans tenir compte de leur charge de trafic actuelle. Ce type d’équilibrage de la charge fonctionne souvent mieux lorsque le nombre d’utilisateurs reste constant ou qu’une faible latence n’a pas d’importance, comme c’est le cas pour les serveurs de partage de fichiers.

Voici quelques exemples d’équilibrage statique de la charge:

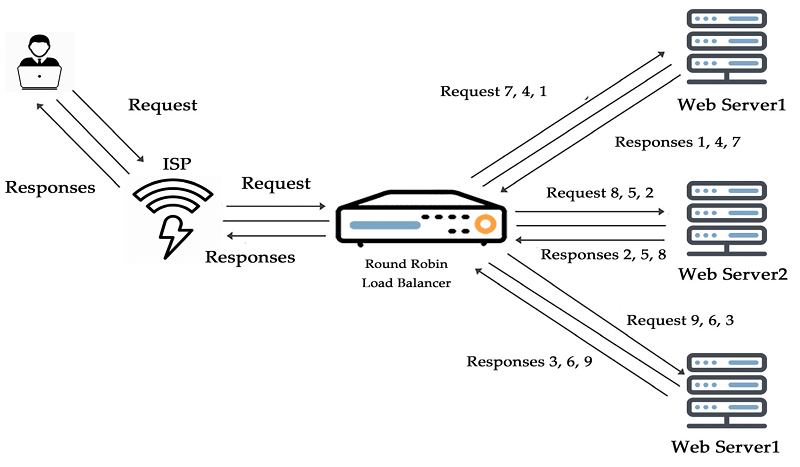

- Méthode Round-robin : La méthode Round-robin d’équilibrage de charge utilise un serveur de noms faisant autorité pour distribuer les demandes des clients sur une sélection de serveurs. Cette approche efficace ne nécessite pas de matériel ou de logiciel spécialisé, mais utilise les adresses IP de chaque appareil pour garantir que toutes les ressources disponibles sont utilisées sans faille.

- Méthode round-robin pondérée : Dans cet algorithme d’équilibrage de charge, le trafic est réparti entre les différents serveurs en fonction de leur priorité ou de leur capacité attribuée par l’administrateur. Les serveurs ayant un poids plus élevé recevront plus de trafic entrant.

- Méthode du hachage IP : Une méthode d’équilibrage de charge par hachage IP utilise un hachage mathématique sur les adresses IP des clients pour une mise en correspondance cohérente des demandes avec les différents serveurs, ce qui garantit des réponses fiables et rapides.

🟢 Équilibrage dynamique de la charge

Un équilibreur de charge dynamique assure efficacement des performances optimales du serveur dans les applications avec des niveaux de trafic variables et réduit la latence.

Il surveille en permanence les ressources de chaque serveur, achemine et équilibre les demandes pour maintenir un débit maximal pendant les heures de pointe des achats ou les sessions de streaming vidéo en répartissant le trafic entre eux en fonction de leur charge et en envoyant les utilisateurs vers les serveurs les plus proches.

- Méthode de moindre connexion : Les répartiteurs de charge utilisent la méthode de la moindre connexion pour déterminer quel serveur a le moins de connexions actives. Cette approche garantit que les demandes des clients sont réparties de manière égale et équitable sur tous les serveurs, ce qui permet d’allouer la même puissance de traitement.

- Méthode de la moindre connexion pondérée : Cet algorithme attribue des capacités variables à chaque serveur et tient compte de la capacité totale lorsqu’il décide quel serveur ayant le moins de connexions doit recevoir une demande.

- Méthode du moindre temps de réponse : Les répartiteurs de charge utilisent l’algorithme du moindre temps de réponse pour garantir un service plus rapide aux utilisateurs. Cet algorithme tient compte à la fois du temps de réponse du serveur et des connexions actives.

- Méthode basée sur les ressources : La méthode basée sur les ressources est employée pour équilibrer efficacement les charges des serveurs en utilisant un logiciel spécialisé qui analyse les ressources disponibles. Chaque serveur exécute un agent qui calcule l’utilisation de l’unité centrale et de la mémoire, garantissant ainsi une capacité adéquate pour distribuer le trafic à ce serveur spécifique.

Le meilleur algorithme d’équilibrage de charge dépendra des besoins et des exigences spécifiques de votre organisation.

Comment un équilibreur de charge est-il déployé ?

Dans cette section, nous verrons le déploiement par étapes d’un équilibreur de charge.

Le déploiement d’un équilibreur de charge dépend de facteurs tels que le type spécifique d’équilibreur de charge et l’environnement. La sélection de la stratégie d’équilibrage de charge la plus adaptée à une application particulière implique de prendre en compte des facteurs tels que les modèles de trafic, les objectifs de performance et d’autres exigences spécifiques.

Leséquilibreurs de charge sont des outils polyvalents qui peuvent être déployés dans différents environnements, notamment sur site, dans le nuage ou en tant que solution hybride. Cette flexibilité les rend bien adaptés aux entreprises de toutes tailles.

Le choix de l’équilibreur de charge approprié est crucial. Étant donné que chaque application possède des exigences uniques, il devient essentiel de configurer, d’installer et d’établir une connexion avec les serveurs.

Enfin, des tests approfondis garantissent un fonctionnement sans faille de tous les composants.

Il est essentiel d’examiner attentivement de nombreux facteurs lors de la sélection de l’équilibreur de charge approprié. Ces facteurs comprennent le choix entre le matériel et le logiciel, le nombre de serveurs concernés, les types de trafic traités, les contraintes budgétaires et les objectifs de performance.

Une fois l’équilibreur de charge sélectionné, il faut le configurer. Il convient de prendre en considération les algorithmes appropriés, les contrôles de santé, les paramètres de basculement et les paramètres de journalisation/surveillance qui correspondent aux besoins spécifiques de l’application.

Prendre le temps de configurer ces aspects avec précision garantit une distribution transparente du trafic tout en minimisant les problèmes potentiels causés par la défaillance du serveur ou l’instabilité résultant d’une mauvaise configuration.

Après avoir effectué toutes les vérifications nécessaires, l’étape suivante et finale consiste à installer et à configurer l’équilibreur de charge.

Le processus d’installation de l’équilibreur de charge comporte des étapes spécifiques adaptées à chaque type et à chaque environnement.

Une fois l’installation terminée, il est essentiel d’établir des connexions avec vos serveurs et de configurer avec précision tous les paramètres des deux côtés du réseau avant de lancer les processus de démarrage.

Une fois l’installation terminée, il est essentiel de s’assurer que l’équilibre de charge fonctionne correctement. La pratique standard pour les tests consiste à envoyer du trafic simulé en surveillant attentivement les journaux et les mesures tout en observant les performances globales.

Si ces tests s’avèrent concluants, la balance de charge peut passer en mode production, où elle traitera les demandes d’application des utilisateurs.

Lisez aussi : Équilibreur de charge open source pour la haute disponibilité et l’amélioration des performances

Passerelle NAT

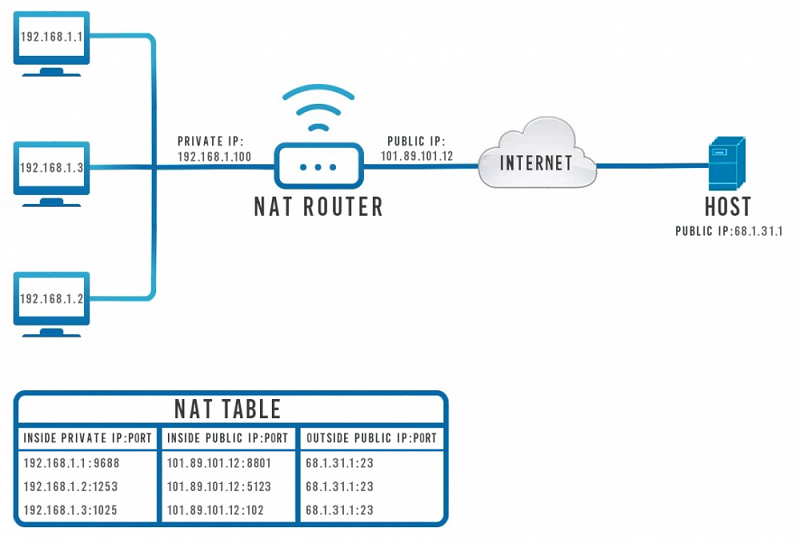

NAT est l’abréviation de Network Address Translation (traduction d’adresses de réseau). Comme son nom l’indique, il permet de traduire les adresses réseau.

Au cours de ce processus, les adresses IP locales sont converties en adresses IP globales et vice versa, ce qui permet d’accéder à l’internet. La NAT fonctionne sur le routeur frontalier, qui relie un réseau interne et un réseau externe.

La passerelle NAT offre aux réseaux privés une méthode sûre et fiable pour accéder à l’internet, en garantissant une protection contre les connexions entrantes. Cette solution de réseau avancée aide les organisations à respecter les exigences de conformité et facilite la communication en la consolidant via une passerelle unique et fiable au lieu de points d’extrémité inconnus.

Le NAT permet aux hôtes d’un réseau local d’initier le trafic sortant. Simultanément, il redirige en toute sécurité les réponses via son adresse IP publique, offrant ainsi aux entreprises un contrôle total sur leur activité web, quelle que soit leur taille.

Les passerelles NAT ont été délibérément conçues pour donner la priorité à la sécurité. Elles servent de passerelle pour établir des connexions sécurisées entre les réseaux privés, les services AWS et les systèmes sur site.

En exploitant les passerelles NAT, les entreprises peuvent maximiser l’efficacité de leurs VPC tout en protégeant leurs ressources contre les menaces potentielles provenant de sources externes non fiables.

La traduction d’adresses réseau (NAT) peut constituer une solution efficace au problème du chevauchement des adresses IP, en permettant à plusieurs réseaux et appareils dont les adresses se chevauchent de communiquer en toute sécurité.

En outre, les passerelles NAT permettent aux utilisateurs d’établir des connexions sécurisées avec des applications ou des appareils externes en utilisant des schémas d’adressage IP privés qui garantissent l’anonymat sur les liens internet publics. Elles constituent donc une solution viable pour relier de manière transparente les architectures en nuage aux infrastructures existantes utilisées pour le traitement ou le stockage des données.

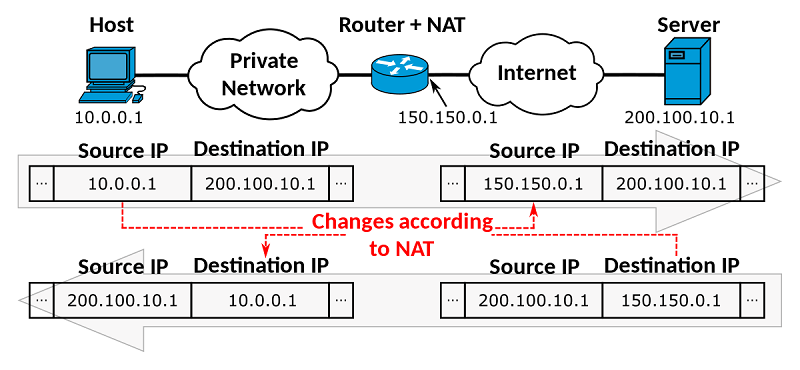

Comment le NAT traduit-il les adresses IP privées en adresses IP publiques ?

Lorsqu’un appareil connecté à un réseau privé souhaite communiquer avec le monde extérieur, le dispositif de traduction d’adresses réseau (NAT) entre en jeu. Il prend l’adresse IP privée de l’appareil et la traduit en adresse IP publique à partir d’un pool désigné. Ensuite, le dispositif NAT achemine le paquet vers sa destination prévue.

Lorsqu’un appareil du monde extérieur envoie un paquet à un appareil au sein d’un réseau privé, un dispositif de traduction d’adresses de réseau (NAT) traduit l’adresse IP publique de l’appareil de destination en son adresse IP privée. Ensuite, le dispositif NAT transmet le paquet pour qu’il atteigne sa destination prévue.

L’exemple suivant simplifie le processus de conversion d’adresse IP par NAT.

Un appareil connecté à un réseau privé, plus précisément avec l’adresse IP privée 192.168.1.84, doit établir une connexion avec un site web dont l’adresse IP publique est 10.0.0.75.

Pour permettre cette communication, le dispositif de traduction d’adresses de réseau (NAT) au sein du réseau privé traduit l’adresse IP privée de l’appareil en adresse IP publique 10.0.0.100. Une fois cette traduction effectuée, le dispositif NAT transmet le paquet à la destination prévue sur le site web.

Lorsque le site web répond, le dispositif NAT effectue une traduction. Il remplace l’adresse IP publique du site web par l’adresse IP privée 192.168.1.84. Ensuite, le dispositif NAT transmet le paquet à l’appareil situé sur le réseau privé.

Si toutes les adresses allouées sont épuisées, le protocole ICMP envoie des messages indiquant qu’il n’y a plus d’espace disponible pour établir des connexions. Les demandes sont donc abandonnées et les paquets correspondants sont envoyés en conséquence.

Le NAT, une technologie précieuse, sert deux objectifs : il conserve les adresses IP publiques et protège les réseaux privés de l’internet.

Différents types de NAT

Le NAT est une technique qui permet de traduire plusieurs adresses de réseaux privés en une seule adresse publique.

À l’heure actuelle, le NAT est utilisé pour répondre aux besoins spécifiques des entreprises sous trois formes différentes, à savoir : La NAT statique, la NAT dynamique et la traduction d’adresses de ports (PAT).

- LeNAT st atique fait correspondre une seule adresse IP privée à une seule adresse IP publique et s’applique à l’utilisation de serveurs web ou de messagerie. Il est plus facile à contrôler et offre une visibilité sur le trafic réseau entrant et sortant.

- LeNAT dynamique permet l’expansion économique de l’adresse IP privée vers l’internet. Elles sont mappées sur des IP publiques, protégeant ainsi l’accès du client, ce qui ne nécessite pas l’utilisation d’adresses dédiées.

- Latraduction d’adresses de port (PAT) est un exemple de traduction dynamique d’adresses de réseau (NAT) qui permet de mieux utiliser une seule adresse IP publique pour un certain nombre d’appareils privés.

La PAT y parvient grâce à l’utilisation de numéros de port dans l’en-tête des paquets, ce qui permet à la destination de savoir à quel appareil spécifique du réseau privé le paquet est destiné.

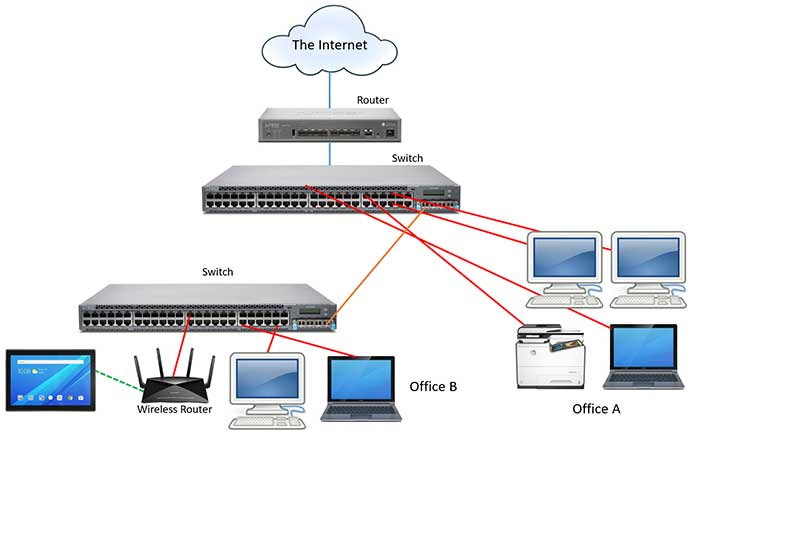

Le routage

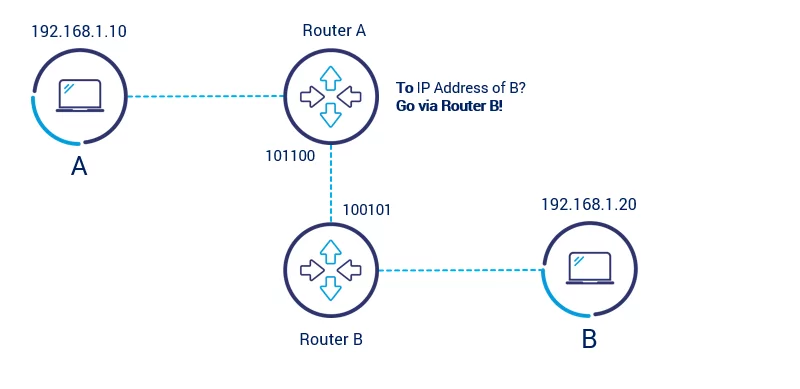

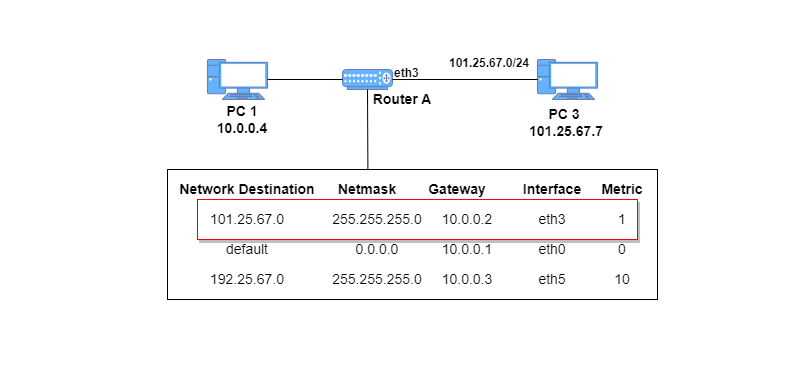

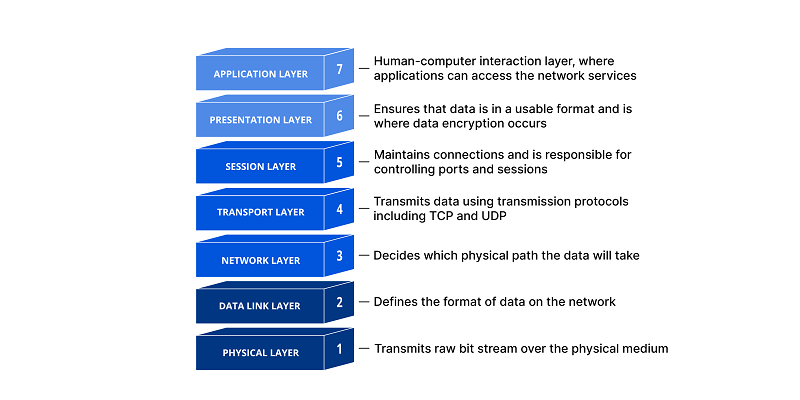

Le routage est un processus crucial dans la communication en réseau. Il permet une livraison efficace et fiable des données de la source à la destination prévue. Un dispositif appelé routeur effectue les tâches de routage.

Les routeurs sont connectés à plusieurs réseaux et utilisent des protocoles tels que RIP, OSPF ou BGP pour échanger des informations et déterminer les meilleurs itinéraires dans leurs tables de routage. À l’arrivée d’un paquet sur un routeur, celui-ci consulte sa table de routage avant de procéder au transfert. Ce processus itératif se poursuit jusqu’à ce que le paquet arrive à son destinataire.

Les routeurs jouent un rôle essentiel dans l’amélioration de l’efficacité des réseaux. Ils sont chargés d’acheminer les données le long du chemin le plus optimal, augmentant ainsi la vitesse et la fiabilité du transfert de données.

Les organisations ne doivent pas sous-estimer l’importance des routeurs si elles souhaitent obtenir des performances optimales dans les communications à distance entre les appareils.

Comment fonctionne le routage ?

Le routage joue un rôle crucial dans la communication réseau. Il permet le transfert efficace des paquets de données de leur source à leur destination. Ce processus implique que les routeurs se réfèrent aux tables de routage pour identifier le chemin optimal de transmission des données. Différents facteurs sont pris en compte.

Au cours du voyage de chaque paquet à travers les réseaux, qu’ils soient grands ou petits, des facteurs tels que la distance entre les nœuds, la charge des liaisons, la fiabilité des voies de connexion et les protocoles utilisés sont minutieusement pris en compte. Lors de chaque transmission d’informations, les paquets de données atteindront inévitablement, rapidement et en toute sécurité, la destination prévue.

Il existe deux principaux types de routage : statique et dynamique.

Dans les petits réseaux où la topologie reste constante, le routage statique est utilisé. Cela implique de configurer manuellement les tables de routage.

En revanche, le routage dynamique est utilisé dans les grands réseaux qui subissent fréquemment des changements, car les routeurs échangent automatiquement des informations. Dans un scénario de routage dynamique, le système assure un flux de données continu sur des réseaux de toute taille et de toute complexité.

Les protocoles de routage les plus courants sont les suivants :

- Routing Information Protocol (RIP) est un protocole à vecteur de distance. Il détermine le meilleur chemin vers une destination en considérant le nombre de sauts comme métrique. Le RIP est connu pour sa simplicité et sa facilité de configuration, ce qui le rend adapté aux petits réseaux. Cependant, il peut entraîner un temps de convergence lent dans les réseaux plus étendus, ce qui le rend moins idéal.

- Le protocole EIGRP (Enhanced Interior Gateway Routing Protocol) est un protocole de routage hybride, qui combine des éléments des protocoles à vecteur de distance et à état de liens. Bien que l’EIGRP soit plus complexe que le RIP, il est plus efficace et plus évolutif.

- Open Shortest Path First (OSPF) est un protocole à état de liens. Il détermine le meilleur chemin vers une destination en tenant compte du coût de chaque lien. Comparé à RIP ou EIGRP, OSPF est plus complexe mais offre une efficacité et une évolutivité accrues.

- Border Gateway Protocol (BGP ) est un protocole de passerelle extérieure chargé de faciliter l’échange d’informations de routage entre les systèmes autonomes (AS). Le BGP est le protocole de routage le plus complexe, mais remarquablement adaptable et évolutif.

Le choix du meilleur protocole de routage dépend des exigences spécifiques du réseau. Par exemple, RIP est une option optimale pour les petits réseaux aux topologies simples.