Moderne Unternehmen verlassen sich zunehmend auf integrierte Systeme innerhalb der AWS (Amazon Web Services) Cloud, um robuste und skalierbare Lösungen bereitzustellen. Die Gewährleistung einer optimalen Leistung dieser integrierten Systeme kann jedoch eine komplexe Aufgabe sein.

Die Optimierung Ihres AWS-Cloud-Systems für maximale Effizienz kann Ihnen helfen, die Leistung zu verbessern, die Kosten zu senken und die allgemeine betriebliche Effizienz zu steigern.

In diesem Artikel werden die wichtigsten Strategien zur Verbesserung der Leistung integrierter Systeme in der AWS-Cloud erörtert, z. B. Lastausgleich, automatische Skalierung, Caching und Datenlaststrategien.

Was ist Optimierung in der AWS-Cloud?

Optimierung in der AWS-Cloud bezieht sich auf Aktivitäten, die die Leistung, Effektivität und Betriebskosten von Cloud-basierten Systemen und Prozessen verbessern. Sie sollten sich auf Bereiche konzentrieren, in denen sich Verbesserungen leicht erzielen lassen und gleichzeitig die Sicherheit Ihres bestehenden Systems gewährleistet ist.

Wenn der für die Verbesserung erforderliche Aufwand zu hoch wird, spricht man nicht mehr von Optimierung. In solchen Fällen spricht man von einem System-Refactoring.

Das Refactoring ist in der Regel ein weitaus kostspieligerer Prozess, bei dem die bestehende technische Lösung erheblich verändert wird, weil sie die Anforderungen nicht mehr erfüllt. Deshalb sollten wir die schrittweisen Aktualisierungen des Systems so planen, dass wir den Refactoring-Bedarf im Laufe der Zeit minimieren.

Das ultimative Ziel der Systemoptimierung besteht also darin, Strategien zu implementieren, mit denen bessere Ergebnisse bei minimalen zusätzlichen Kosten erzielt werden. Sie können diesen Prozess auch so betrachten, dass Sie Wege zur Kostensenkung finden, ohne die Leistung zu beeinträchtigen. Einige Teile dieses Ziels können Sie sogar erreichen, ohne den Quellcode zu ändern.

Zum Beispiel durch Strategien wie das Rightsizing von Instanzen oder die Nutzung von Spot-Instanzen für nicht kritische Arbeitslasten. Sie können auch verschiedene von AWS bereitgestellte Kostenoptimierungsstrategien und Tools einsetzen, die Ihnen proaktiv weitere nützliche Hinweise geben.

Darüber hinaus können Sie Ihre derzeitige Nutzung des AWS-Preismodells in der Architektur prüfen und Änderungen vornehmen, um sie effektiver zu gestalten. AWS definiert die Kostenoptimierung sogar als eine der Säulen der Performance-Effizienz eines gut archivierten Frameworks.

All diese Maßnahmen verzögern die Notwendigkeit eines System-Refactorings oder machen es auf lange Sicht sogar ganz überflüssig.

Es ist sehr wichtig, die richtige Balance zwischen der Optimierung der Ressourcennutzung und der Minimierung ungenutzter Ressourcen zu finden, die zu potenziellen Kosteneinsparungen führen. Dieses Gleichgewicht wird hergestellt, indem die für Ihre Anwendung geltenden Ressourcennutzungsmuster und die Art und Weise, wie sie genutzt wird, berücksichtigt werden.

Das bedeutet, dass Sie jederzeit Recheninstanzen, Speicher oder Netzwerkdienste erhöhen können, um die gewünschte Leistung zu erzielen. Sie sollten jedoch immer prüfen, ob die von Ihnen erworbenen Upgrade-Vorteile weniger kosten als die Summe der Kosten, die Sie durch eine solche Architekturänderung einsparen konnten.

Hauptaspekte der AWS-Optimierung

Wenn es um die Optimierung in der AWS-Cloud geht, sind einige der Aspekte wichtiger als andere. Lassen Sie uns einen Blick auf die Aspekte werfen, die meiner Meinung nach bei den meisten Optimierungsinitiativen ganz oben auf der Liste stehen.

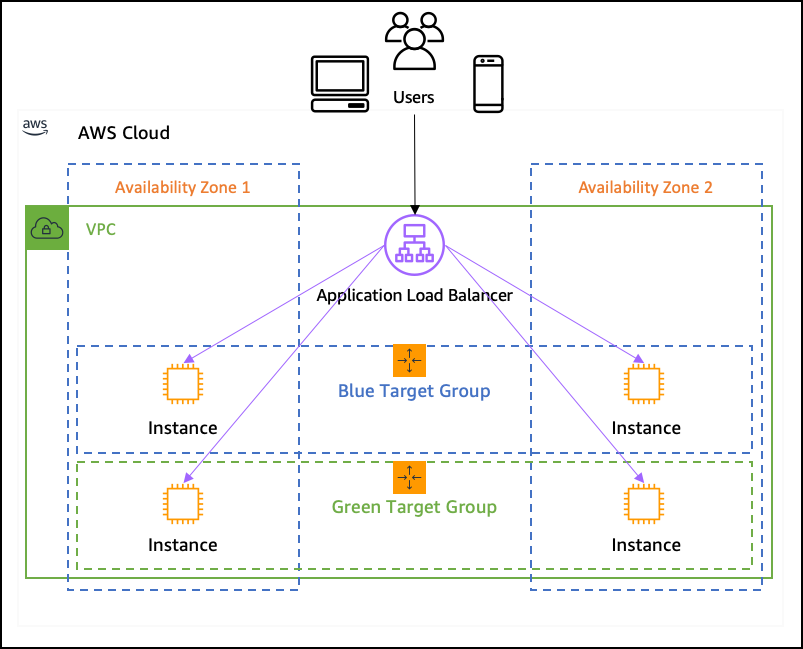

#1. Wenden Sie Load Balancing an, wo es möglich ist

Der Lastausgleich spielt eine entscheidende Rolle bei der Verteilung des eingehenden Datenverkehrs auf mehrere Ressourcen, um eine optimale Leistung zu gewährleisten. Beim Entwurf der Architektur sollten Sie einen Lastausgleich für so viele Teile des Systems wie möglich in Betracht ziehen.

Die Systeme werden mit der Zeit immer komplexer. Sie können nicht vorhersagen, wie sie sich im Laufe der nächsten Jahre entwickeln werden. Mit den Lastausgleichstechniken können Sie die Plattform besser auf ein solches Wachstum vorbereiten.

AWS bietet Elastic Load Balancing (ELB) Services, die den eingehenden Datenverkehr automatisch auf mehrere Instanzen verteilen. Der Lastausgleich hilft zu verhindern, dass eine einzelne Ressource überlastet wird, und verbessert so die Systemleistung. Es muss nicht einmal mehr kosten, denn Sie können sich kleinere Instanzen leisten, wenn Sie eine große und leistungsstarke Instanz haben.

Sie können den Lastausgleich sogar auf der Netzwerkebene (unabhängig von den Anwendungen selbst) mit Hilfe von Gateway Load Balancern durchführen. Dadurch wird die Last auf mehrere Firewalls oder Intrusion Detection-Infrastrukturkomponenten verteilt, wodurch Ihre gesamte Plattform sicherer wird.

In AWS können Sie viele Instanzen als serverlose Instanzen statt als Standard-Amazon EC2-Instanzen konzipieren (die ständig Kosten verursachen, wenn Sie sie nicht abschalten). Das bedeutet, dass diese zusätzlichen Instanzen keine Kosten verbrauchen, wenn es nichts zu verarbeiten gibt, es sei denn, sie sind tatsächlich in Betrieb (d. h. bei erhöhter Last).

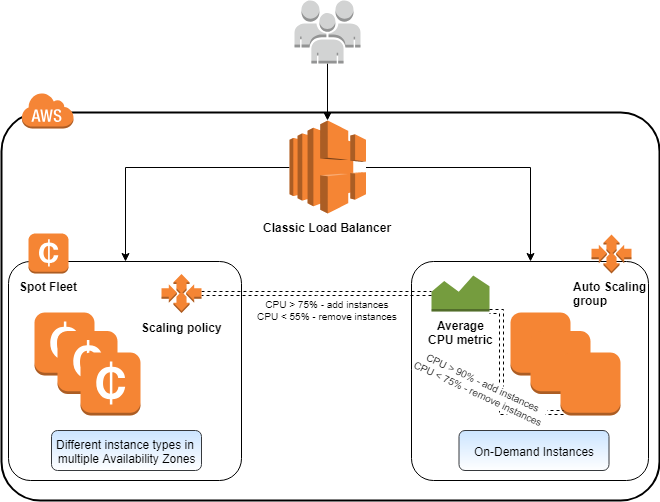

#2. Aktivieren Sie Auto-Scaling, wo es sinnvoll ist

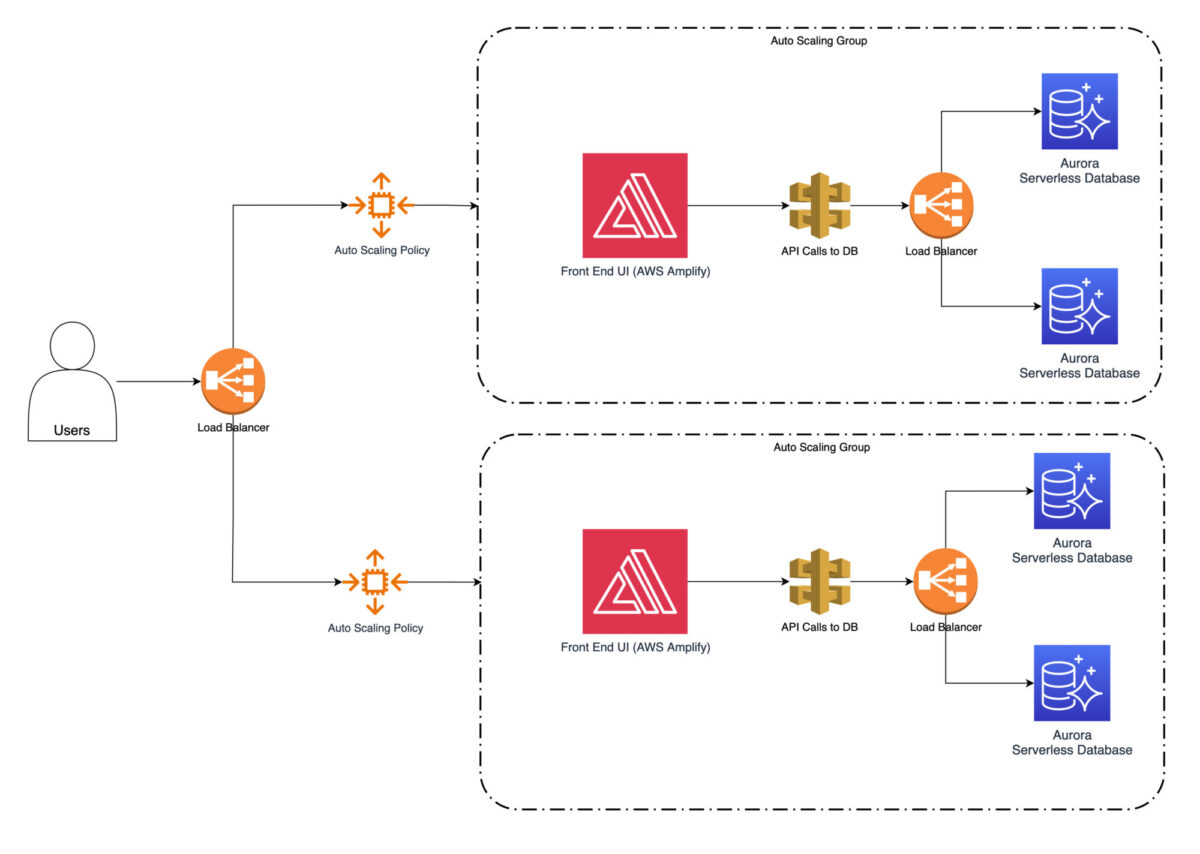

Die automatische Skalierung ermöglicht es Ihrem System, seine Kapazität automatisch an den eingehenden Datenverkehr anzupassen. Das kann in beide Richtungen gehen – nach oben und nach unten. AWS Auto-Scaling ist eine spezielle Funktion, die auch heute noch nicht jeder große Cloud-Anbieter anbietet.

Sie können Skalierungsrichtlinien definieren, die automatisch Instanzen auf der Grundlage von vordefinierten Bedingungen hinzufügen oder entfernen. Dabei handelt es sich in der Regel um eine horizontale Skalierung, bei der Sie eine oder mehrere Instanzen starten und sie dann auf der Grundlage der aktuellen Last zur Verarbeitungskette hinzufügen.

Eine vertikale Skalierung ist ebenfalls möglich. Das bedeutet, dass Sie die Konfiguration bestehender Instanzen auf höhere Spezifikationen ändern, z.B. eine höhere CPU-Spezifikation, mehr Arbeitsspeicher oder mehr Festplattenspeicher. Dies ist in einer Cloud-Umgebung viel einfacher, da Sie sich nicht mit physischer Hardware befassen müssen. Die zugrunde liegende Hardware, die für eine solche vertikale Skalierung erforderlich ist, wird von AWS verwaltet, und Sie brauchen sich darum nicht zu kümmern.

Die Skalierung wird dann (im Einklang mit Ihren Richtlinien) nach oben oder unten skaliert, je nachdem, wie viel Datenverkehr verarbeitet werden muss. Das Gute daran ist, dass Sie die Skalierungsprozesse nicht beobachten müssen, sobald sie einmal festgelegt sind.

Sie werden sich automatisch anpassen. Wenn Sie die Richtlinien effektiv und gut auf Ihr übliches Verarbeitungsvolumen abgestimmt definieren, werden Sie insgesamt Infrastrukturkosten sparen. Dann zahlen Sie nicht für zusätzliche Instanzen, wenn diese nicht notwendig sind.

Außerdem werden Sie die Daten bei Lastspitzen nicht zu lange verarbeiten. Ihr System bewältigt unterschiedliche Computerauslastungen effizient, verbessert die Leistung in Spitzenzeiten und reduziert die Cloud-Kosten in Zeiten geringer Nachfrage.

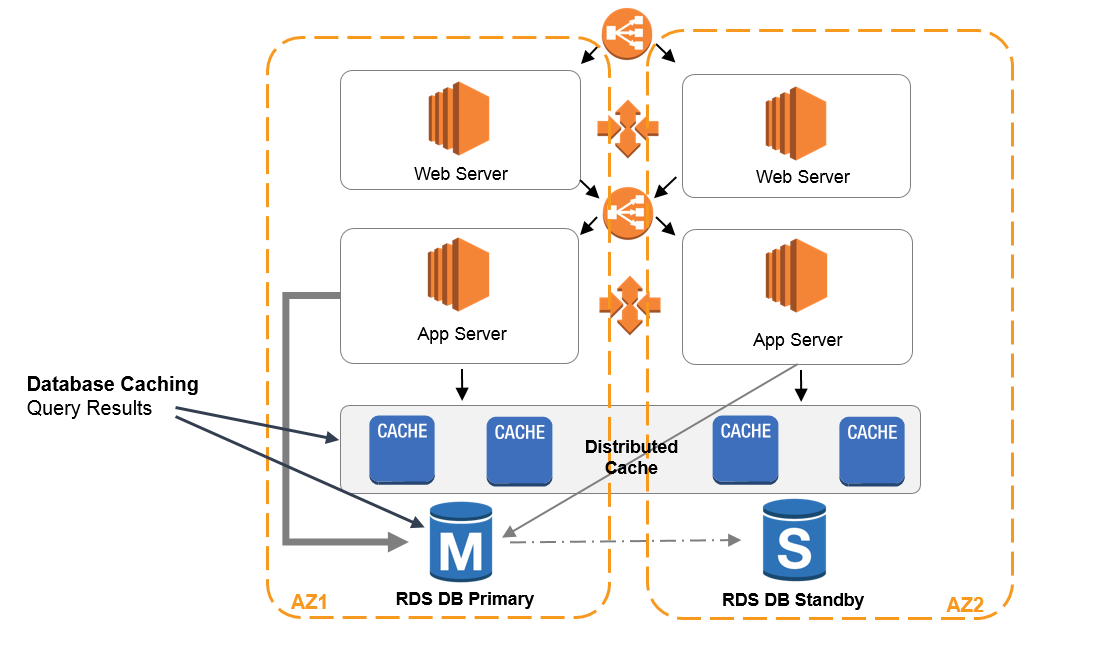

#3. Caching-Prinzipien

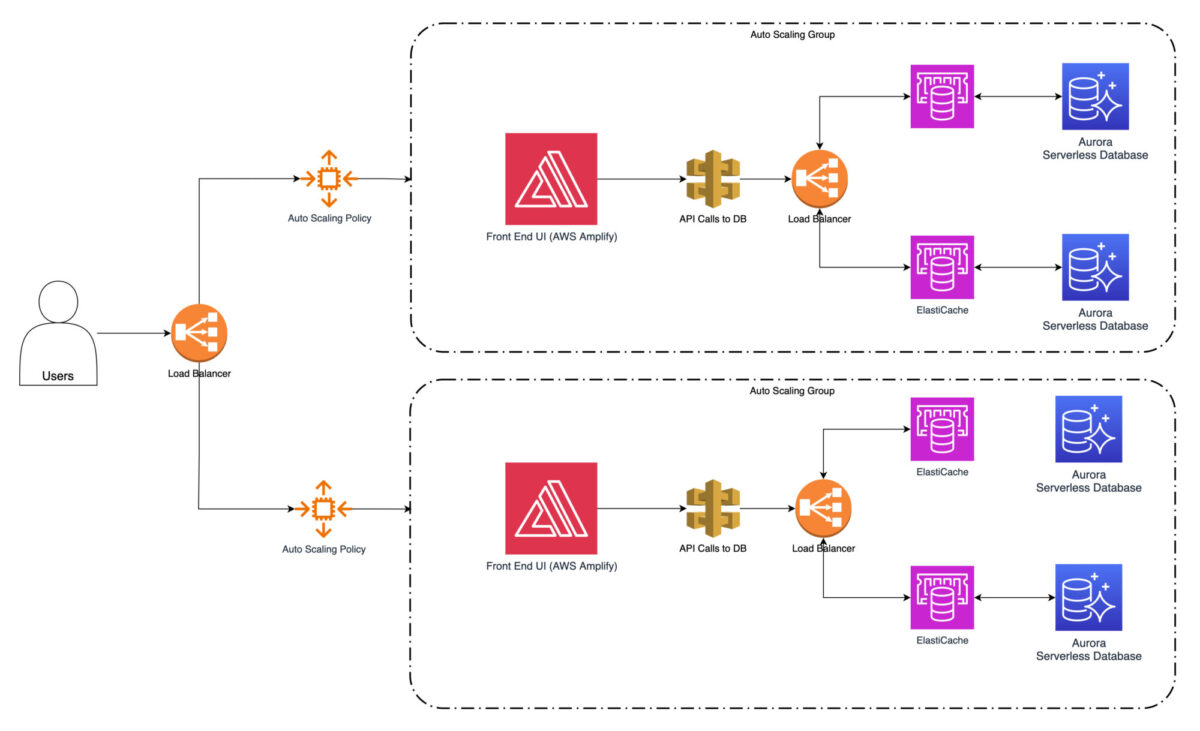

Caching ist eine Technik, bei der Daten, auf die häufig zugegriffen wird, in einem Cache (bezogen auf einen bestimmten Cloud-Service) gespeichert werden, so dass sie nicht wiederholt von der ursprünglichen Quelle abgerufen werden müssen.

Amazon Web Services enthält den Webservice Amazon ElastiCache. Dabei handelt es sich um einen vollständig verwalteten In-Memory-Caching-Service, der beliebte Caching-Engines wie Redis und Memcached unterstützt. Sie können ihn nutzen und an den Stellen in Ihre Systemarchitektur integrieren, an denen der Benutzer die Daten sehr häufig extrahiert.

Mit solchen Caching-Strategien können Sie die Antwortzeiten erheblich reduzieren und die Gesamtleistung Ihrer integrierten Systeme verbessern. Ein Bereich, den Sie jedoch sorgfältig prüfen sollten, ist die Sicherstellung, dass die Daten, die Sie lesen, in Bezug auf das Quellsystem immer auf dem neuesten Stand sind.

Auch wenn das Zwischenspeichern von Daten den Endbenutzern ein viel schnelleres Lesen ermöglicht, bringt es nicht viel, wenn die Daten bereits veraltet sind. Um das zu vermeiden, sollten Sie die folgenden Caching-Eigenschaften berücksichtigen:

- Eine Möglichkeit, die Frische der Daten zu gewährleisten, besteht darin, eine Verfallszeit oder Time-to-Live (TTL) für gecachte Daten festzulegen. Wenn die Daten ihre Verfallszeit erreichen, wird der Cache ungültig gemacht und die nächste Anfrage holt die aktualisierten Daten aus der Quelle. Wenn Sie eine geeignete TTL festlegen, können Sie den Kompromiss zwischen der Aktualität der Daten und der Leistung des Caches ausgleichen.

- Die Invalidierung des Cache ist eine Technik, mit der Daten auf dem neuesten Stand gehalten werden. Wenn sich die zugrundeliegenden Daten ändern, muss der Cache ungültig gemacht werden, um die neuesten Daten aus der Quelle abzurufen. AWS bietet verschiedene Mechanismen zur Auslösung der Cache-Invalidierung. Sie können zum Beispiel AWS Lambda-Funktionen dafür programmieren oder die Cache-Invalidierung in den Datenaktualisierungsprozess Ihrer Anwendung integrieren.

- Das Cache-Aside-Muster bedeutet, dass Daten nur dann aus dem Cache geholt werden, wenn sie vorhanden sind. Wenn nicht, rufen Sie sie aus der Quelle ab und füllen den Cache auf. Wenn Sie Daten aktualisieren, wird der Cache ungültig gemacht und nachfolgende Anfragen holen die aktualisierten Daten aus der Quelle. Dieses Muster stellt sicher, dass der Cache auf dem neuesten Stand bleibt, während die Auswirkungen auf die Leistung minimiert werden.

- Das Cache-Through-Muster aktualisiert den Cache immer dann, wenn eine Datenaktualisierung in der Quelle erfolgt. Wenn auf der Quellseite ein Schreibvorgang stattfindet, wird der Cache zur gleichen Zeit aktualisiert. Dies garantiert, dass der Cache immer die aktuellsten Daten enthält, kann jedoch aufgrund der erforderlichen synchronen Aktualisierungen zu zusätzlichem Overhead führen.

- Die Aufrechterhaltung der Cache-Kohärenz und -Konsistenz ist entscheidend, um sicherzustellen, dass die Daten auf dem neuesten Stand bleiben. Dies können Sie erreichen, indem Sie bei der Aktualisierung von Daten geeignete Synchronisationsmechanismen einsetzen. Auf diese Weise vermeiden Sie Inkonsistenzen zwischen dem Cache und der Quelle. AWS bietet Services wie Amazon ElastiCache, die Ihnen sofort einsetzbare Funktionen wie Cache-Replikation und Konsistenzmodelle zur Verfügung stellen, um die Datenintegrität zu gewährleisten.

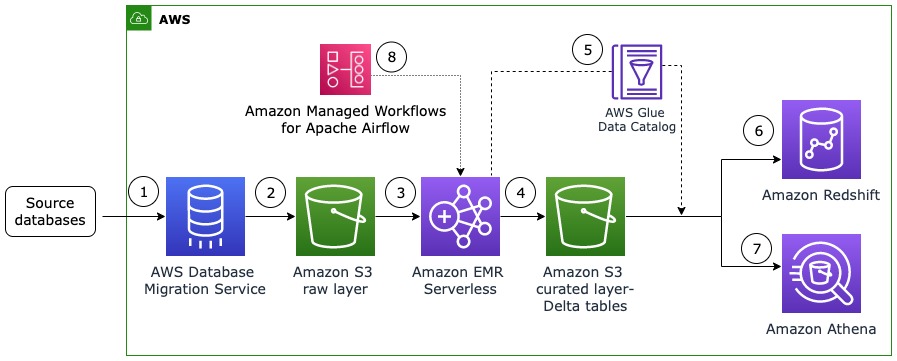

Effektive Strategien zum Laden von Daten

Bei der Integration von Betriebssystemen in die AWS-Cloud müssen Sie sich unbedingt überlegen, welche Datenladestrategien Sie anwenden wollen. Dabei geht es nicht so sehr darum, wie schnell die Datenaktualisierung erfolgt (ob in Echtzeit oder im Batch-Verfahren).

Es geht vielmehr darum, wie viele Daten ich jedes Mal auf der Zielseite verarbeiten muss, um relevante Ergebnisse zu erhalten. In der Regel muss man sich zwischen vollständiger Datenübertragung und inkrementeller Datenübertragung entscheiden.

#1. Vollständige Datenlast-Strategie

Eine vollständige Datenladestrategie bietet Ihnen den Vorteil, dass die Implementierung einfach und leicht zu bewerkstelligen ist. Ich kann beobachten, dass die Projektteams oft dazu neigen, dies zu tun.

Der Vorteil der kürzesten Zeit bis zur Produktion (und der geringsten Kostenanforderungen für die erste Version) ist so verlockend, dass sowohl der Kunde als auch die Projektteams selten bereit sind, weitere Optionen zu erkunden.

Bei einer vollständigen Datenladestrategie wollen Sie alle Daten aus dem Quellsystem in das Zielsystem übertragen. Dieser Ansatz eignet sich sehr gut für die erste Datensynchronisierung oder wenn Sie einfach den gesamten Datenbestand aktualisieren müssen. Sie kann jedoch zeitaufwändig und ressourcenintensiv sein. Manchmal ist es dennoch die beste Strategie. Zum Beispiel, wenn sich die Daten in der Quelle häufig drastisch ändern.

Nehmen wir an, dass mehr als 50% aller Daten vor jedem nächsten Ladevorgang in Ihrer Architektur geändert werden. In diesem Fall ist es absolut sinnvoll, den vollständigen Datenladeprozess zu implementieren.

Was aber, wenn das Quellsystem nur ab und zu einen kleinen Prozentsatz des gesamten Datenbestands ändert? Und was ist, wenn Sie den Ladeprozess stündlich oder sogar noch häufiger durchführen müssen?

Das sind die Fälle, in denen ein vollständiges Laden der Daten eine absolute Verschwendung von Zeit, hohem Ressourcenverbrauch, Speicherkosten, Rechenleistung und Geld bedeutet – und das alles zur gleichen Zeit. Die Implementierung mag zwar immer noch schneller sein, ist aber auf lange Sicht wesentlich kostspieliger als eine inkrementelle Ladung.

#2. Inkrementelle Datenladestrategie

Bei einer inkrementellen Datenladestrategie wollen Sie nur die Änderungen oder Aktualisierungen seit dem letzten Synchronisationslauf übertragen. Dieser Ansatz reduziert die Datenmenge, die zwischen den Systemen übertragen oder während der Übertragung gespeichert werden muss, erheblich.

Die Strategie des inkrementellen Datenladens führt zu einer schnelleren Synchronisierung und verbesserten Leistungskennzahlen. Sie ist ideal für Szenarien, in denen häufige Aktualisierungen auftreten.

Das inkrementelle Laden erfordert jedoch in der Regel einen viel ausgefeilteren Ansatz. Sie erfordert ein ausgeklügeltes Architekturdesign und manchmal sogar eine gute Synchronisierung aller Verbindungsprozesse, die Sie für die Ausführung der Ladevorgänge benötigen.

Außerdem ist die Wahrscheinlichkeit viel größer, dass Sie einen Teil der Datenänderungen während der Prozesse verpassen. Das passiert meistens, wenn das Quellsystem außerhalb Ihrer Plattform und Ihrer direkten Verantwortung liegt.

In diesem Fall haben Sie natürlich nicht die volle Kontrolle über die Prozesse, die im Quellsystem stattfinden. Sie müssen sich auf eine gute Kommunikation mit dem externen Anbieter verlassen und dafür sorgen, dass die Integrationsmuster aktualisiert werden, sobald eine Änderung im Quellsystem eintritt.

Andernfalls erhalten Sie möglicherweise nicht den vollständigen Satz der letzten Dateninkremente. Und vielleicht wissen Sie nicht einmal davon. Das kann passieren, wenn die Änderung im Quellsystem so beschaffen ist, dass alle bestehenden Schnittstellen und Verbindungen immer noch einwandfrei funktionieren, obwohl sie weniger Daten abrufen, als sie jetzt sollten.

Praktisches Beispiel für den AWS-Optimierungsprozess

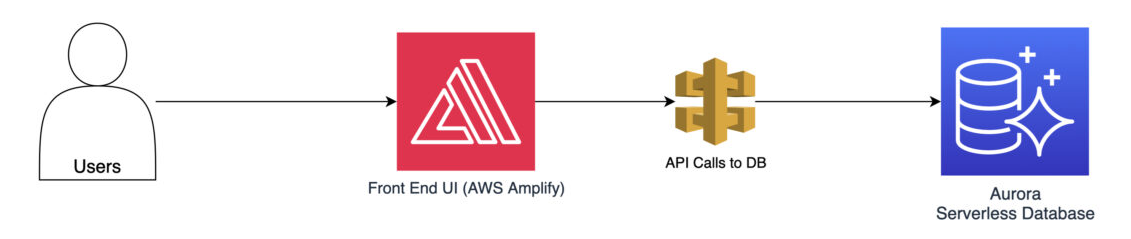

Betrachten wir ein Beispiel aus der Praxis, um die praktische Anwendung dieser Techniken zu veranschaulichen. Stellen Sie sich eine beliebte Shopping-Website vor, die auf AWS gehostet wird. Während der Haupteinkaufszeiten ist die Website extrem stark ausgelastet, was zu deutlich langsameren Antwortzeiten führt. Möglicherweise kann es sogar zu sporadischen Ausfällen kommen.

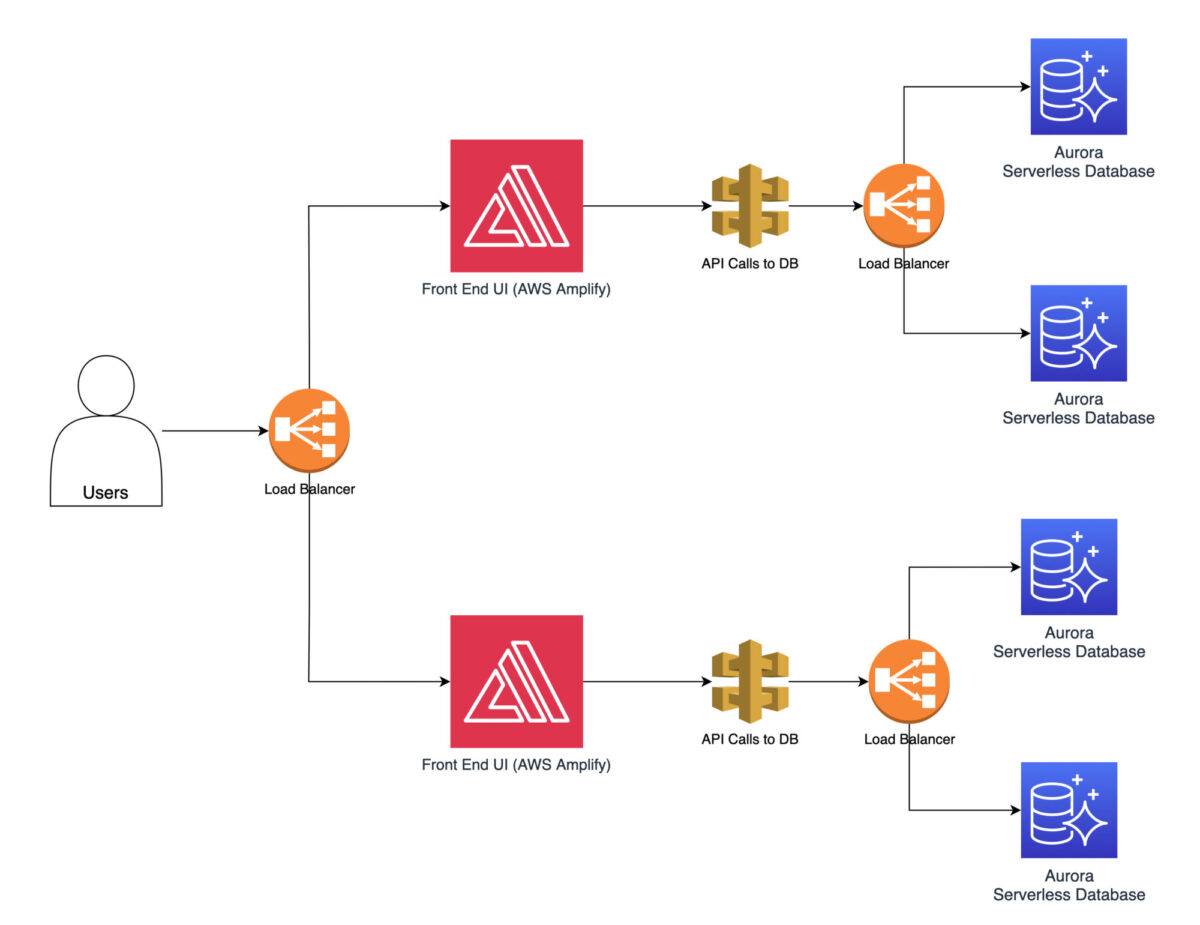

Als ersten Schritt zur Leistungsoptimierung können Sie mit AWS Elastic Load Balancer einen Lastausgleich implementieren. Dadurch wird sichergestellt, dass Sie den eingehenden Datenverkehr gleichmäßig auf mehrere Instanzen verteilen. Dadurch wird verhindert, dass die Instanzen überlastet werden.

In einem nächsten Schritt können Sie die automatische Skalierung so konfigurieren, dass in Spitzenzeiten automatisch mehr Instances hinzugefügt und in Zeiten geringer Nachfrage entfernt werden. Dadurch wird sichergestellt, dass die Website den erhöhten Datenverkehr bewältigen und eine optimale Leistung beibehalten kann.

Schließlich gibt es noch die Möglichkeit, Caching-Strategien mit Amazon ElastiCache zu implementieren, die die Zeit, die zum Abrufen der Daten von der Quelle benötigt wird, weiter reduzieren. Daten, auf die häufig zugegriffen wird, wie z.B. Produktinformationen oder Benutzereinstellungen, können zwischengespeichert werden.

Auch bei aktuellen Daten besteht kein großes Risiko, da sich solche Informationen nur sehr selten ändern. Die Notwendigkeit, sie immer wieder von den Datenbankdiensten abzurufen, wird dadurch erheblich reduziert. Dadurch werden die Antwortzeiten und die Gesamtleistung des Betriebssystems erheblich verbessert.

Abschließende Überlegungen: Maximierung der Effizienz der AWS-Cloud-Integration

Die Optimierung der Leistung bei der Integration von AWS-Cloud-Systemen und die Überwindung von Leistungsproblemen ist eine fortlaufende Aufgabe. Da sich Ihre Plattform weiterentwickelt, sollten Sie die AWS-Architektur regelmäßig überprüfen.

Um eine optimale Leistung aufrechtzuerhalten, ist es ratsam, die AWS-Architektur regelmäßig zu überprüfen und Techniken wie Lastausgleich, automatische Skalierung, Caching-Strategien und die Auswahl der geeigneten Datenlaststrategie zu implementieren.

Die hier besprochenen AWS-Optimierungsstrategien und -techniken sind nicht nur theoretisch, sondern können in realen Projekten in die Praxis umgesetzt werden. Sie können diese AWS-Optimierungsstrategien nutzen, um integrierte Hochleistungssysteme zu erreichen, die den Anforderungen der digitalen Landschaft in der heutigen Geschäftswelt gerecht werden.