14 mejores programas informáticos para empresas en 2025

Nuestra gama de recursos empresariales permite agilizar la gestión de proyectos, administrar los recursos humanos, potenciar la relación con los clientes y mejorar la colaboración en grupo.

Controle la gestión de proyectos, el trabajo en equipo y la atención al cliente con el asesoramiento de expertos y las herramientas más innovadoras. Optimize la productividad, la cooperación y la satisfacción del cliente.

Promueva el trabajo en equipo continuo con nuestra lista de las mejores herramientas de colaboración. Conozca ideas sobre comunicación, gestión de proyectos y estrategias eficaces de colaboración a distancia.

13 mejores programas de foros para crear comunidades atractivas

7 mejores programas de intercambio electrónico de datos (EDI)

los 10 mejores equipos de videoconferencia para pequeñas empresas [2025]

las 8 mejores herramientas de documentación de bases de datos que deberá probar en 2025

10 mejores analizadores PDF y software OCR para extraer datos de documentos con precisión

9 mejores programas de intranet para la comunicación interna de los empleados

Ofreczca un servicio de atención al cliente sobresaliente con nuestra selección de software de atención al cliente. Mejore la calidad del servicio, aumente los tiempos de respuesta y potencie al máximo la satisfacción del cliente.

7 mejores programas de chat en directo de código abierto para hablar con sus clientes

Los 17 mejores softwares de Help Desk para una atención al cliente superior en 2025

los 12 mejores software de gestión de la experiencia del cliente que se utilizarán en 2025

los 15 mejores software de punto de venta para 2025

13 mejores programas y herramientas de encuestas Net Promoter Score (NPS) para medir la satisfacción de los clientes [2025]

Cree manuales informativos con estos 11 programas para manuales de usuario

Nuestras recomendaciones especializadas sobre software, recursos y estrategias de gestión de proyectos le ayudarán a gestionar con éxito los proyectos integrales.

11 mejores herramientas Kanban para una gestión eficaz del equipo

16 mejores plantillas de planificación de proyectos para descargar en 2025

11 mejores herramientas Scrum para la gestión ágil de proyectos en 2025

14 Mejores programas informáticos de gestión de recursos en 2025

12 mejores programas gratuitos de gestión de proyectos para 2025

Hoja de ruta del proyecto: Guía y plantillas gratuitas [2025]

Fomente el compromiso de los empleados, optimice la contratación, mejore el rendimiento de las personas y aumente la productividad en el lugar de trabajo con nuestras mejores selecciones y metodologías de software de RR.HH.

las 8 mejores plataformas para contratar mecanógrafos en 2025

Cómo obtener la certificación SHRM en 2025

14 Mejores Programas de Contratación [Incluye IA]

El mejor sistema de seguimiento de solicitantes para una contratación eficiente en 2025

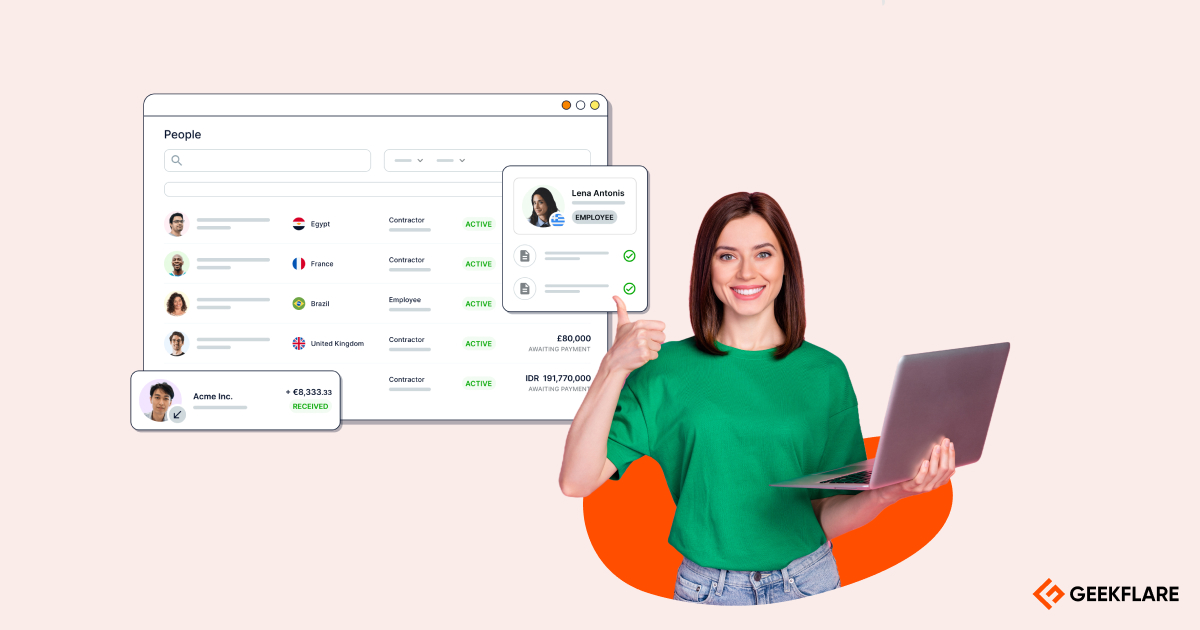

12 mejores software de gestión de RRHH para startups y empresas [2025]

Mejor software de nóminas en 2025

Fomente el compromiso de los clientes, mejore las relaciones y fidelice a sus clientes con un potente software CRM y con la ayuda de guías expertas.

13 mejores software CRM para la sanidad en 2025 [revisados]

Cómo los CRM potenciados por IA están revolucionando las ventas [2025]

Las 11 mejores herramientas CRM de IA para probar en 2025

13 mejores CRM jurídicos para bufetes y abogados

20 mejores programas de gestión de las relaciones con los clientes (CRM)

11 mejores CRM de Gmail para agilizar las relaciones con los clientes

Consolide la presencia online de su marca con herramientas estratégicas de marketing digital y SEO para poder analizar a la competencia, expandir su alcance, establecer contacto con los clientes e impulsar las ventas.

14 cursos de análisis de datos para hacer crecer su carrera

Las 22 mejores herramientas de YouTube para aumentar la audiencia, los ingresos y mucho más

5 herramientas de análisis de vídeo basadas en IA para un mejor análisis de los medios de comunicación

las 12 mejores herramientas para los hilos de Twitter que se harán virales en 2025

Las mejores redes CPA para afiliados en 2025 para obtener los máximos pagos

Los mejores raspadores de redes sociales para extraer datos valiosos en 2025

Aprenda las mejores estrategias para aumentar los ingresos de ventas. Con nuestro software seleccionado, aumente las tasas de conversión, mejore el rendimiento de las ventas y perfeccione su embudo de marketing con soluciones novedosas y rentables.

13 mejores software de embudos de ventas para aumentar las conversiones

Revisión de HighLevel: ¿Es una herramienta de marketing asequible?

las 18 mejores herramientas de LinkedIn con IA para maximizar su alcance y sus ventas 🚀

8 mejores sistemas de optimización de precios para empresas [2025]

¿Qué es la puntuación de clientes potenciales? Beneficios, tipos y mejores prácticas

los 12 mejores software de previsión de ventas en 2025

Blinde a su empresa frente a los ataques cibernéticos con nuestra investigación experta y recomendación de software de ciberseguridad, buenas prácticas para usar y las técnicas.

Certificación CISSP: Todo lo que necesita saber

11 podcasts de ciberseguridad para mantenerse a la vanguardia en el mundo de las amenazas digitales

9 soluciones de seguridad del correo electrónico para protegerse de los ataques de spam, suplantación de identidad y phishing

las 9 mejores herramientas antiphishing para empresas en 2025

El mejor escáner de malware de sitios web para encontrar riesgos de seguridad

11 Herramientas de ataque de fuerza bruta para pruebas de penetración

17 Mejor software de cortafuegos de aplicaciones web [Selección de los mejores]

13 Mejores Herramientas GRC para Gestionar el Riesgo y el Cumplimiento

12 mejores escáneres de URL para comprobar si un enlace es seguro

¿Cómo asegurar Docker para un entorno de producción?

Pruebe la seguridad de su navegador en busca de vulnerabilidades

¿Qué es el «skimming» de tarjetas de crédito y cómo protegerse?

9 herramientas gratuitas en línea para certificados SSL/TLS

los 26 programas de recompensas por fallos mejor remunerados del mundo

¿Cómo encontrar subdominios de un dominio en cuestión de minutos?

8 Escáner de seguridad de Joomla para encontrar vulnerabilidades y errores de configuración

Cómo averiguar qué WAF está protegiendo un sitio web

17 Mejor software de cumplimiento y gestión de riesgos

Aprenda a protegerse en el mundo digital utilizando los mejores antivirus, antiespías, herramientas de privacidad y VPN para garantizar la seguridad de su identidad en línea y de sus dispositivos.

los 10 mejores generadores de correo electrónico temporal para evitar el spam

El mejor software antivirus para empresas en 2025

10 servicios proxy ISP que debe utilizar ahora mismo

Los mejores navegadores antidetección: Los más elegidos para 2025

Los 11 mejores navegadores proxy para mejorar la privacidad en Internet

Los mejores servicios proxy baratos en 2025

Descubra cómo elegir los proveedores de alojamiento y en la nube más adecuados para los sitios web y las aplicaciones de su empresa, de modo que se garantice la fiabilidad y un funcionamiento óptimo.

13 mejores proveedores de alojamiento de correo electrónico empresarial para una excelencia eficiente del correo electrónico

15 mejores servicios de alojamiento wiki en 2025

12 mejores proveedores de alojamiento compartido en 2025

13 mejores proveedores de alojamiento Node.js [Revisado]

7 mejores soluciones wiki autoalojadas para pequeñas y grandes empresas

las 10 mejores plataformas de alojamiento de aplicaciones Python